XiaoMi-AI文件搜索系统

World File Search System基于事件流的视觉对象跟踪-CVF打开访问

以生物风格的活动相机跟踪近年来引起了人们的兴趣。现有的作品要么利用对齐的RGB和事件数据进行准确跟踪,要么直接学习基于事件的跟踪器。前者会产生较高的推理成本,而后者可能容易受到嘈杂事件或稀疏空间分辨率的影响。在本文中,我们提出了一个新型的分层知识蒸馏框架,该框架可以在培训期间完全利用多模式 /多视图信息,以促进知识转移,使我们能够仅使用事件信号来实现测试过程中高速和低潜伏期视觉跟踪。特别是,基于教师变压器的多模态跟踪框架首先是通过同时喂食RGB框架和事件流来训练的。然后,我们设计了一种新的分层知识蒸馏策略,其中包括成对相似性,功能表示和基于响应地图的知识蒸馏,以指导学生变形金刚网络的学习。在术语中,由于现有的基于事件的跟踪数据集都是低分辨率(346×260),因此我们提出了名为EventVot的第一个大规模高分辨率(1280×720)数据集。它包含1141个视频,并涵盖了许多类别,例如行人,车辆,无人机,乒乓球等。对低分辨率(Fe240Hz,Vi-Sevent,Coesot)和我们新提出的高分辨率EventVot数据集的进行了实验进行了实验

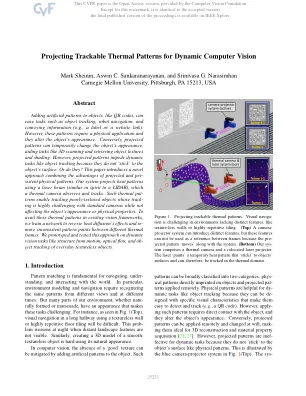

投影动态计算机视觉的可跟踪热图案

将人造模式添加到QR码之类的对象中可以简化诸如对象跟踪,机器人导航和传达信息(例如标签或网站链接)之类的任务。但是,这些模式需要物理应用,它们会改变对象的外观。相反,投影模式可以暂时更改对象的外观,协助3D扫描和检索对象纹理和阴影等任务。但是,投影模式会阻碍动态任务,例如对象跟踪,因为它们不会“粘在对象的表面上”。还是他们?本文介绍了一种新颖的方法,结合了预测和持久的物理模式的优势。我们的系统使用激光束(精神类似于激光雷达)进行热模式,热摄像机观察和轨道。这种热功能可以追踪纹理不佳的物体,其跟踪对标准摄像机的跟踪极具挑战性,同时不影响对象的外观或物理特性。为了在现有视觉框架中使用这些热模式,我们训练网络以逆转热扩散的效果,并在不同的热框架之间移动不一致的模式点。我们在动态视觉任务上进行了原型并测试了这种方法,例如运动,光流和观察无纹理的无纹理对象的结构。

增强具有生成负面挖掘的视觉语言模型的多模式组成推理

当代的大规模视觉语言模型(VLM)具有强大的表示能力,使它们无处不在,可以增强图像和文本理解任务。他们经常以对比的方式受到大量图像和相应的文本字幕的对比方式进行训练。尽管如此,VLMS经常在构图推理任务上挣扎,这些任务对对象及其属性的复杂相互作用进行了精细的了解。此失败可以归因于两个主要因素:1)对比的方法传统上专注于从现有数据集中开采负面示例。但是,该模型可能不难区分阳性检查。替代采矿的替代方法是负样本2),但现有的生成方法主要集中于生成与给定图像相关的硬性负面文本。在另一个方向上进行挖掘,即生成与给定文本相关的负面图像样本已被忽略。为了克服这两种限制,我们提出了一个框架,不仅在两个方向上矿山,而且在这两种方式(即图像和文本)中产生了有挑战性的负面样本。利用这些生成硬性负样本,我们在涉及多模式综合推理的任务中显着提高了VLMS的性能。我们的代码和数据集在https://ugorsahin.github.io/enhancing-- vlm.html上发布。

语言模型的视觉检查

学习建模字符串之间的关系的学习是什么教授大型语言模型(LLMS)关于Vi-Sual世界的?我们系统地评估了LLMS生成和识别出增加复杂性的各种视觉概念的能力,然后演示如何使用文本模型来培训预先的视觉表示学习系统。由于语言模型缺乏将视觉信息作为像素消耗或输出视觉信息的能力,因此我们使用代码来表示研究中的图像。尽管LLM生成的图像看起来不像自然图像,但图像产生的结果以及模型校正这些固定图像的能力表明,字符串的精确建模可以教授有关Vi-Sual World的许多方面的语言模型。此外,使用文本模型生成的图像进行了自我监督的视觉表示学习的实验,突出了能够训练能够使用LLMS对自然IM的语义评估进行训练视觉模型的潜力。

计算机视觉 / ML工程师实习生< / div>

理想的候选人将具有强大的背景:计算机科学,机械工程,电气工程,生物医学工程或相关领域。如果有兴趣,候选人将暴露于从头开始发展初创公司的各个方面(R&D,光学系统集成和原型化)。工作将主要在我们的马里兰州哥伦比亚办事处进行。工资与经验相称(至少$ 17/hr)。我们的紧密联系的团队很高兴欢迎有才华的申请人并一起发展我们的冒险!

适应植物表型的视觉基础模型

基础模型是对大量数据进行预训练的大型模型。通常可以以最小的努力来适应各种下游任务。但是,由于基础模型通常是在从互联网中提出的图像或文本上进行预培训的,因此它们在植物表型等植物域中的性能受到质疑。此外,完全调整基础模型是耗时的,需要高计算能力。本文研究了植物表型设置和任务的基础模型的有效适应。我们对三个基础模型(MAE,Dino和Dinov2)进行了大量实验,对三个必需的植物表型任务:叶子计数,实例阶段和疾病分类。特别是,预先训练的骨干被冷冻,同时评估了两种不同的调整方法,即适配器调整(使用lora)和解码器调整。实验结果表明,基础模型可以充分地适应植物表型任务,从而产生与针对每个任务的最先进的模型(SOTA)模型相似的性能。尽管在不同任务上表现出很高的传递能力,但在某些情况下,精细调整的基础模型的表现比SOTA任务特定的模型稍差,这需要进一步研究。

shvit:带有内存有效宏设计的单头视觉变压器

最近,有效的视觉变压器表现出出色的性能,并且在资源受限的范围内延迟较低。通常,他们在宏观水平上使用4×4贴片嵌入式和4阶段结构,同时在微观级别利用多头配置的同时注意力。本文旨在解决记忆效率高的人中所有设计级别的计算重复。我们发现,使用较大的修补茎不仅降低了内存访问成本,而且还通过利用令牌表示,从早期阶段降低了空间冗余,从而实现了态度性能。fur-hoverore,我们的初步分析表明,在早期阶段的注意力层可以用会议代替,并且后期阶段的几个注意力头在计算上是多余的。为了处理这一点,我们介绍了一个单头注意模块,该模块固有地预先预先冗余,并同时通过相结合的全局和本地信息来提高准确性。在解决方案的基础上,我们引入了Shvit,这是一种单头视觉变压器,获得了最先进的速度准确性权衡。例如,在ImagEnet-1k上,我们的SHVIT-S4在GPU,CPU和iPhone12移动设备上比MobileVitV2×1.0快3.3×,8.1×和2.4倍,而同时更准确。用于使用Mask-RCNN头对MS Coco进行的对象检测和实例分割,我们的模型分别在GPU和移动设备上表现出3.8×和2.0×下骨架潜伏期时,可以与FastVit-SA12进行比较。

应用机器学习和计算机视觉方法确定

摘要。研究相关性是由在难以到达条件下改善对象大小的测量过程的需要决定的。在现代工业环境中,高测量精度对于确保安全和最大化生产过程的效率至关重要,对该主题的研究在快速技术发展和提高生产质量要求的背景下是相关的。该研究旨在评估使用现代计算机视觉方法在困难的技术条件下测量和重建对象的可能性,例如水 - 水功率反应堆的封闭。该研究采用了3D摄影测量方法,包括立体声和多视图立体声的深度,以及运动方法的结构。研究确定,现代计算机视觉方法,特别是机器学习方法,可以成功地用于在难以到达的条件下测量和重建对象。研究表明,在理想条件下,从测量设备到对象的测量精度可以达到接近1 mm的值。同时,与立体声方法的深度相比,多视图立体法揭示了误差的空间分布更大的均匀性。在实践中,在真实照片的条件下,多视图立体声方法最需要准确地确定相机的位置。由于其对摄像机确切坐标的需求较低,立体声方法的深度显示出更好的结果,显示出较小的测量误差。这项研究强调了使用所提出的方法区分

在Knauf革命性的质量检查与视觉AI

knauf绝缘材料进行了数字化转换,以使用AI驱动的解决方案来增强其质量检查过程。,他们面临着耗时且容易出现人为错误的手动检查过程的挑战。一项试点计划测试了视觉AI系统,该系统后来成功部署了生产线,从而产生了更高质量的产品,并通过自动化提高了效率。持续的评估和迭代对于将系统提炼和改进为成功的解决方案至关重要,从而降低成本并提高客户满意度。