机构名称:

¥ 1.0

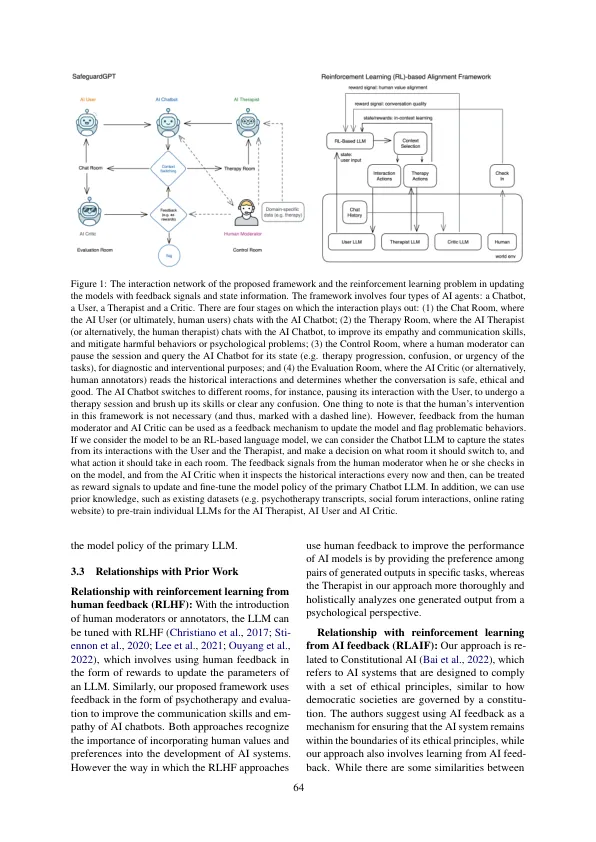

大型语言模型 (LLM) 的最新进展促成了功能强大的聊天机器人的开发,这些聊天机器人能够进行流畅的类人对话。然而,这些聊天机器人可能是有害的,表现出操纵、煤气灯效应、自恋和其他毒性。为了实现更安全、更适应的模型,我们提出了一个使用心理疗法来识别和缓解有害聊天机器人行为的框架。该框架涉及四个不同的人工智能 (AI) 代理:需要调整行为的聊天机器人、用户、治疗师和评论家,它们可以与基于强化学习的 LLM 调整配对。我们用一个涉及四个 ChatGPT 实例的社交对话的工作示例来说明该框架,表明该框架可以减轻 LLM 驱动的聊天机器人与人之间对话中的毒性。尽管未来仍有几个挑战和方向需要解决,但提出的框架是改善法学硕士与人类价值观之间一致性的一种有前途的方法。

大型语言模型也需要治疗师