机构名称:

¥ 1.0

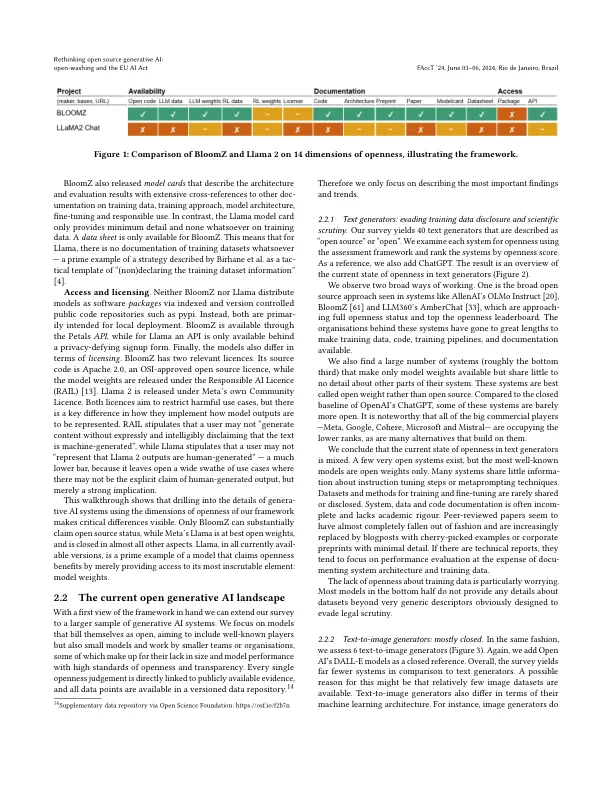

过去一年,声称开放的生成式人工智能系统急剧增加。但它们到底有多开放?鉴于即将出台的欧盟人工智能法案对开源系统进行了不同的监管,生成式人工智能中什么算作开源的问题将变得尤为重要,迫切需要进行实际的开放性评估。在这里,我们使用了一个基于证据的框架,该框架区分了开放性的 14 个维度,从训练数据集到科学和技术文档,从许可到访问方法。通过调查 45 多个生成式人工智能系统(包括文本和文本到图像),我们发现虽然开源一词被广泛使用,但许多模型充其量只是“开放权重”,许多提供商试图通过隐瞒有关训练和微调数据的信息来逃避科学、法律和监管审查。我们认为,生成式人工智能的开放性必然是复合的(由多个元素组成)和梯度的(以度为单位),并指出依赖访问或许可等单一特征来宣布模型是否开放的风险。基于证据的开放性评估有助于培育生成性人工智能格局,在该格局中,模型可以得到有效监管,模型提供者可以被追究责任,科学家可以仔细审查生成性人工智能,最终用户可以做出明智的决策。

开放式清洗和欧盟人工智能法案