机构名称:

¥ 2.0

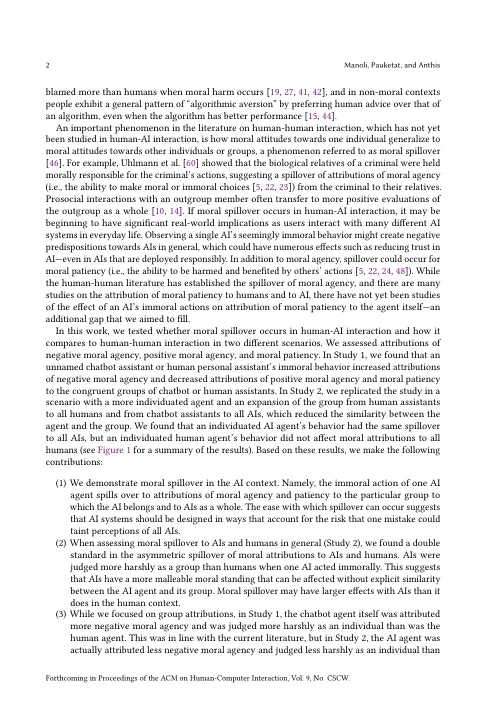

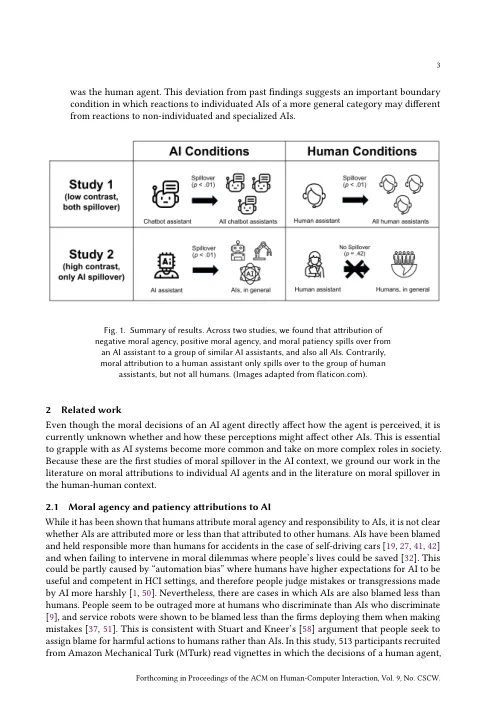

机器人和其他人工智能 (AI) 系统被广泛视为对其行为负责的道德主体。随着人工智能的普及,这些看法可能会通过对一个人工智能的态度对其他人工智能的态度的道德溢出而纠缠在一起。我们在两个预先注册的实验中测试了人工智能或人类主体看似有害和不道德的行为如何影响对其他人工智能或人类的态度。在研究 1 (N = 720) 中,我们通过表明不道德的行为增加了对主体(聊天机器人或人类助手)及其所属群体(所有聊天机器人或人类助手)的负面道德主体(即不道德行为)的归因并减少了对主体(聊天机器人或人类助手)及其所属群体(所有聊天机器人或人类助手)的积极道德主体(即道德行为)和道德耐心(即值得道德关注)的归因,建立了人机交互中的道德溢出效应。人工智能和人类环境之间的溢出效应没有显着差异。在研究 2(N = 684)中,我们测试了当代理被赋予一个名字并被描述为人工智能或人类,而不是具体描述为聊天机器人或个人助理时,溢出效应是否持续存在。我们发现溢出效应在人工智能环境中持续存在,但在人类环境中不存在,可能是因为人工智能由于其相对于人类的外群体地位而被认为更加同质化。这种不对称表明了一种双重标准,即当一个代理在道德上逾越时,人工智能会比人类受到更严厉的评判。随着多样化、自主的人工智能系统的激增,人机交互的研究和设计应该考虑到这样一个事实:对一种人工智能的体验很容易推广到对所有人工智能的看法,并产生负面的人机交互结果,例如信任度降低。

人类根据一个人的行为来评判所有人工智能