机构名称:

¥ 1.0

与基于人类的流程或传统软件一样,一些人工智能系统相当简单且易于解释,而另一些则复杂得多。可解释性是一个丰富的研究领域,它正在产生新的方法和工具,让我们深入了解人工智能系统为何以某种方式行事(即,图像的哪些部分触发了医疗诊断工具来识别疾病)。我们不应该错过使用人工智能提高决策透明度的机会,即使它不能完全解释。例如,对人类决策的解释可能无法准确反映其影响因素或无意识偏见。事实上,即使某些人工智能系统做出的每一个决定都无法完全解释,我们可能能够比理解人类如何做出类似决定更好地理解它们如何做出一般决策。

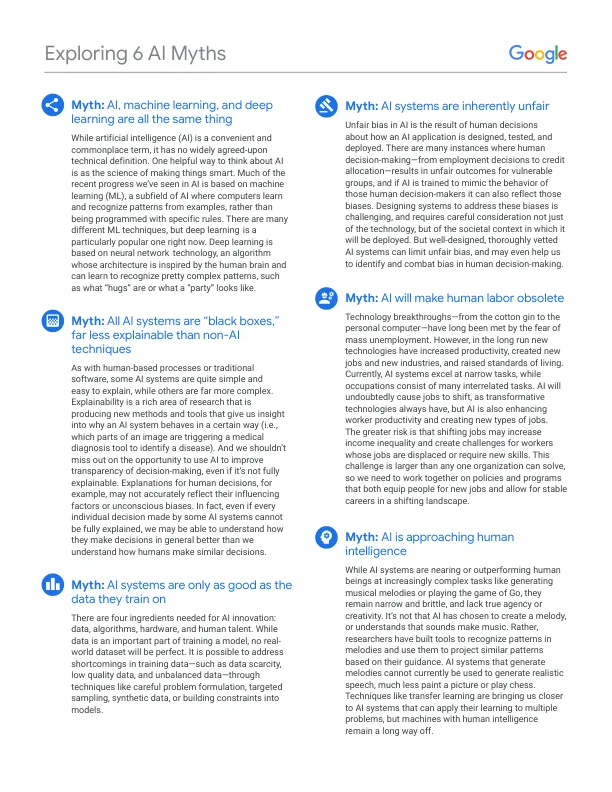

探索 6 个关于人工智能的迷思