机构名称:

¥ 1.0

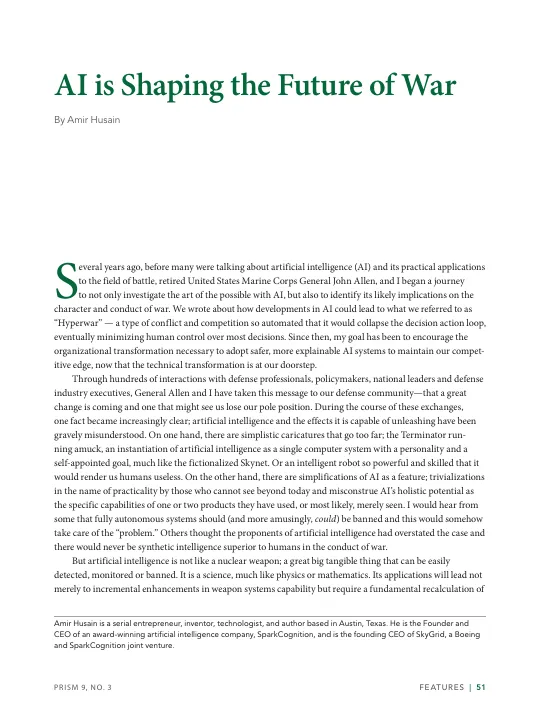

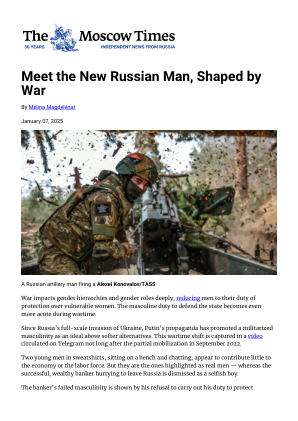

几年前,在许多人谈论人工智能 (AI) 及其在战场上的实际应用之前,我和美国海军陆战队退役将军约翰·艾伦 (John Allen) 开始了一段旅程,不仅要研究人工智能的可能性,还要确定其对战争性质和行为的可能影响。我们写了关于人工智能的发展如何导致我们所说的“超级战争”的文章——一种自动化程度极高的冲突和竞争,它将瓦解决策行动循环,最终最大限度地减少人类对大多数决策的控制。从那时起,我的目标就是鼓励组织转型,采用更安全、更可解释的人工智能系统来保持我们的竞争优势,现在技术转型已经迫在眉睫。通过与国防专业人士、政策制定者、国家领导人和国防工业高管的数百次互动,艾伦将军和我向我们的国防界传达了这一信息——一场大变革即将到来,我们可能会失去领先地位。在这些交流过程中,一个事实变得越来越清晰:人工智能及其可能释放的影响一直被严重误解。一方面,有些过于简单的漫画形象过于夸张;终结者横行无忌,人工智能被实例化为一个具有个性和自我指定目标的单一计算机系统,就像虚构的天网一样。或者一个如此强大和熟练的智能机器人,它会让我们人类变得毫无用处。另一方面,有些人工智能被简化为一个功能;那些看不到今天以外的人以实用性的名义将其简单化,将人工智能的整体潜力误解为他们使用过或很可能只是见过的一两种产品的特定功能。我从一些人那里听说,完全自主系统应该(更有趣的是,可以)被禁止,这将以某种方式解决“问题”。其他人认为人工智能的支持者夸大了事实,在战争中永远不会有比人类更优越的合成智能。但人工智能不像核武器;一个可以轻易检测、监控或禁止的巨大有形的东西。它是一门科学,很像物理学或数学。它的应用不仅会导致武器系统能力的逐步增强,而且需要从根本上重新计算

人工智能正在塑造战争的未来

主要关键词