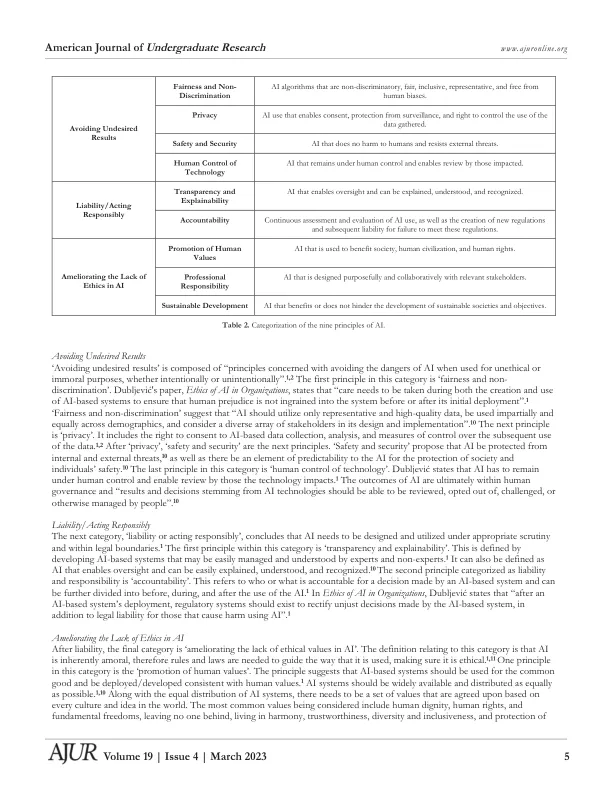

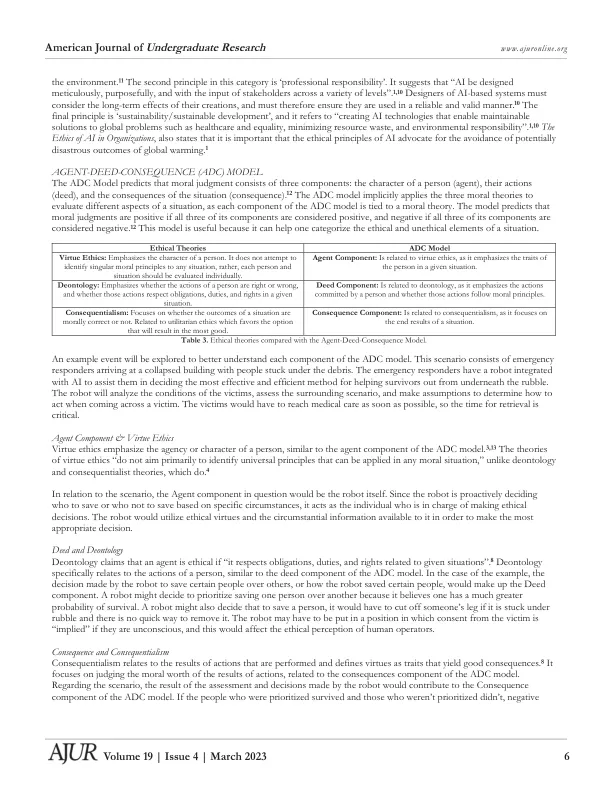

社会中的人工智能伦理 Emma Johnson* a、Eloy Parrilla a 和 Austin Burg b a 北卡罗来纳州立大学工程学院工业与系统工程系,北卡罗来纳州罗利市 b 北卡罗来纳州立大学工程学院计算机科学系,北卡罗来纳州罗利市 https://doi.org/10.33697/ajur.2023.070 学生:ekjohns3@ncsu.edu*、ehparril@ncsu.edu、acburg@ncsu.edu 导师:Chang S. Nam,csnam@ncsu.edu 摘要 随着新技术每天都向公众展示,并旨在将其融入社会,人工智能 (AI) 变得越来越普遍。然而,这些系统并不完美,并且已知会导致影响众多人的故障。本研究旨在探索人工智能在社会设计和实施过程中如何遵循道德准则。研究了三种伦理理论、九项人工智能伦理原则以及代理、行为、后果 (ADC) 模型,以分析涉及人工智能的失败。当系统未能遵循所列模型时,就会创建一套完善的道德原则。通过分析失败,我们了解了如何防止类似事件发生。此外,还展示了道德作为人工智能编程一部分的重要性,并提出了未来将道德纳入人工智能的建议。由于涉及人工智能的事件发生的性质,整篇论文都特别使用了“失败”一词。这些事件不一定是“意外”,因为人工智能本来就是以某种方式行动的,但这些事件也不是“故障”,因为人工智能示例内部并未受到损害。出于这些原因,使用了含义更广的术语“失败”。关键词 伦理;人工智能;代理-行为-后果 (ADC) 模型;人工智能原则;美德伦理;义务论;结果主义;人工智能系统 简介 人工智能 (AI) 在社会中越来越普遍。随着其影响力越来越大,了解如何避免 AI 缺陷对于未来开发高质量应用程序至关重要。详细介绍了与 AI 相关的三个当代失败和故障示例。分析了这些示例与 AI 中的伦理原则、三种伦理理论和代理行为后果模型 (ADC 模型) 的关系。讨论和分析将有助于更好地理解 AI 中的伦理,并提供有用的社会应用。在整个研究过程中,我们确定了每次故障是如何发生的,以及将来如何防止故障。提出了一个由多个步骤组成的系统,旨在确保人工智能系统保持合乎道德规范。希望这个模型能够让人们更好地理解人工智能犯错的原因,以便让知识带来更好的结果并防止人工智能故障。方法和程序 对集成人工智能的产品的需求日益增长。这种需求带来了确保人工智能行为合乎道德的需要。人工智能是一个无需直接人工输入即可运行并完成指定任务的系统。1,2 这九项原则也与三种伦理理论的各个方面有关。由于人工智能不具备与人类相同的道德和伦理能力,因此人工智能总是有可能无意中违反道德界限。为了确定人工智能的行为是否合乎道德,我们探索了三种用于确定人类道德的伦理理论:美德伦理学、义务论和结果主义。此外,我们还使用了 Dubljeviý 提出的九项人工智能伦理原则,即“公平和非歧视”、“隐私、安全和保障”、“人类对技术的控制”、“透明度和可解释性”、“问责制”、“促进人类价值观”、“职业责任”和“可持续发展”。2 使用这些指南,对三起人工智能失败进行了案例研究,详细说明了它们如何违反人工智能中的特定伦理原则。进行了分析,以展示如何使用 ADC 模型在未来避免类似事件。伦理理论 研究了三种用于评估情况的伦理和道德的著名伦理理论。这三种理论是美德伦理学、义务论和结果主义。

社会中的人工智能伦理