机构名称:

¥ 6.0

无论使用风险监管的价值如何,将人工智能危害构建为风险都是一个有后果的选择。风险监管有其自身的政策包袱:一套在其他领域出现的工具和麻烦。风险监管倾向于试图解决技术问题,以便可以使用它,而不是考虑有时可能根本不适合使用它。风险监管最适用于可量化的问题,并难以量化危害。它可以将真正的政策决策伪装成技术决策。风险监管通常不是为了让受伤的人得到完整赔偿。通常用于管理人工智能系统的风险监管版本缺乏侵权责任的反馈回路。因此,首先选择使用风险监管会将法律引向一种特定的人工智能治理方法,这种方法会做出隐含的权衡,并带来可预见的缺陷。

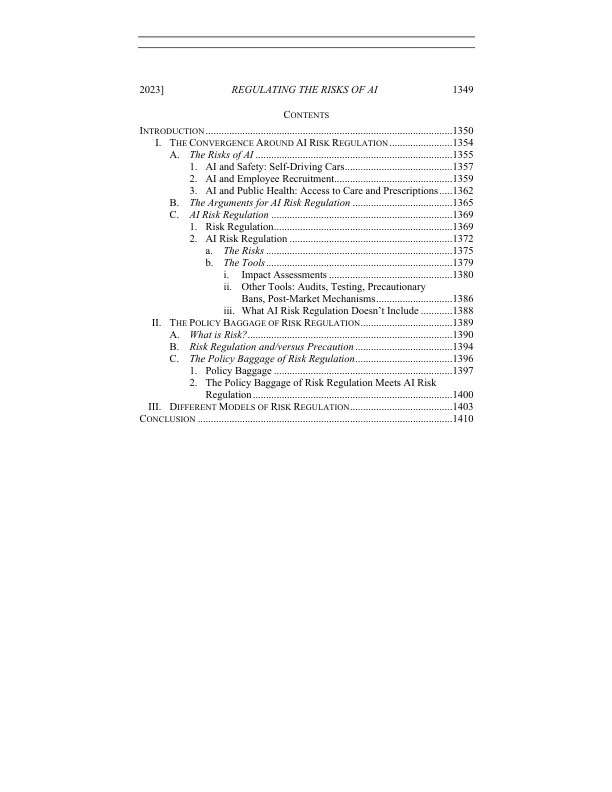

监管人工智能的风险