机构名称:

¥ 1.0

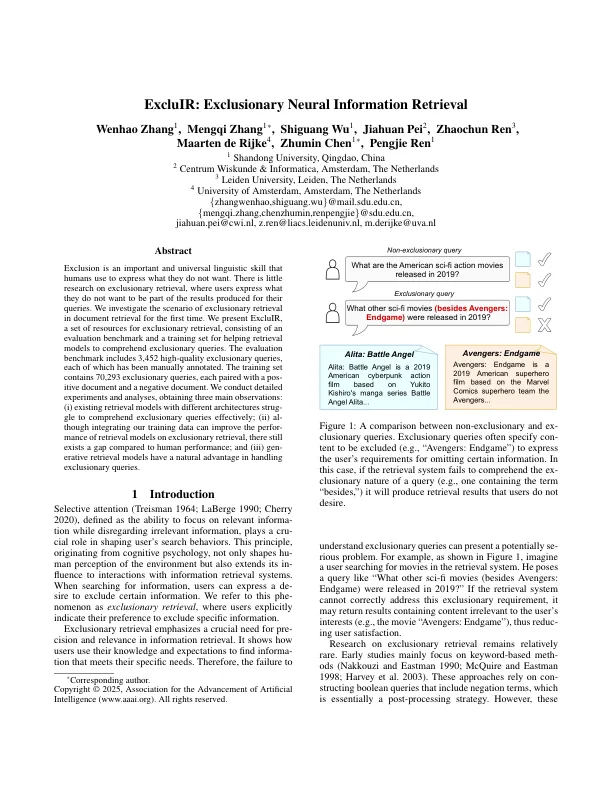

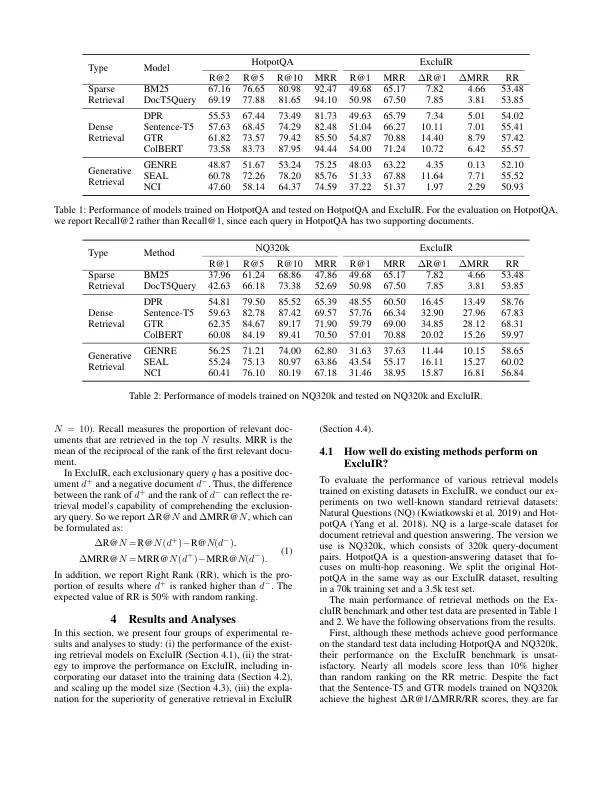

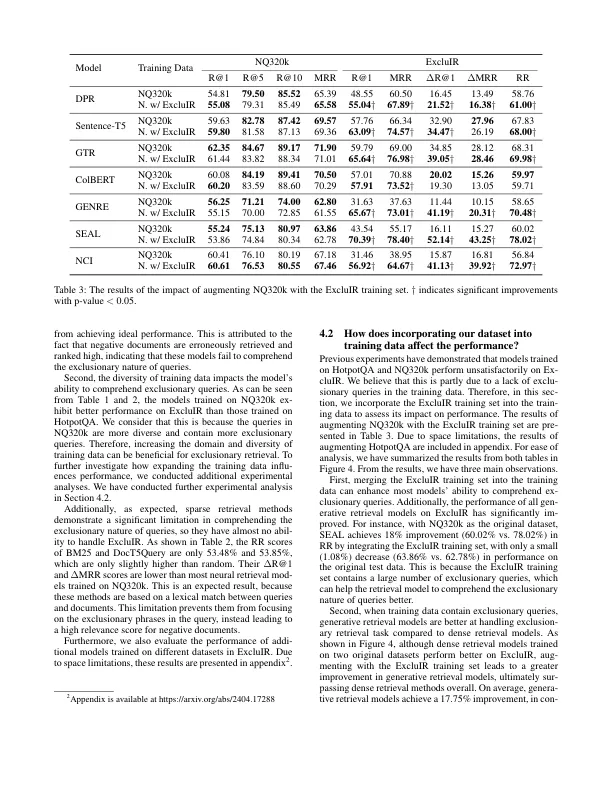

排除是人类用来表达自己不想要的重要性语言技能。几乎没有关于排他性检索的研究,用户表达了他们不想成为查询结果的一部分。我们首次研究了文件检索中排除检索的情况。我们提出了Dextuir,这是一套用于排除检索的资源,包括评估基准和培训集,用于帮助检索模型理解排除查询。评估基准包括3,452个高质量的排除查询,每个查询都已手动注释。该训练集包含70,293个排除查询,每个查询都与POSSIVE文档和负面文档配对。我们进行了详细的实验和分析,获得了三个主要观察结果:(i)现有的检索模型具有不同的结构,以有效地理解排他性查询; (ii)尽管整合我们的培训数据可以改善在排除检索方面的检索模型的表现,但与人类绩效相比,仍然存在差距; (iii)一般检索模型在处理排除查询方面具有自然优势。

独家:排除神经信息检索