机构名称:

¥ 1.0

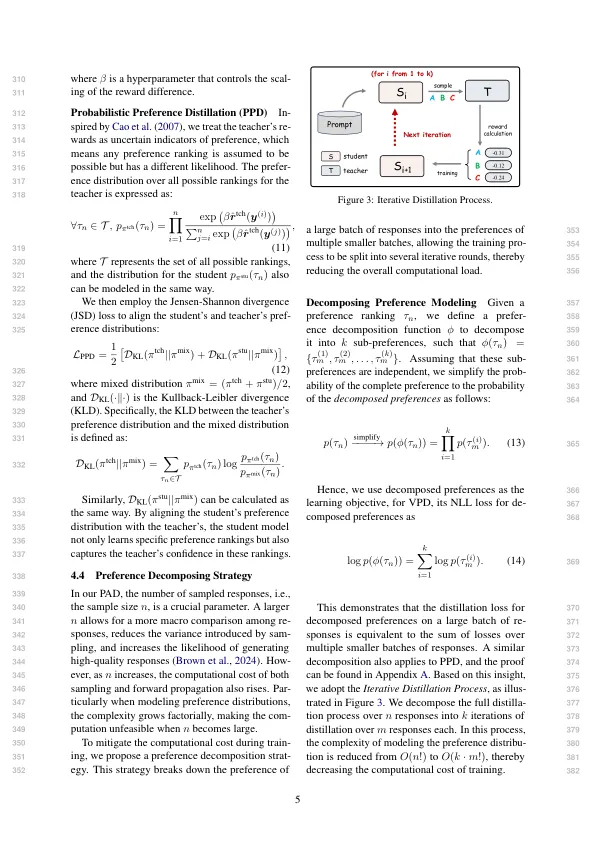

与SLMS相比,LLMS与人类偏好相比表现出Supe-050 Rior对齐(OpenAI,051 2024; Georgiev et al。,2024)。因此,ex-052 iSting Works llms作为教师提炼053偏好知识(Bai等人,054 2022; Cui等。,2023; Tunstall等。,2024; Wang 055等。,2024; Yuan等。,2024)。所有这些作品056模型在LLM中的模型偏好知识比较了成对响应。例如,Bai 058等。(2022)使用对059培训奖励模型的教师注释的响应,该奖励模型通过加强学习指导学生060。同样,Tunstall 061等。(2024)采用教师模型以偏爱-062 ence注释,但使用蒸馏的直接优先优化 - 064(Rafailov等人)直接优化了学生063模型(Rafailov等人。,2023)在注释数据集上。065然而,这些066“教师通知者”提供的监督信号采用订购067

小语言模型的偏好一致蒸馏

![强化学习:将人类的偏好纳入大语言模型的微调[0.4英寸] Avinash Kak Purdue University [0.1in]](/simg/3/3ede8a909d069d2cb8a5418bd2da44f8ba58e66e.webp)