机构名称:

¥ 1.0

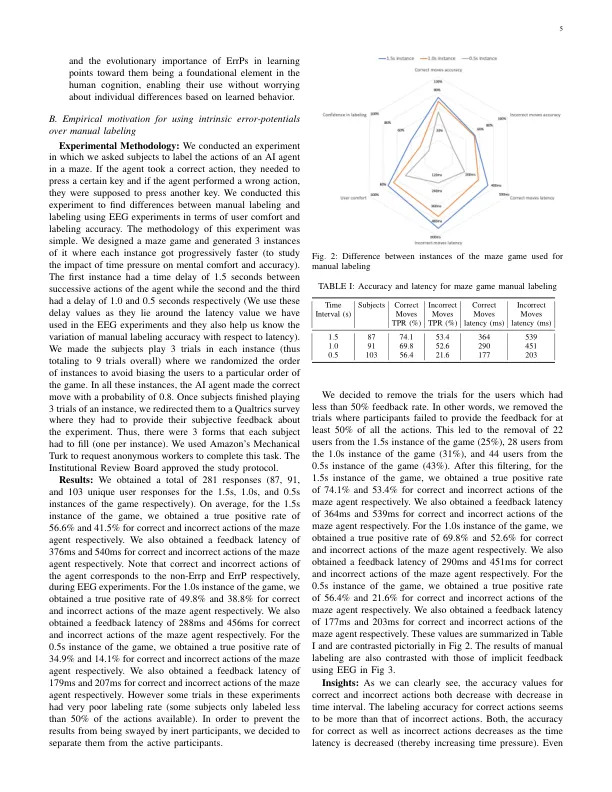

摘要 - 用人类反馈的提供强化学习(RL)代理可以极大地改善学习的各个方面。但是,以前的方法要求人类观察者明确地给出输入(例如,按钮,语音界面),在RL代理的学习过程的循环中为人提供负担。此外,不断提供明确的人类建议(反馈)并非总是可能或过于限制,例如自主驾驶,残疾人康复等。在这项工作中,我们以与错误相关电位的形式(ERRP)的形式调查了捕获人类的内在反应,作为隐式(和自然)的反馈,为人类提供了一种自然而直接的方式,使人类改善RL剂量的学习。因此,可以通过隐式反馈与RL算法进行整合,以加速RL代理的学习。我们开发了三个合理复杂的2D离散导航游戏,以实验评估拟议工作的整体绩效。和将ERR作为反馈的动机也通过主观实验来验证。我们工作的主要贡献如下,(i)我们提出并在实验中验证了错误的错误学习,其中一个游戏可以学习错误,并转移到其他未见的游戏中,(ii)我们提出了一个新颖的RL框架,以通过err rl and grouns and Spart和II,与II级别的人类相比,与人类的反馈相比,与人类的反馈相比,与II相比,与II相比,与II相比,与II相比,与II相比,与II相比,与Firical Inf(II I Iff)相比,与Firical Inf(IS)相比(将错误应用于合理复杂的环境,并通过真实的用户实验来证明我们的方法可以加速学习的重要性。

使用基于脑电图的隐式人类反馈

主要关键词