机构名称:

¥ 1.0

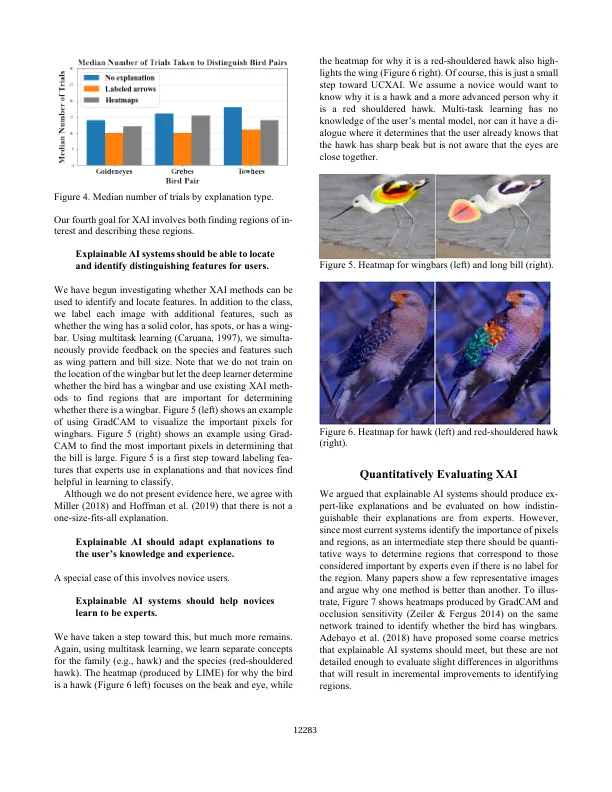

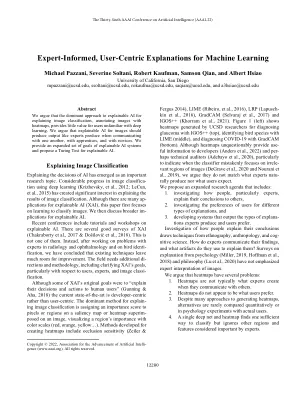

解释AI的决定已成为一个重要的研究主题。使用深度学习(Krizhevsky等,2012; Lecun等,2015)在图像分类方面取得了很大进展,对解释图像分类的结果产生了重大兴趣。尽管有许多可解释的AI(XAI)的信息,但本文首先着重于学习对图像进行分类。然后,我们讨论可解释AI的更广泛的信息。最近的会议包括有关可解释AI的教程和讲习班。XAI有几项好的调查(Chakraborty等人。,2017&došilović等,2018)。这不是其中之一。取而代之的是,在与放射学和眼科专家解决问题以及鸟类识别方面的问题之后,我们得出的结论是,现有的技术留出了很大的改进空间。该领域需要其他方案和方法,包括澄清XAI的目标,尤其是在用户,专家和图像分类方面。尽管Xai的一些最初目标是“向人类用户解释他们的决策和行动”(Gunning&Aha,2018),但最新的最新目前是以开发人员为中心的,而不是以用户为中心。解释图像分类的主要方法是将重要性得分分配给图像上的显着图或区域上的像素或区域,以形象化区域的重要性(红色,橙色,黄色…)。为创建热图开发的方法包括遮挡灵敏度(Zeiler&

机器学习的专家信息,以用户为中心的解释