机构名称:

¥ 1.0

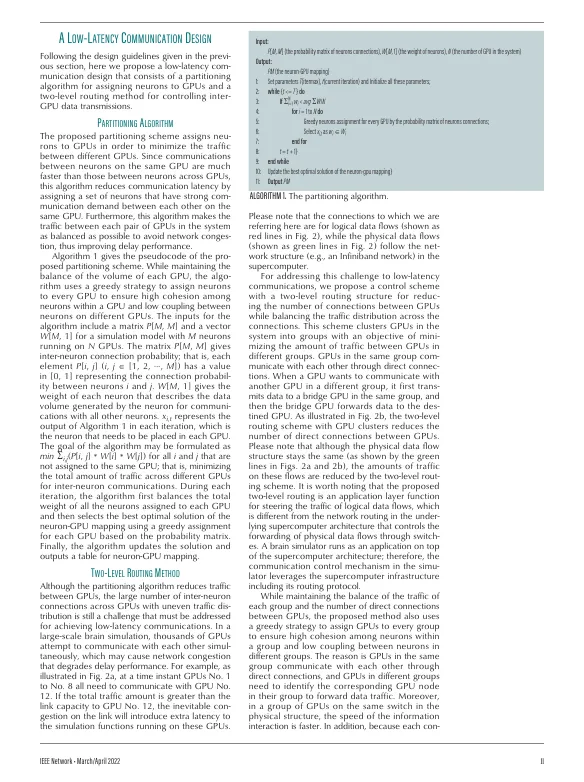

摘要 大脑模拟作为人工智能领域的最新进展之一,有助于更好地理解信息在大脑中的表达和处理方式。人类大脑的极端复杂性使得大脑模拟只有在高性能计算平台上才可行。目前,用于支持大脑模拟的超级计算机具有大量互连的图形处理单元(GPU)。因此,超级计算机中的高吞吐量低延迟 GPU 间通信对于满足大脑模拟这一高度时间敏感的应用的性能要求起着至关重要的作用。在本文中,我们首先概述了当前使用多 GPU 架构进行大脑模拟的并行化技术。然后,我们分析了大脑模拟通信面临的挑战,并总结了应对这些挑战的通信设计指南。此外,我们提出了一种分区算法和一种两级路由方法,以实现多 GPU 架构中用于大脑模拟的高效低延迟通信。我们报告了在具有 2000 个 GPU 的超级计算机上模拟具有 100 亿个神经元的大脑模型(数字孪生大脑,DTB)的实验结果,以表明我们的方法可以显著提高通信性能。我们还讨论了尚待解决的问题,并确定了大脑模拟低延迟通信设计的一些研究方向。

用于大脑模拟的低延迟通信设计

主要关键词