机构名称:

¥ 1.0

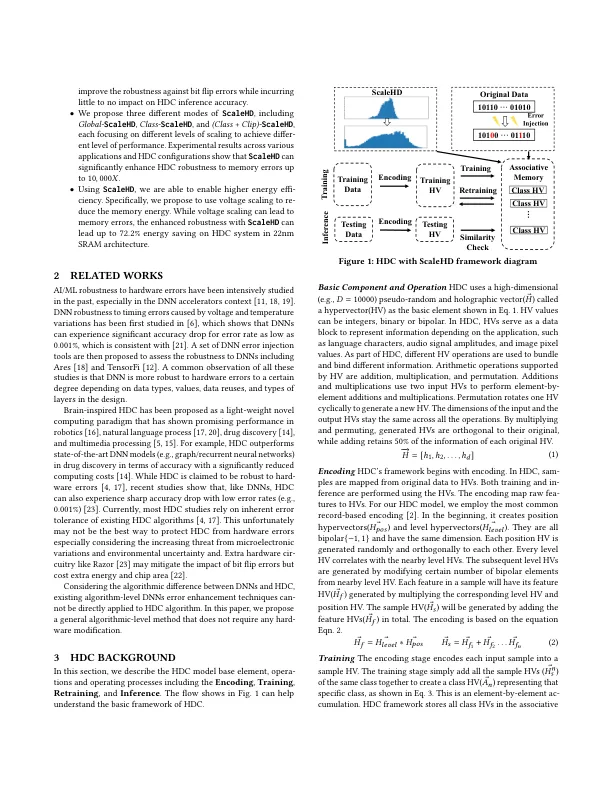

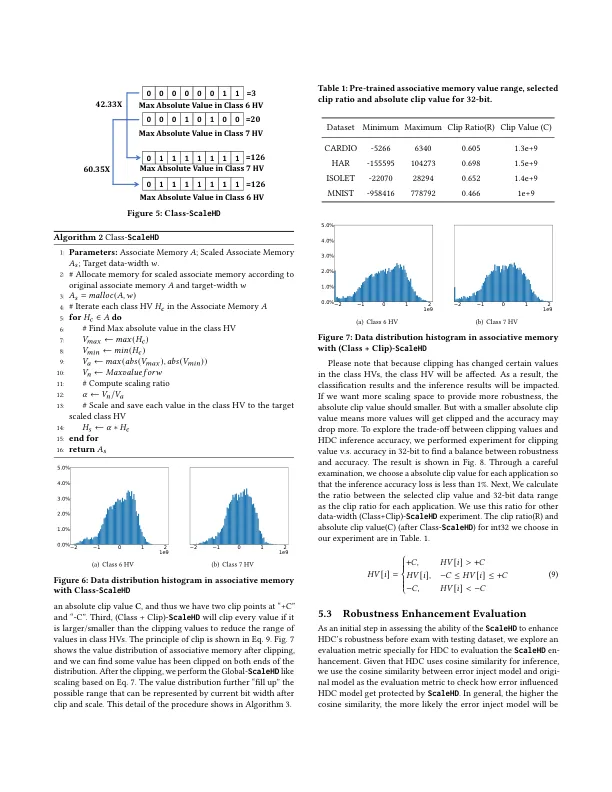

受大脑启发的超维计算 (HDC) 在机器人、生物医学信号分析和自然语言处理等各种认知任务中表现出良好的能力。与深度神经网络相比,HDC 模型具有轻量级模型和一次性/少次学习能力等优势,使其成为传统资源密集型深度学习模型的有前途的替代范式,尤其是在资源有限的边缘设备中。尽管 HDC 越来越受欢迎,但尚未对 HDC 模型的鲁棒性和增强 HDC 鲁棒性的方法进行系统分析和充分研究。HDC 依靠称为超向量 (HV) 的高维数值向量来执行认知任务,HV 中的值对于 HDC 模型的鲁棒性至关重要。我们提出了 ScaleHD,一种自适应缩放方法,可以缩放 HDC 模型的联想记忆中的 HV 值,以增强 HDC 模型的鲁棒性。我们提出了三种不同的ScaleHD模式,包括Global-ScaleHD、Class-ScaleHD和(Class+Clip)-ScaleHD,它们基于不同的自适应缩放策略。结果表明,ScaleHD能够将HDC对内存错误的鲁棒性提高到10,000𝑋。此外,我们利用增强的HDC鲁棒性,通过电压缩放方法节省能源。实验结果表明,ScaleHD可以将HDC内存系统的能耗降低高达72.2%,而准确度损失不到1%。

ScaleHD:通过自适应缩放实现强大的大脑启发式超维计算

主要关键词