机构名称:

¥ 1.0

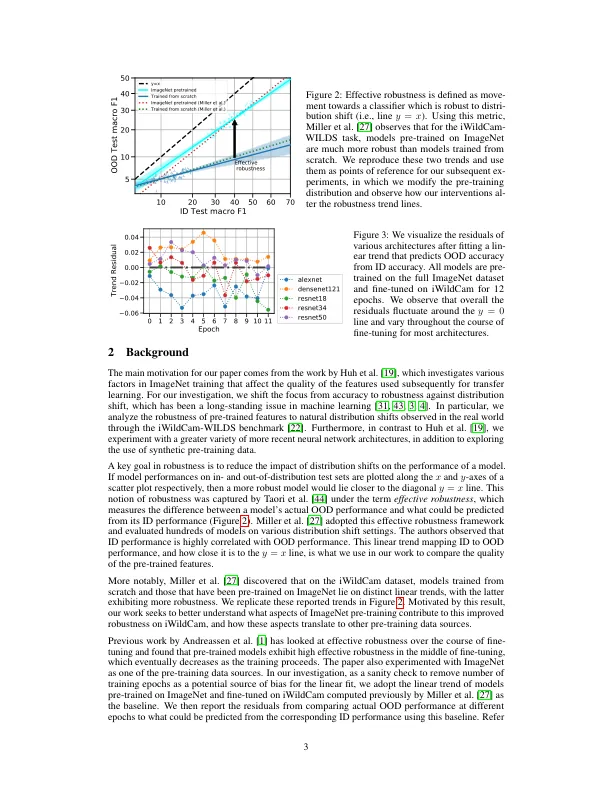

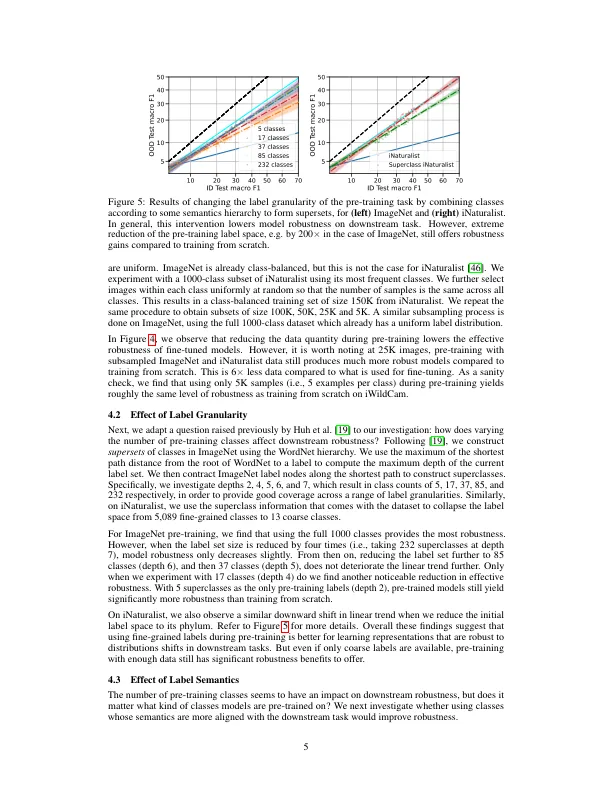

预训练已在深度学习中被广泛采用,以提高模型性能,特别是当目标任务的训练数据有限时。在我们的工作中,我们试图了解这种训练策略对下游模型泛化特性的影响。更具体地说,我们提出以下问题:预训练分布的属性如何影响微调模型的鲁棒性?我们探索的属性包括预训练分布的标签空间、标签语义、图像多样性、数据域和数据量。我们发现影响下游有效鲁棒性的主要因素 [44] 是数据量,而其他因素的重要性有限。例如,将 ImageNet 预训练类别的数量减少 4 倍,同时将每个类别的图像数量增加 4 倍(即保持总数据量固定)不会影响微调模型的鲁棒性。我们展示了从各种自然和合成数据源中提取的预训练分布的发现,主要使用 iWildCam-WILDS 分布转变作为稳健性测试。

论预训练数据多样性与微调鲁棒性之间的联系