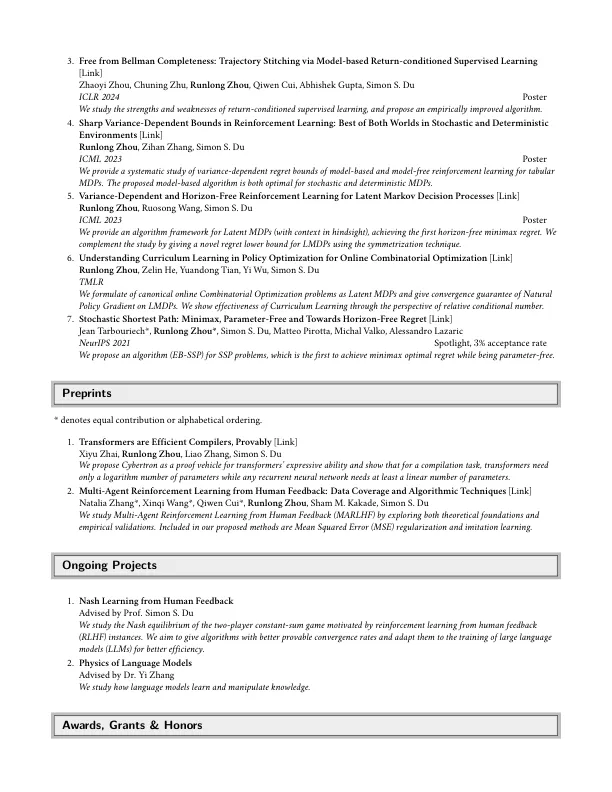

3。脱离Bellman的完整性:通过基于模型的返回条件的监督学习[链接] Zhaoyi Zhou,Chuning Zhu,Runlong Zhou,Qiwen Cui,Abhishek Gupta,Simon S. Du ICLR 2024 2024年海报我们研究了Al Al Al Al的长度和弱点。4。强化方差学习中的尖锐方差界限:在随机和确定性环境中两全其美[link] Runlong Zhou,Zihan Zhang,Simon S. Du ICML 2023海报我们提供了一个系统的研究研究,对基于模型和模型的强化学习的方差依赖性遗憾界限,用于制作模型和模型的增强范围。 提出的基于模型的算法既适用于随机和确定性MDP。 5。 潜在马尔可夫决策过程的依赖于方差的和无水平的加固学习[链接] Runlong Zhou,Ruosong Wang,Simon S. Du ICML 2023海报我们为潜在MDPS提供了算法框架(可见上下文),从而实现了第一台无线的最小值遗憾。 我们通过使用对称技术为LMDP提供了一种新颖的LMDP遗憾下限来补充这项研究。 6。 了解在线组合优化的政策优化中的课程学习[链接] Runlong Zhou,Zelin HE,Yuandong Tian,Yi Wu,Yi Wu,Simon S. DU TMLR我们制定了典范的在线组合优化问题,作为潜在的MDP,并为LMDPS的自然政策梯度提供了融合。 我们通过相对条件数的角度显示了课程学习的有效性。 7。强化方差学习中的尖锐方差界限:在随机和确定性环境中两全其美[link] Runlong Zhou,Zihan Zhang,Simon S. Du ICML 2023海报我们提供了一个系统的研究研究,对基于模型和模型的强化学习的方差依赖性遗憾界限,用于制作模型和模型的增强范围。提出的基于模型的算法既适用于随机和确定性MDP。5。依赖于方差的和无水平的加固学习[链接] Runlong Zhou,Ruosong Wang,Simon S. Du ICML 2023海报我们为潜在MDPS提供了算法框架(可见上下文),从而实现了第一台无线的最小值遗憾。我们通过使用对称技术为LMDP提供了一种新颖的LMDP遗憾下限来补充这项研究。6。了解在线组合优化的政策优化中的课程学习[链接] Runlong Zhou,Zelin HE,Yuandong Tian,Yi Wu,Yi Wu,Simon S. DU TMLR我们制定了典范的在线组合优化问题,作为潜在的MDP,并为LMDPS的自然政策梯度提供了融合。我们通过相对条件数的角度显示了课程学习的有效性。7。Stochastic Shortest Path: Minimax, Parameter-Free and Towards Horizon-Free Regret [Link] Jean Tarbouriech*, Runlong Zhou* , Simon S. Du, Matteo Pirotta, Michal Valko, Alessandro Lazaric NeurIPS 2021 Spotlight, 3 % acceptance rate We propose an algorithm (EB-SSP) for SSP problems, which is the first to achieve minimax optimal regret while无参数。

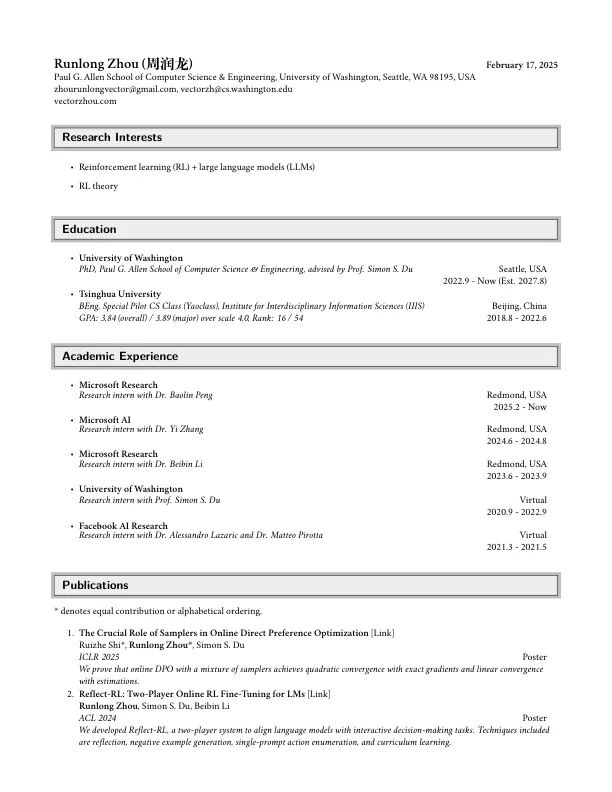

Runlong Zhou (周润龙)

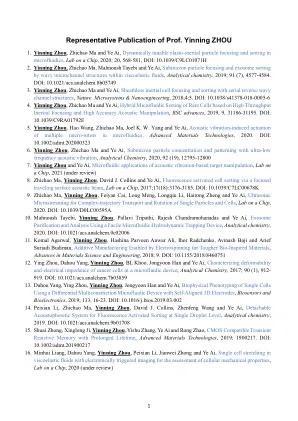

主要关键词