机构名称:

¥ 4.0

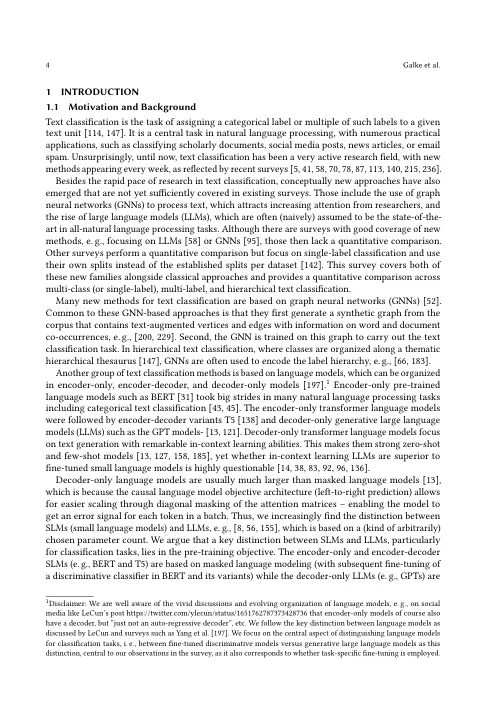

我们分析了跨知名数据集的单标签和多标签文本分类的各种方法,将其分类为单词袋,基于序列,基于图和层次结构的方法。尽管基于图的模型,但仅编码的预先训练的语言模型(尤其是BERT)仍然是最先进的方法。然而,最近的发现提出了更简单的模型,例如逻辑回归和基于Trigram的SVM的表现优于新技术。虽然仅解码的生成语言模型在学习有限的数据方面表现出了希望,但它们却落后于仅编码模型的性能。我们强调了歧视语言模型(例如BERT)比生成模型的优越性。此外,我们高度阐明了文献在方法比较中缺乏鲁棒性,尤其是关于基本的超参数优化,例如仅通过编码器的语言模型中的学习率。数据可用性:源代码可在https://github.com/drndr/multilabel-text-clf上找到。除NYT数据集外,用于我们实验的所有数据集均可公开使用。

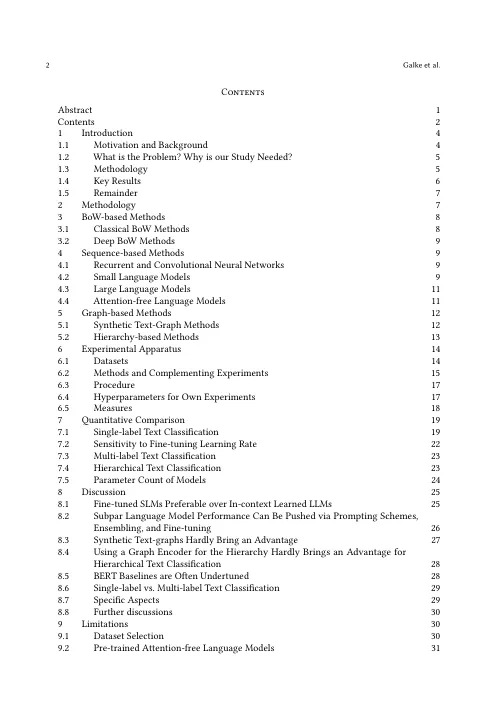

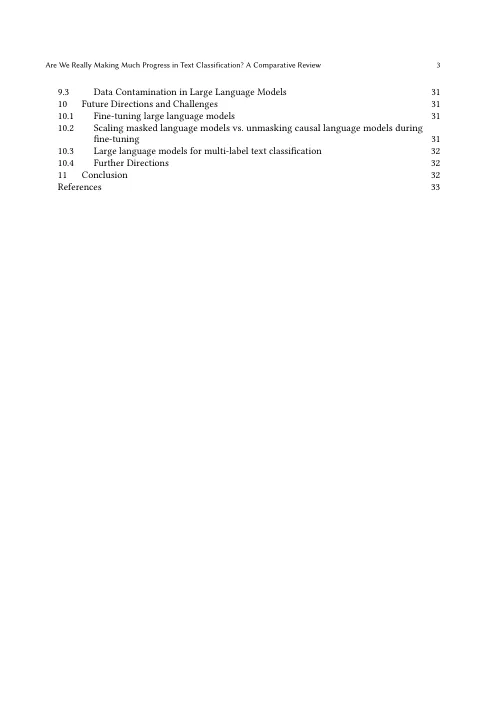

我们真的在文本分类方面取得了很大进展...

主要关键词