机构名称:

¥ 1.0

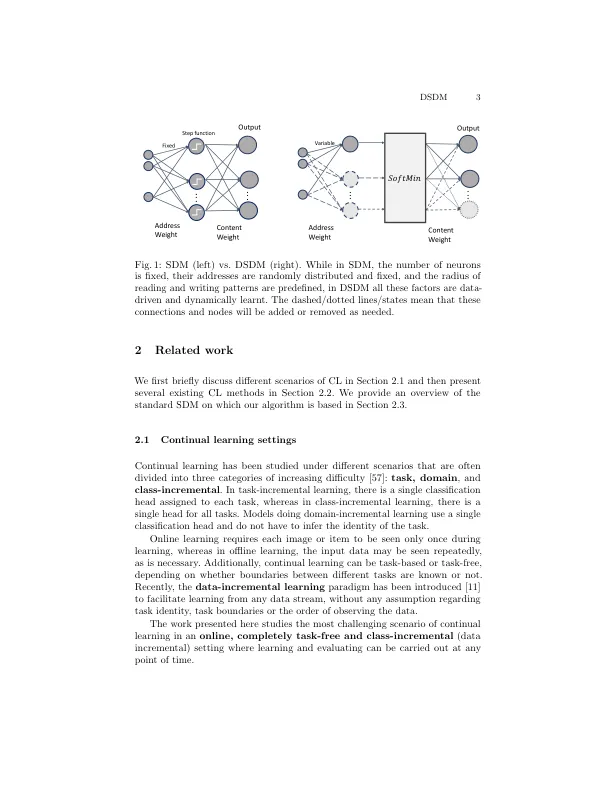

摘要。本文解决了在线无任务持续学习的一个非常具有挑战性的问题,其中仅使用每个样本一次培训一次,而在不了解任务边界的情况下,从非平稳数据中学习了一系列新任务。我们在本文中提出了一种有效的半分布的关联存储算法,称为动态稀疏分布式内存(DSDM),其中可以在任何时间点进行学习和评估。dsdm会动态发展,并不断建模任何非平稳数据流的分布。dsdm依赖于本地分布式,但仅部分重叠的表示形式群集有效消除了灾难性的遗忘,同时保持了分布式网络的概括能力。此外,使用基于局部密度的修剪技术来控制网络的内存足迹。dsdm在不同的图像分类基准中,即使在低数据状态下,DIV> DIV> DIV> DIV> DIV> DIV> DIV> DIV> DIV> DIV> DIV> DIV> DIV>。代码公开可用:https://github.com/julien-pour/dynamic-sparse-distributed-monem

结合缓解策略以增加生物多样性和粮食安全的共同利益

主要关键词