机构名称:

¥ 2.0

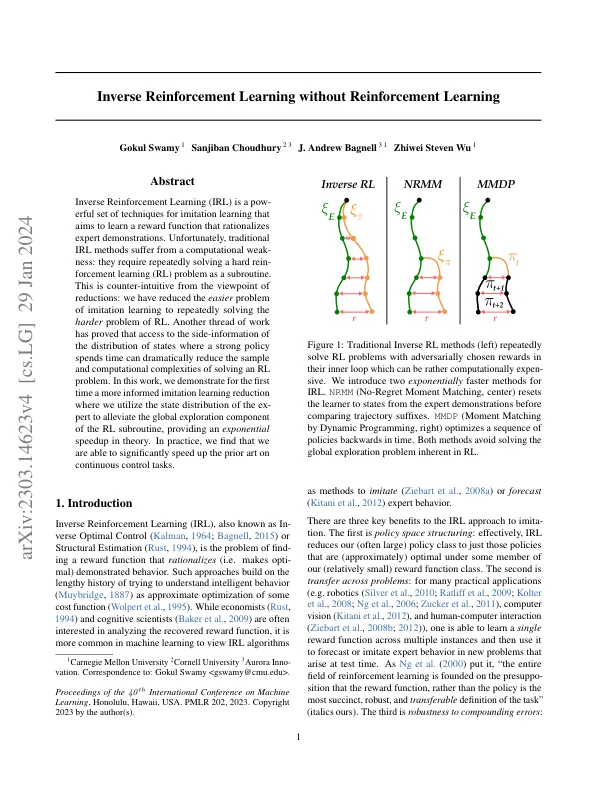

逆增强学习(IRL)是一组模仿学习的技术,旨在学习合理的专家演示的奖励功能。不幸的是,传统的IRL方法患有计算弱点:他们需要反复解决艰苦的执行学习(RL)问题作为子例程。从降低的角度来看,这是反直觉的:我们减少了模仿学习的更简单问题,以反复解决RL的更困难问题。另一个工作线索证明,访问强大政策花费时间的状态分布的侧面信息可以大大减少解决RL问题的样本和计算复杂性。在这项工作中,我们首次证明了更明智的模仿学习减少,我们利用了前面的状态分布来减轻RL子例程的全球勘探部分,从而提供了指数的速度。实际上,我们发现我们能够在连续的控制任务上显着加快先前的艺术。

漏洞检测的大型语言模型逆增强学习而无需加强学习

主要关键词