机构名称:

¥ 3.0

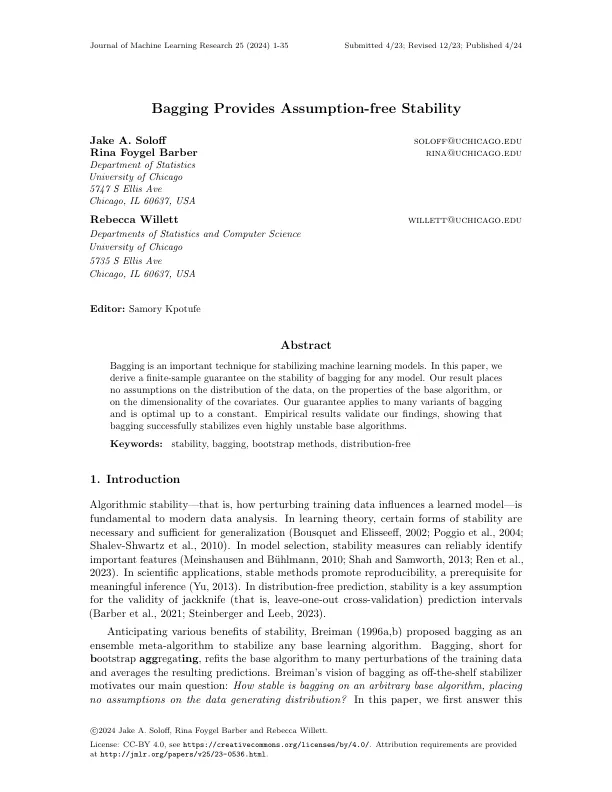

用于在SGD中绘制随机批次。我们的符号还允许确定性算法,因为A可以自由忽略输入参数ξ而仅取决于数据。有很多方法可以定义学习算法的稳定性。如Shalev-Shwartz等人所述。 (2010),稳定性的每一个定义都量化了训练集D的输出对小变化的敏感性,但它们都定义了“输出的敏感性”和“训练集中的小变化”。 我们介绍了两个定义稳定性的主要结果,并将结果扩展到第5.3节中的许多相关概念。 最强的可能性之一是,对于所有数据集和所有测试点,每个预测都不对删除任何单个观察结果不敏感。 以下定义与统一的预测稳定性密切相关(例如,参见Dwork和Feldman,2018年)。如Shalev-Shwartz等人所述。(2010),稳定性的每一个定义都量化了训练集D的输出对小变化的敏感性,但它们都定义了“输出的敏感性”和“训练集中的小变化”。我们介绍了两个定义稳定性的主要结果,并将结果扩展到第5.3节中的许多相关概念。最强的可能性之一是,对于所有数据集和所有测试点,每个预测都不对删除任何单个观察结果不敏感。以下定义与统一的预测稳定性密切相关(例如,参见Dwork和Feldman,2018年)。

包装提供无假设的稳定性

主要关键词