机构名称:

¥ 1.0

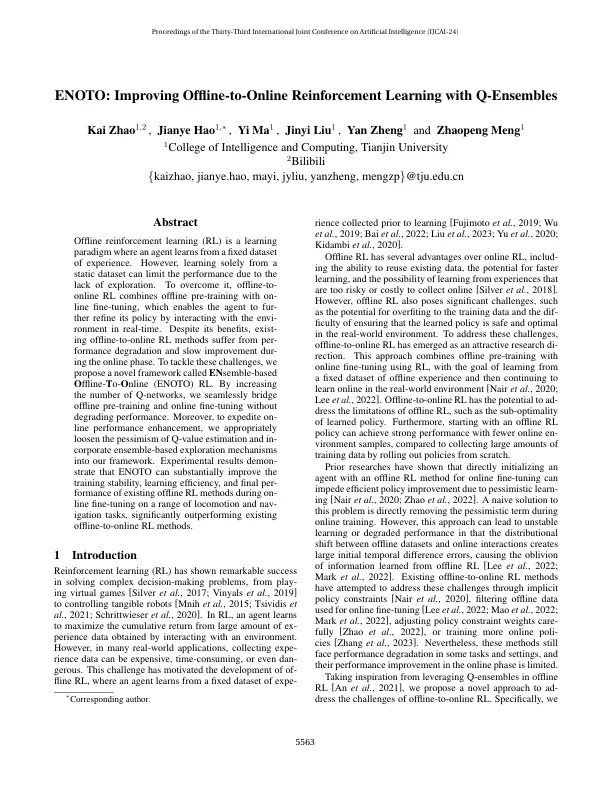

离线增强学习(RL)是一种学习范式,代理商从固定的经验数据集中学习。但是,仅从静态数据集中学习可以限制由于缺乏探索而限制性能。为了克服它,离线到在线RL将离线预训练与on-line-fielting结合在一起,这使代理商可以实时与环境进行互动,从而完善其政策。尽管有好处,但在线阶段的脱机RL方法中存在降解和缓慢改善。为了应对这些挑战,我们提出了一个新颖的框架,称为EN基于Semble的O ffline-o o nline(Enoto)RL。通过增加Q-Networks的数量,我们无缝桥接离线预培训和在线微调而不会降低性能。此外,为了加快线条绩效的提高,我们适当放松了Q值估计和基于公司集合的勘探机制的悲观情绪,进入了我们的框架。实验结果表明,ENOTO可以实质上提高训练稳定性,学习效率以及在一系列运动和NAVIND任务上进行微调过程中现有离线RL方法的最终表现,从而极大地超过了现有的离线离线到Online-Online-Online-Online RL方法。

使用Q ...