XiaoMi-AI文件搜索系统

World File Search SystemLandsbankinn可持续财务框架

可持续发展学评估了Landsbankinn的可持续财务框架,以与对欧盟分类法的环境目标的大量贡献(SC)的技术筛选标准保持一致。Landsbankinn可持续财务框架的收益类别中定义的标准映射到欧盟分类学中的59项活动。可持续发展态度认为,有46个活动与适用的SC标准保持一致。Sustainalytics也认为,在Landsbankinn可持续财务框架下要资助的活动和项目将与欧盟分类法的最低保障措施保持一致。Landsbankinn可持续财务框架没有在本报告中评估与欧盟分类法的严重伤害(DNSH)标准的一致性。

Ellucian战略咨询公司

Ellucian Strategic Consulting 服务提供支持,以使资源与机构使命和目标保持一致,制定有效的治理计划,并传达和引领变革。我们的团队可以帮助您培养一个引人入胜的参与过程,带来积极的变化和更高的绩效,从而使您的技术战略与机构的使命保持一致。

将改进与战略目标结合起来 - aqua.nhs.uk

围绕战略目标开展改进活动 我们知道,如果没有一线员工的精力和热情,改进就不会发生。然而,我们知道,如果要在系统层面获得最大利益,这些精力需要与组织的愿景和战略目标保持一致,并在适当的情况下与更广泛的社区的愿景和战略目标保持一致。

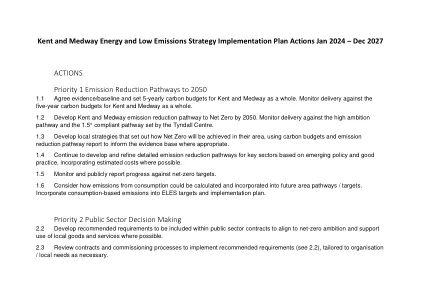

Kent和Medway Energy以及低排放策略实施计划行动2024年1月 - 2027年12月

2.6进行政策和服务审查,以使国家和地方一级的净零净承诺与政策,支出和职能保持一致。确定挑战/错位,然后制定缓解计划,以使其在将来日期保持一致并减少排放。开发项目和财务评估系统,包括排放和气候影响。

2023–2028 年房地产战略 - 伦敦

通过对伦敦大学亚非学院校园及其与当前和计划活动的关系的分析,以及与校园社区利益相关者的广泛协商以及高等教育领域的最佳实践,该地产战略建议制定政策和项目,为地产提供持久的战略框架,并与伦敦大学亚非学院的愿景和宗旨保持一致。该战略与伦敦大学亚非学院更广泛的愿景和使命保持一致,详见附录 2。该战略包括对可以产生直接影响的项目的建议以及长期规划。一年级本科生应该期望在课程期间看到他们对大学的体验有显著的改善,这些变化将与伦敦大学亚非学院的长期战略愿景保持一致。

指南 - 示例效率 - 兽医 - 兽医...- ema

*当前的修订包括为了使指南与2019/6条第4条(EU)提供的新定义和术语保持一致。尤其是该指南与“预防”和“地球运动”的定义保持一致,以及在第107(3)条和监管(EU)2019/6条第107(3)和第107(4)条中负责使用抗菌剂的规定。对适用的立法和其他科学指南的引用也已更新。

2024 年维多利亚州供应链峰会

使 CODB 与需求、财务和销售保持一致,以匹配供应商为上下游业务提供服务的效率 平衡 BAU 供应链卓越性与战略未来路线图,以超越业务预期 使 CODB 与需求、财务和销售保持一致,以匹配供应商为上下游业务提供服务的效率 平衡 BAU 供应链卓越性与战略未来路线图,以超越业务预期

三角洲计划政策

(1) 为了与三角洲计划保持一致,所涵盖的行动必须与本监管政策以及第 3 条中与所涵盖的行动相关的每项监管政策保持一致。三角洲管理委员会承认,在某些情况下,基于所涵盖行动的性质,可能无法完全与所有相关监管政策保持一致。在这些情况下,提交一致性证明的机构可以确定所涵盖的行动与三角洲计划一致,因为整体而言,该行动与同等目标一致。该确定必须包括明确指出无法与相关监管政策保持一致的领域、无法做到这一点的原因,以及说明所涵盖的行动为何整体上与同等目标保持一致。该确定可在上诉时接受三角洲管理委员会的审查; (2)未免受 CEQA 豁免的涵盖行动必须包括已通过并纳入 2018 年 4 月 26 日修订的三角洲计划的所有适用可行缓解措施,该计划根据《加州法规修正案》第 1 章第 23 节第 5002 款第 (b)(2) 节于 2019 年 5 月 30 日提交,于 2019 年 7 月 1 日生效(2019 年登记册第 22 号)。

2023 年可持续发展报告 - 欧洲回收平台

2022 年,我们自愿参考全球报告倡议 (GRI) 标准开始披露可持续发展信息。我们将继续使我们的报告与 GRI 标准保持一致。这些披露基于我们在 2022 年进行的重要性评估。此外,今年,我们还开始使我们的报告与欧洲可持续发展报告标准 (ESRS) 保持一致。这种双重一致性增强了我们报告的严谨性,并帮助我们和我们的客户为未来的监管要求做好准备。