XiaoMi-AI文件搜索系统

World File Search System一组群论问题的量子算法*

摘要:本工作引入了两个决策问题,稳定器 D 和轨道陪集 D ,并给出了从它们到问题轨道叠加 (Friedl 等人,2003) 的量子简化,以及从两个群论问题群交和双陪集成员到它们的量子简化。基于这些简化,在黑箱群设置中获得针对群交和双陪集成员的有效量子算法。具体而言,对于可解群,如果其中一个底层可解群具有平滑可解的交换子群,则这为群交提供了有效的量子算法,如果其中一个底层可解群是平滑可解的,则这为双陪集成员提供了有效的量子算法。最后,证明了群交和双陪集成员属于复杂度类 SZK 。

研究文章 UUV自主决策方法...

针对无人水下航行器(UUV)作业环境中决策的复杂性和不确定性,本文提出了一种基于动态影响图(DID)和期望效用理论的自主决策方法。首先,建立了UUV态势感知威胁评估模型。据此,建立了UUV自主决策的DID模型。然后,基于UUV威胁评估结果,推断并预测决策节点中各决策方案的效用。随后,利用最大期望效用原则选择最优自主决策方案。最后,通过仿真验证了DID方法的有效性。与传统专家系统相比,DID系统表现出很强的适应性,并且在不确定条件下的动态决策问题中表现出更好的解决方案。

课程描述2024-2025- UNINE

课程以业务分析(决策过程,系统和模型)中使用的主要概念的概述开始。本课程的第一部分强调了决策的定量方法。决策分析中使用的主要模型(影响图,决策树)在两种情况下都呈现 - 没有概率和概率,以及两个决策分析:风险分析和灵敏度分析。还描述了用于多准则决策问题(作为分析层次结构过程)的几种模型。该课程的第二部分深入分析业务分析中最著名和最应用的定量模型之一:线性编程(主题 - 最佳解决方案,灵敏度分析,二进制变量,案例应用,构成营销,财务,运输,网络分布,网络分布,游戏理论,项目计划,项目计划)。

基于DAG 和AHP-TOPSIS 算法的多乘员协同任务分配方法研究

等方面 . 人机功能分配主要包括静态和动态两种类型 , 静态功能分配是从功能特性和需求分析入手 , 通过比较人 和系统在完成该功能上的能力优势或绩效优劣 , 决定该功能分配给人还是系统 . 动态功能分配方法则是在静态 人机功能分配的基础上 , 当动态触发机制响应时 , 允许系统在运行阶段根据情况的变化将功能在人与系统之间 动态地重新分配 , 提高整体的工作效率 . 多智能体的任务分配是指在作战开始前 , 指挥中心通常会根据已掌握的 战场信息 , 对己方作战单元进行任务预分配 . 但随着战场情景变化以及突发情况的出现 , 预分配方案可能会使得 执行任务的效能降低 , 多智能体如何调整自身任务 , 使得执行任务的效能保持最大是其研究的主要内容 . 计算机 任务调度研究的是将任务动态地调用给各个虚拟机并提供给用户使用 , 怎样合理地将任务分配给不同的虚拟机 , 进而提升整个系统的性能是其研究的重点 . 以上分配原则对于多乘员分配有很好的参考价值 , 但舱室乘员间任 务分配时 , 主要考虑到人的特性 , 需要以人的理论基础来加以研究 [4] . 针对实际作战过程中 , 乘员应对非预期事件效率低下的问题 , 本文提出了一种多乘员协同动态任务分配方 法 . 在非预期事件触发时 , 对任务进行 DAG 分解及分层 , 根据乘员脑力负荷、乘员能力、任务相关度以及时间成 本四个因素 , 按照一定的任务分配顺序 , 基于 AHP-TOPSIS 方法进行乘员的优选 , 实时更新乘员状态 , 并以此为 依据进行下一任务的分配 . 任务分配过程可实现随乘员状态变化而动态调整 , 达到负荷均衡、效能最优 , 从而将 多任务分配问题简化为单个任务的多属性决策问题 .

强化学习在航空领域的应用综述

强化学习 (RL) 已成为解决包括航空业在内的各个领域复杂决策问题的有力工具。本文全面概述了 RL 及其在航空业中的应用。我们首先介绍 RL 的基本概念和算法,强调它们在从交互中学习和优化决策过程方面的独特优势。然后,我们深入研究 RL 方法在航空业中的成功实施,涵盖飞行控制、空中交通管理、航空公司收入管理、飞机维护调度等领域。此外,我们讨论了 RL 在提高航空业安全性和可持续性方面的潜在优势。最后,我们确定并探索了未来研究的开放挑战和领域,强调强化学习和航空领域之间需要继续创新和合作。

生命周期成本分析的能源价格指数和折扣因子 – 2023 年:NIST 手册 135 年度补充

(1) 联邦能源管理计划生命周期成本手册,美国国家标准与技术研究所,手册 135 – 2022 年版。本手册是理解生命周期成本和相关经济分析方法的指南,因为它们应用于联邦决策,特别是那些受 10 CFR 436A 规则约束的决策。它描述了所需的程序和假设,定义并解释了如何应用和解释经济绩效指标,给出了联邦决策问题及其解决方案的示例,解释了如何使用能源价格指数和折扣因子,并提供了计算所需指标的计算辅助和说明。2020 年版扩大了考虑范围,包括联邦可持续性和复原力项目。2022 年版扩大了对定价外部性的讨论,特别是温室气体 (GHG) 排放。

生命周期成本分析的能源价格指数和折现因素 - 2022:NIST手册的年度补充135

(1)联邦能源管理计划的生命周期成本核算手册,国家标准与技术研究所,手册135 - 2022版。本手册是理解生命周期成本和相关经济分析方法的指南,因为它们适用于联邦决策,尤其是遵守10 CFR 436A规则的决策。它描述了所需的程序和假设,定义和解释了如何应用和解释经济绩效指标,提供联邦决策问题及其解决方案的示例,解释了如何使用能源价格指数和折现因素,并提供计算辅助工具和说明来计算所需措施。2020年版扩大了考虑范围,包括联邦可持续性和弹性项目。2022年版扩展了有关定价外部性的讨论,特别是温室气体(GHG)排放。

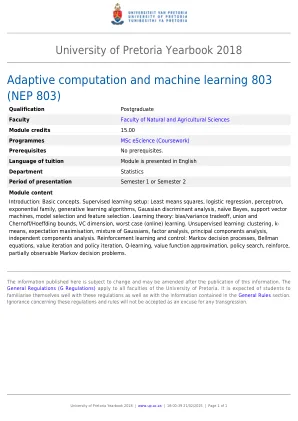

自适应计算和机器学习803(NEP 803)

简介:基本概念。监督的学习设置:至少是平方,逻辑回归,感知器,指数家庭,生成学习算法,高斯判别分析,幼稚的贝叶斯,支持向量机器,模型选择和功能选择。学习理论:偏见/差异权衡,工会和切尔诺夫/hoeffding界限,风险投资维度,最坏情况(在线)学习。无监督的学习:聚类,k-均值,期望最大化,高斯人的混合物,因子分析,主成分分析,独立组件分析。强化学习和控制:马尔可夫决策过程,钟声方程,价值迭代和政策迭代,Q学习,价值函数近似,策略搜索,加强,部分可观察到的马尔可夫决策问题。

用扩散生成的汤普森采样

在这项工作中,我们启动了使用Denois扩散模型来学习在线决策问题的先验的想法。我们专门针对强盗元学习,旨在学习一项跨同一班级的强盗任务的策略。为此,我们训练一个扩散模型,该模型在测试时处理了基本的任务分布,并在处理新任务之前与学习的汤普森采样。我们的后抽样算法仔细平衡了学识渊博的先验和嘈杂的观察结果,这些观察结果来自学习者与环境的相互作用。为了捕获现实的强盗情景,我们提出了一种新型的扩散模型训练程序,该过程从不完整和嘈杂的数据中训练,这可能具有独立的兴趣。最后,我们的广泛实验清楚地证明了所提出的方法的潜力。