XiaoMi-AI文件搜索系统

World File Search System变形金刚峰会2023

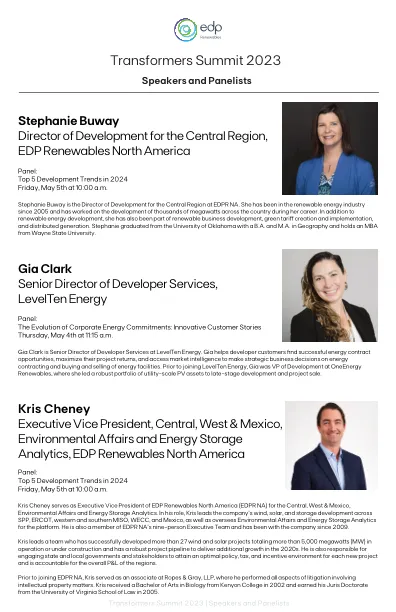

Michelle Davis是Wood Mackenzie Power&Renewables的首席分析师。她在伍德·麦肯齐(Wood Mackenzie)领导美国分发的太阳能实践,包括与SEIA(太阳能工业协会)合作的Solar Market Insight Report的季度出版物。她还领导着商业太阳能市场的研究报道,并跟踪安装人员,金融家和技术提供商的竞争格局。在加入Wood Mackenzie之前,米歇尔(Michelle)担任各种研究职位,重点介绍了可再生能源,涵盖了从能量水连接到电动汽车充电站的公用事业投资等主题。她拥有亚利桑那州立大学的生物学学士学位和安提阿大学的MBA,重点是可持续性。米歇尔总部位于亚利桑那州的坦佩。

CNN,RNN和变形金刚

人类行动识别(HAR)涵盖了监视各个领域的人类活动的任务,包括但不限于医学,教育,娱乐,视觉监视,视频检索以及对异常活动的识别。在过去十年中,HAR领域通过利用卷积神经网络(CNN)和经常性的神经网络(RNN)来有效提取和理解复杂的信息,从而增强了HAR系统的整体性能,从而取得了实质性的进展。最近,计算机视觉的领域见证了视觉变压器(VIT)的启示作为有效的解决方案。超出图像分析的范围,已验证了变压器体系结构的功效,从而将其适用性扩展到了不同的视频相关任务上。值得注意的是,在这一景观中,研究界表现出对HAR的浓厚兴趣,承认其多种效用并在各个领域中广泛采用。本文旨在提出一项涵盖CNN的涵盖调查,鉴于它们在HAR领域的重要性,RNNS对VIT的发展。通过对现有文献进行彻底研究并探索新兴趋势,本研究对该领域的累积知识进行了批判性分析和综合。此外,它还研究了正在进行的开发混合方法的努力。遵循此方向,本文提出了一种新型的混合模型,该模型旨在整合CNN和VIT的固有优势。

变形金刚:纯粹基于注意力的网络学习

自我注意事项是指神经网络自行找出序列的哪些部分,例如单词句子或图像中的一系列斑点,共同有助于解决手头的问题。例如,对于语言翻译,自我注意力的目标是找出源语言中哪些单词在一起有助于目标语言中任何单个单词的产生。另一方面,在图像识别中,自我注意力将有助于网络弄清楚哪些补丁程序共同做出了最大的贡献,可以正确预测类标签。

深度学习和变形金刚中的硕士论文

组合优化在多样化的物流,制造,基因组学和合成生物学等多样化的领域中的许多现实应用中都起着至关重要的作用。这些问题及其复杂的变化的NP坚硬性质使它们难以解决。传统方法通常依赖于数十年研究的确切算法和启发式方法。但是,他们在可伸缩性和对其他问题的适应性方面挣扎。为了克服这些局限性,深度学习的成功导致了神经组合优化(NCO)的出现,后者从传统方法偏离了传统方法,以利用神经网络的概括能力。在这里,通过从数据中学习无需手动制定算法规则的数据,对神经网络进行了培训,从而生成了近乎最佳的解决方案。

bevgan:生成鱼眼交叉视图变形金刚

摘要:当前的停车援助和监测系统合成鸟类视图(BEV)图像,以提高驱动程序的可见度。这些BEV图像是使用称为“逆透视图”(IPM)的流行透视转换创建的,该转换将其投射到FishEye摄像头捕获的环绕视图图像的像素上。然而,IPM在准确地表示高度和接缝的对象方面面临挑战,因为它依赖于刚性几何变换,因此将预计的环绕视图缝合在一起。为了解决这些局限性,我们提出了Bevgan,这是一种新型的几何形状引导的条件生成副本网络(CGAN)模型,将多尺度鉴别器与基于变形金刚的生成器相结合,该生成器利用Fisheye摄像机校准和注意力机械机制,以隐含地模拟该视图之间的几个几何形式的变换。实验结果表明,在图像保真度和质量方面,Bevgan的表现优于IPM和最先进的跨视图生成方法。与IPM相比,我们报告了 + 6的改进。在PSNR上的2 dB,MS-SSIM上的 + 170%在描绘停车场和驾驶场景的合成数据集上进行评估。此外,还通过零射推理证明了Bevgan在现实世界中的图像上的概括能力。

视觉变形金刚的解释性:全面审查和新观点

变形金刚对自然语言处理产生了重大影响,最近证明了它们在计算机视觉中的潜力。他们在基本的计算机视觉任务中显示了卷积神经网络的有希望的结果。然而,科学界并未完全掌握视觉变形金刚的内部运作,也没有做出决策的基础,这强调了解释性方法的重要性。了解这些模型如何做出决定不仅可以改善其绩效,还可以建立对AI系统的信任。本研究探讨了为视觉变压器提出的不同解释性方法,并提出了根据其动机,结构和应用方案组织它们的分类法。此外,它提供了对评估标准的全面审查,可用于比较解释结果以及解释性工具和框架。最后,本文重点介绍了可以增强视觉变形金刚的解释性的基本但未开发的方面,并建议有前途的研究方向以进行未来的投资。关键字:解释性,视觉变压器,VIT,注意力,修剪。

视觉变形金刚用于面部图像的年龄估计

3实施34 3.1模型体系结构。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。34 3.2培训和评估程序。。。。。。。。。。。。。。。。。。。。。。37 3.2.1损失和错误实现。。。。。。。。。。。。。。。。。。。。37 3.2.2数据增强实现。。。。。。。。。。。。。。。。。39 3.2.3训练循环。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。40 3.2.4注意推出实现。。。。。。。。。。。。。。。。。。。41 3.2.5 Grad-CAM实施。。。。。。。。。。。。。。。。。。。。。。。42 3.3实验。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。43 3.3.1定量实验。。。。。。。。。。。。。。。。。。。。。。。。43 3.3.2定性实验。。。。。。。。。。。。。。。。。。。。。。。。。45

对表示漏洞和工程强大的视觉变形金刚的机械理解

大型语言模型(LLMS)因其在各种任务中具有出色的属性和多功能性而被越来越多地认可。但是,与这些模型相关的高推理成本尚未得到关注,尤其是与现有研究中培训成本的关注相比。响应这一差距,我们的研究在广泛的NLP任务中对LLM推断能量进行了全面的基准测试,我们在其中分析了不同的模型,任务,提示和系统相关因素对推理能量的影响。具体来说,我们的经验揭示了几个有趣的见解,包括将推理能量与输出令牌长度和响应时间的密切相关。此外,我们发现量化和最佳批量大小以及针对性的及时短语可以显着降低能量使用。这项研究是第一个在各种各样的各个方面进行彻底基准的LLM,从而提供了见解并提供了一些提高模型部署能源效率的建议。