XiaoMi-AI文件搜索系统

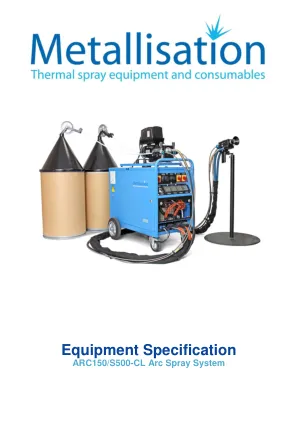

World File Search System设备规格

以下规格涵盖了 ARC150/S500-CL 电弧喷涂系统的标准范围。有关具体报价,请参阅详细报价单并交叉引用每台设备的零件编号。为了响应客户对系统灵活性的反馈,但其吞吐量要高于我们的 350A 系统,我们创建了 500A、ARC150/S500-CL 系统。客户反馈还表明,在某些情况下,600A 和 700A 系统很重(因为需要电缆容量)。由于在手动喷涂复杂结构时吞吐量很高,有时也很难控制均匀的涂层厚度。为此,Metallisation 为 ARC150 系统配备了 500A 激励器,在吞吐量、重量和控制之间实现了平衡。ARC150 的设计原则是使用成熟的推/拉技术和 ARC140 系统的风冷电缆。我们保持了长期供应能力,并且与 350A 系统相比,生产量提高了 40% 以上。枪、激励器、驱动装置和供应包都经过了重新设计,以适应增加的负载和喷涂电流。与所有金属化电弧喷涂系统一样,ARC150 被设计为在世界任何地方以 100% 的占空比运行。

基于极地代码的查找表的展开和管道解码器

摘要 - 解码算法允许以增加面积的成本实现极高的吞吐量。查找表(LUTS)可用于替换其他作为电路实现的功能。在这项工作中,我们显示了通过在独立的解码器中精心制作的LUTS代替逻辑块的影响。我们表明,使用LUTS改善关键性能指标(例如,区域,吞吐量,潜伏期)可能比预期更具挑战性。我们提出了三种基于LUT的解码器的变体,并详细描述了它们的内部工作以及电路。基于LUT的解码器与常规展开的解码器进行了比较,该解码器采用固定点表示数字,具有可比的误差校正性能。简短的系统极性代码被用作说明。所有由此产生的展开解码器均显示能够在28 nm FD-SOI技术中以1.4 GHz至1.5 GHz的时钟进行少于10 Gbps的信息吞吐量。与常规展开的解码器相比,我们的基于LUT的解码器的最佳变体可将面积的需求降低23%,同时保留可比的错误校正性能。

人工智能系统的软件架构

运行世界上最大的 Ruby on Rails 安装之一 200 名工程师 整体式:管理原始数据库、memcache、呈现站点和 * 在一个代码库中呈现公共 API 越来越难以理解的系统;管理和并行化工程团队在组织上具有挑战性 达到了我们存储系统 (MySQL) 的吞吐量极限;在整个数据库中读取和写入热点 使用机器来解决问题;每台机器的吞吐量低(CPU + RAM 限制,网络未饱和) 优化角:在代码可读性和性能之间进行权衡

用于可解释人工智能的随机模糊规则泡沫

摘要 随机泡沫训练多个模糊规则泡沫函数近似器,然后将它们组合成单个基于规则的近似器。泡沫系统在来自训练有素的神经分类器的引导随机样本上独立训练。泡沫系统将神经黑匣子转换为可解释的规则集。基于模糊规则的系统具有底层概率混合结构,可对每个输入的规则产生可解释的贝叶斯后验。规则泡沫还通过广义概率混合的条件方差来衡量其输出的不确定性。随机泡沫通过平均其吞吐量或规则结构来组合学习到的加性模糊系统。随机泡沫在其规则、规则后验和条件方差方面也是可解释的。30 个 1000 规则泡沫在 MNIST 数字数据集的随机子集上进行训练。每个这样的泡沫系统的分类准确率约为 93.5%。平均吞吐量的随机泡沫实现了 96。 80% 的准确率,而仅对其输出进行平均的随机泡沫则实现了 96.06% 的准确率。吞吐量平均的随机泡沫也略胜于对 30 棵分类树进行平均输出的标准随机森林。30 个 1000 规则泡沫也在深度神经分类器上进行训练,准确率为 96.26%。对这些泡沫吞吐量进行平均的随机泡沫本身的准确率为 96.14%。对其输出进行平均的随机泡沫准确率仅为 95.6%。附录证明了加法系统模糊近似定理的高斯组合泡沫版本。

MIT开放访问文章超级 - ...

摘要 - 我们通过由多个连接组成的异质网络考虑了量子后安全和超可靠的通信问题。考虑了三个性能:安全性,吞吐量和订购交付延迟。在这种情况下,以前的工作单独查看了固定交付延迟与吞吐量之间以及安全性和吞吐量之间的权衡。这是考虑到异质通信网络的所有三个方面的权衡,同时考虑了计算综合性。我们提出了LL-Huncc,这是一个低延迟混合通用网络编码加密系统。ll-huncc是一种有效的编码方案,它仅通过对要发送的一小部分信息进行加密,可以通过嘈杂的不信任异质网络进行安全通信。此方案提供了高通量和较低订购延迟保证的量子后安全性。我们通过模拟评估了LL-Huncc,该设置受到了涉及涉及卫星通信链接和5G通信网络的异质通信的实用场景的启发。在这种情况下,我们将ll-huncc与最先进的方法进行了比较,其中所有通信路径均通过后量子后的公共键密码系统进行加密。

功率感知的深度学习模型与μ-Serve一起服务

摘要随着大型深度学习模型的日益普及 - 服务工作量,迫切需要减少模型服务集群的能源消耗,同时对满足满足的吞吐量或模型服务的延迟需求。模型多路复用方法,例如模型阶段性,模型放置,复制和批处理旨在优化模型服务性能。但是,它们没有利用GPU频率缩放机会来节省。在本文中,我们证明了(1)GPU频率缩放在功率节省中用于模型服务的好处; (2)对细粒度模型多路复用和GPU频率缩放的共同设计和优化的必要性。我们探索了共同设计的空间,并提出了一种新型的功能感知模型服务系统µ-Serve。µ-Serve是一个模型服务框架,可优化在均质GPU群集中有效使用多个ML模型的功耗和吞吐量/吞吐量。生产工作负载的评估结果表明,通过动态GPU频率缩放(降低61%)而无需违反SLO的动态频率缩放(最多减少61%),可节省1.2–2.6倍的功率。

ML云GPU短缺培训:跨区域是答案吗? 水管工

摘要ML的广泛采用导致对GPU硬件的需求很高,因此,公共云中GPU的严重短缺。通常很难在单个云区域分配足够数量的GPU来训练或微调当今的大型ML模型。如果用户愿意使用不同地理区域的设备进行ML培训工作,则可以访问更多的GPU。但是,GPU节点与较低的网络带宽连接,并且云提供商为跨地理区域的数据传输提供了额外的费用。在这项工作中,我们探讨了何时以及如何有意义地利用跨区域和地区进行分布式ML培训的GPU。我们根据不同模型并行性策略的计算和通信模式分析了跨区域培训的吞吐量和成本影响,开发了一种基于配置文件的分析模型,用于估计培训吞吐量和成本,并为有效分配地理分配资源提供指南。我们发现,尽管在节点跨越地理区域时,ML训练吞吐量和成本会显着降低,但使用管道等级的跨区域训练是实用的。