XiaoMi-AI文件搜索系统

World File Search System通过嵌入 SiC 半导体实现高压电源模块的概念

具有集成电气隔离,如陶瓷基板。安装半导体的首选方法是低压低温银烧结工艺。该方法具有一些优点:首先,它能够在大型面板格式上组装芯片,从而实现高度并行处理。此外,芯片粘合精度对后续工艺步骤很重要,主要取决于芯片粘合工艺的精度,因为除了

先进计算机辅助 I 规划和... - DTIC

专家系统一方面将允许决策者越来越自动化或由非专业人员控制,另一方面将通过及时提供信息和快速评估替代战略大大扩展军事指挥官的能力。在个人面临人身危险的情况下,此类设施变得更加重要。现在,计算机架构有望通过使用并行处理和系统网络等技术来促进高速处理甚至“彼得”量的数据。

数字设计和计算机架构

“微架构是一种三路超标量流水线架构。三路超标量意味着,通过使用并行处理技术,处理器平均能够在每个时钟周期解码、调度和完成(退出)三条指令。为了处理这种级别的指令吞吐量,P6 处理器系列使用了支持无序指令执行的解耦 12 级超级流水线。”

“神经网络技术与人工智能”

神经网络(NN)是人工智能的一部分,它使用类似于生物神经元中发生的现象来处理信号。网络最重要的特征是所有环节并行处理信息,这也体现了网络的广泛能力和巨大潜力。通过大量的神经元间连接,可以显著加快实时信号转换过程。此外,由于存在大量的神经元间连接,网络能够抵抗某些线路上发生的错误。

简历 (PDF) - David I. August - 普林斯顿大学

• 因 COS/ECE 375“计算机体系结构和组织”荣获“普林斯顿大学工程与应用科学学院卓越教学奖”,2024 年 4 月。 • 因“对多核和并行处理系统的编译器和体系结构的贡献”晋升为 IEEE 院士,2015 年。 • 因“PDIP:优先级定向指令预取”荣获 2024 年国际编程语言和操作系统体系结构支持会议 (ASPLOS) 最佳论文奖,2024 年 4 月。 • 入选“国际计算机体系结构研讨会 (ISCA) 名人堂”,2024 年 6 月。 • “AsmDB:理解和缓解仓库级计算机的前端停顿”入选 IEEE Micro 2019 年“精选”特刊,基于“在计算机体系结构领域的新颖性和长期影响潜力”。 • 入选“SWIFT:软件实现的容错”,荣获 2015 年第十三届代码生成和优化国际研讨会 (CGO) 的“时间考验奖”。 • “DAFT:解耦非循环容错”被程序委员会选入国际并行处理杂志的特刊,该特刊由 2010 年第 19 届并行架构和编译技术国际会议 (PACT) 的“顶级论文”组成。 • “容错类型汇编语言”被提名为 ACM 通讯 (CACM) 研究亮点,2008 年 9 月。

v11i1-1269.pdf

今天的摘要,数据已成为几乎每个业务领域的推动力,并且与人工智能(AI)一起,云计算是增强业务运营和绩效的关键推动力。本研究重点是优化云环境中的分布式机器学习(DML)算法,以有效处理和处理大型数据集。本文通过利用云平台的计算能力和存储容量以及并行处理技术来提出一种改善DML算法性能的方法。实验结果表明,所提出的方法可将处理时间减少40%,并将模型准确性提高15%,使其非常适合大数据环境。关键字:分布式机器学习,云计算,大数据,优化,并行处理。云计算,并行处理,可伸缩性,容错性,数据复制1。简介云计算已彻底改变了数据的管理和处理方式,提供了能够处理大规模数据的强大的分布式系统。随着数据量的快速增长,使用分布式机器学习(DML)算法已成为必要。这些算法将计算跨多个节点划分,以提高数据处理效率。云平台,例如AWS,Microsoft Azure和Google Cloud提供了扩展机器学习模型所需的基础架构和灵活性。但是,诸如延迟,效率低下的资源管理和通信复杂性等挑战仍然存在,需要解决。2。本文提出了一种优化基于云的大数据系统中DML算法的策略。通过将并行处理与动态资源管理相结合,该方法可以减少延迟,改善数据吞吐量并增强部署在云环境中的机器学习模型的整体性能。使用来自AWS EC2实例的现实世界数据对所提出的方法进行验证。分布式计算系统和DML算法中的问题基于云的分布式系统和DML算法的性能受到了几个关键挑战的影响,每个挑战必须解决每个挑战以确保最佳系统性能。2.1可伸缩性问题随数据的增长,分布式系统必须能够扩展以适应增加的工作量。水平缩放(添加更多节点)和垂直缩放(节点的资源增加)是常见方法,但是这些引入了数据一致性和网络流量等问题。无法控制的缩放率可以降低整体系统性能。2.2 DML算法中的通信瓶颈,频繁更新模型参数导致节点之间的数据交换。当网络带宽被拥挤时,这些交换会产生重大延迟。优化诸如GRPC和QUIC之类的通信协议可以减轻这些瓶颈并提高整体性能。2.3资源管理有效管理CPU,内存和存储等资源的挑战对于最佳系统性能至关重要。诸如动态缩放和负载平衡之类的技术有助于确保有效分配资源,从而防止某些节点过度负载和其他其他节点的实现不足,从而在不同的工作负载下保持系统效率。

基于上下文对象识别的因果神经机制

抽象对象可以根据其内在特征(包括形状,颜色和纹理)识别。但是,在日常生活中,这种特征通常不明确,例如,当物体出现在外围,杂物中或远处时。有趣的是,当对象在其典型场景上下文中看到对象时,对象识别仍然可以高度准确。基于上下文对象识别的神经机制是什么?根据并行处理帐户,基于上下文的对象识别是由对象和场景信息在单独的路径中的并行处理支持的。然后将这些途径的输出组合在下游区域中,从而在对象识别中获得上下文益处。另外,根据反馈帐户,基于上下文的对象识别受(直接或间接)从场景选择性到对象选择区域的反馈支持。在这里,在三个预注册的经颅磁刺激(TMS)实验中,我们测试了反馈假设的关键预测:该场景选择性皮质因果关系和选择性地支持基于上下文的对象识别,然后才能识别对象选择性皮层。早期视觉皮层(EVC),对象选择性的枕叶皮层(LOC)和场景选择性枕骨位置(OPA)在相对于刺激发作的三个时间点刺激,而参与者则在不同的试验中分别对场景和完整对象进行分类。这些结果表明,基于上下文的期望通过在视觉皮层中删除对象表示来有助于对象识别。结果证实了我们的预测:相对于孤立的对象识别,基于上下文的对象识别在发作后160-200毫秒被OPA选择性和因果支持,然后在发作后的260-300 ms下进行LOC。

可逆计算简介-Kalyan Perumalla

本教程提供了可逆计算的概念的介绍,采用了扩展的视图:除了快速概述传统的能量动机硬件观点外,它还提供了一种新兴应用程序动机软件方法的深度覆盖,以进行可逆计算。这对于理解可逆计算的不同新颖方法很有用,在大规模计算(例如设想的EXA级发展)中提供了当前方法的潜力。在未来的非常大规模的超级计算中,在容错,调试和同步的背景下说明了通用可逆计算对未来并行处理的重要性。教程涵盖了理论,硬件和软件方面,显着的基本限制,复杂性分析,算法和自动化方法,以进行可逆计算。范式将介绍用于放宽可逆编程的常规远期编程,包括用于低功率计算的“ Compute-Copy-copy-copy-nodympute”和“ Compute-Rollback-Commit”范式,分别为低功率计算和乐观的并行同步。将提出实用算法,以用于可逆性,例如动态内存分配和从复杂分布中生成随机数。将显示最新结果,以表明通过依赖软件级可逆计算而不是检查检查点来克服某些应用程序中的存储墙的可能性。教程大纲将阐明新的可逆编程语言设计的概念,并且将通过对C语言的初步案例研究来描述现有程序可逆执行的当前汇编方法。在更广泛地采用可逆计算中,将在并行处理(包括可逆的计算机算术和输入/输出接口)中确定出色的挑战,并为此提供了一些新颖的方向。

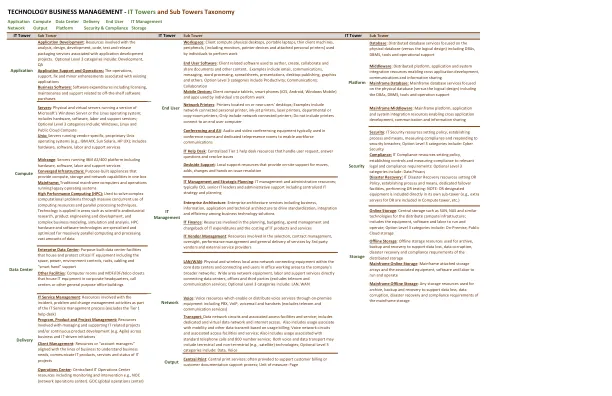

技术业务管理 IT 塔和子...

中端:运行 IBM AS/400 平台的服务器,包括硬件、软件、人工和支持服务 融合基础设施:专用设备,在一个机箱中提供计算、存储和网络功能 大型机:运行旧操作系统的传统大型计算机和操作 高性能计算 (HPC):用于通过大量并发使用计算资源和并行处理技术来解决复杂的计算问题。技术应用于科学和工业研究、产品工程和开发以及复杂的业务建模、模拟和分析等领域。HPC 硬件和软件技术专门针对大规模并行计算和处理大量数据进行了优化