XiaoMi-AI文件搜索系统

World File Search System计算机科学与工程部

1。V. Bhattacharjee Software Engg。,数据挖掘,知识工程,软计算2。Sandip Dutta密码学和网络安全,生物识别技术,网络安全,区块链,云计算中的安全性3。D. K. Mallick博士并行计算,并行体系结构,互连网络,分布式算法和WSN。4。(夫人)Aruna Jain计算机网络与安全,数据挖掘,软计算,网络工程,语音处理5。Bhaskar博士Karn Fuzzy逻辑,信息检索系统,软计算,网络法律,信息架构,知识管理,RTI,机器学习6.V. K. JHA博士数据挖掘,网络与安全,大数据分析7。K. S. Patnaik博士Engg博士,软计算,粗糙集,物联网。8。B. K. Sarkar机器学习,并行计算,遗传算法,库存控制,大数据分析。9。博士I. Mukherjee大数据,信息检索,网络挖掘和

H35-660_v2.0

测试问题的分析:LDPC用于传播通道,性能良好且复杂性较低。它通过并行计算很好地支持高速服务;极地代码用于控制渠道,并且在编码小数据包服务方面具有出色的性能。

计算的历史

计算史 Sotirios G. Ziavras,新泽西理工学院电气与计算机工程系,新泽西州纽瓦克 07102,美国 关键词 计算机系统、早期计算机、电子计算机、电子计算机的各代、大型计算机、机械计算机、微处理器架构、小型计算机、并行计算机、超级计算机。 目录 1. 早期(非电子)计算机 2. 电子计算机 2.1. 第一代(1945-1955) 2.2. 第二代(1955-1965) 2.3. 第三代(1965-1974) 2.4. 第四代(1974-1989) 2.5. 第五代(1990 年至今) 词汇表 CPU:中央处理单元。 分布式处理:在计算机网络上执行单个程序的过程。局域网:在相对较小的物理区域内连接的计算机网络。大型计算机:性能极佳的大型高成本计算机。大规模并行计算机:包含数百或数千个(微)处理器的并行计算机。MIMD:多指令流,多数据流。微型计算机:由微处理器驱动的小型计算机。小型计算机:成本远低于大型计算机(如大型计算机),但性能非常出色。多计算机:包含许多微处理器的并行计算机系统,这些微处理器通过静态点对点物理网络互连。多处理器:包含许多微处理器的并行计算机系统

Domenico Tegolo 的简历

科学简介:主要研究活动是图像分析、模式识别、并行计算和非标准图像数据库。与国际中心合作,研究和开发了一套方法,涉及人类大脑神经元、眼底、视频毛细血管镜图像分析、图像检索、超声图像分割和分布式架构的标志性图像语言。目前,他正在研究数学方法,以在 MRI 数据上分割人体中的一些特殊癌症区域;研究数学计算模型如何模拟海马区神经元的分布,以及如何使用它们的关系来做出决策和了解环境。此外,他还在研究视频毛细血管镜领域的增强现实框架。

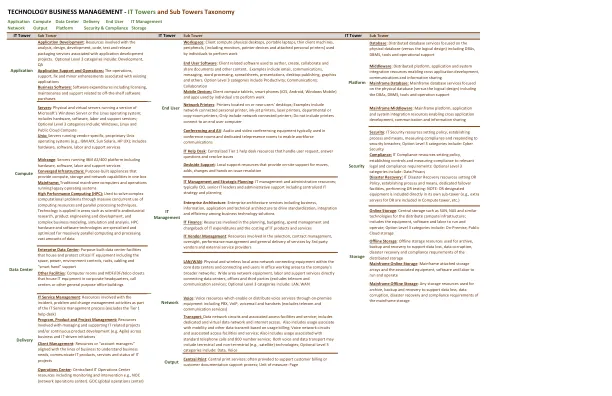

技术业务管理 IT 塔和子...

中端:运行 IBM AS/400 平台的服务器,包括硬件、软件、人工和支持服务 融合基础设施:专用设备,在一个机箱中提供计算、存储和网络功能 大型机:运行旧操作系统的传统大型计算机和操作 高性能计算 (HPC):用于通过大量并发使用计算资源和并行处理技术来解决复杂的计算问题。技术应用于科学和工业研究、产品工程和开发以及复杂的业务建模、模拟和分析等领域。HPC 硬件和软件技术专门针对大规模并行计算和处理大量数据进行了优化

人工智能通讯

1.NVIDIA 是一家设计 GPU 技术的技术公司,为 AI 领域做出了重大贡献,包括为深度学习和其他 AI 应用开发硬件和软件解决方案。NVIDIA 的 GPU 及其 CUDA 平台(用于 AI 和高性能计算的并行计算平台)用于运行复杂的机器学习模型。根据 MLPerf Benchmarks,NVIDIA 在商用产品中提供全球最快的 AI 训练性能。因此,正如他们在博客中所述,他们被亚马逊、百度、Facebook、麻省理工学院和斯坦福大学等公司和机构选为其 AI 计划。NVIDIA 的硬件和软件解决方案使组织能够更有效地构建和部署 AI 应用程序。

LLM4HPC:迈向AI自主HPC世界

- 给我一个内核和一个函数,仅计算向量X的乘法通过常数a的乘法,然后将结果添加到向量y中。不要提供主要功能。向量x和y是长度n,使用C和CUDA并行计算,分配和释放GPU向量,并在功能中进行CPU -GPU存储器传输。必须定义螺纹块的大小和块的数量。使用内核__global __ void saxpy_kernel(int n,float a,float a,float *x,float *y)以及函数void chatblas_saxpy的下一个函数名称和参数。在代码开头的下一行#include“ chatblas_cuda.h”

强双线性耦合的伊辛机

耦合参数谐振器(参数器)网络有望成为并行计算架构。在实现复杂网络的过程中,我们报告了两个耦合参数器的实验和理论分析。与以前的研究不同,我们探讨了参数器之间强双线性耦合的情况,以及失谐的作用。我们表明,即使需要仔细校准以确保有正确的解空间,系统仍可在此状态下作为 Ising 机运行。除了形成分裂正常模式外,还会产生新的混合对称状态。此外,我们预测具有 N > 2 个参数器的系统将经历多个相变,然后才能达到与 Ising 问题等同的状态。

Colossal-AI:用于大规模并行训练的统一深度学习系统

Transformer 模型的成功将深度学习模型规模推向了数十亿参数,但单 GPU 的内存限制导致在多 GPU 集群上进行训练的需求迫切。然而,选择最优并行策略的最佳实践仍然缺乏,因为它需要深度学习和并行计算领域的专业知识。Colossal-AI 系统通过引入统一接口将模型训练的顺序代码扩展到分布式环境,解决了上述挑战。它支持数据、管道、张量和序列并行等并行训练方法,并集成了异构训练和零冗余优化器。与基线系统相比,Colossal-AI 在大规模模型上可以实现高达 2.76 倍的训练加速。