XiaoMi-AI文件搜索系统

World File Search System多代理强化学习

多机构系统(MAS)在数量的现实世界中广泛普遍且至关重要,在这些应用程序中,多个代理必须在共享环境中做出决定才能实现其目标。尽管无处不在,但在MAS中的智能决策代理的发展对他们的有效实施构成了一些公开挑战。本次调查研究了这些挑战,对研究游戏理论(GT)和机器学习(ML)的开创性概念(ML)进行了兴趣,并将它们与多方面增强学习(MARL)的最新进步联系起来,即MAS中数据驱动决策的研究。因此,这项调查的目的是在MARL的各个方面提供一个全面的观点,从而阐明了MARL应用中呈现的独特机会,同时强调了这种潜力带来的固有挑战。因此,我们希望我们的工作不仅可以通过分析当前的MARL景观来为该领域做出贡献,还可以通过洞察力来激励未来的方向,以深入了解GT和ML相关领域的概念。考虑到这一点,这项工作深入探讨了MARL及其相关领域的最新和过去的努力,并描述了提出的先前解决方案及其局限性以及其应用。

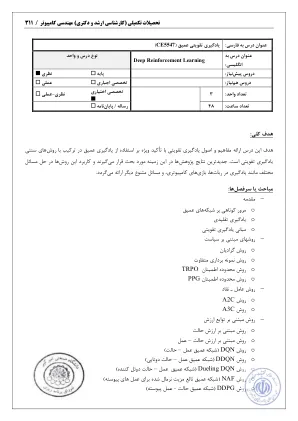

深度强化学习

[1] R. Sutton和A. Barto,《加固学习简介》,麻省理工学院出版社,1998年。[2] C. Szepesvari,《增强学习算法》,Morgan&Claypool Publishers,2010年。[3] C. Watkins,从延迟的奖励中学习,博士学位论文,剑桥大学,英格兰,1989年。[4] M. Wiering和M. Van Otterlo,加固学习:最新的ART,Springer,2014年。[5] M. Puterman,马尔可夫决策过程:离散随机动态编程,Wiley,1994年。[6] D. P. Bertsekas,动态编程和最佳控制,第一卷和II,雅典娜科学,2017年。[7] W. B. Powell,近似动态编程,Wiley,2011年。[8]选定的纸

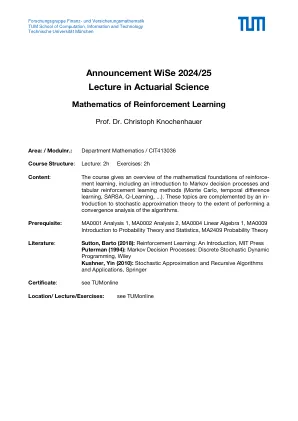

强化学习的数学

区域: / modulnr。:部门数学 / CIT413036课程结构:讲座:2H练习:2H内容:课程概述了增强学习的数学基础,包括对马克夫决策过程的介绍和表图形的增强性增强学习方法(Monte Carlo,Monte Carlo,时间差异,SARSA,SARSA,SARSA,Q-LEAL,Q-LEARNINGNING,...)。这些主题是通过对随机近似理论的影响来补充的,以对算法进行收敛分析。Prerequisite: MA0001 Analysis 1, MA0002 Analysis 2, MA0004 Linear Algebra 1, MA0009 Introduction to Probability Theory and Statistics, MA2409 Probability Theory Literature : Sutton, Barto (2018): Reinforcement Learning: An Introduction, MIT Press Puterman (1994): Markov Decision Processes: Discrete Stochastic Dynamic Programming, Wiley Kushner, Yin (2010): Stochastic近似和递归算法和应用,施普林格证书:请参阅Tumonline位置/讲座/练习:请参阅Tumonline