XiaoMi-AI文件搜索系统

World File Search System通过组稀疏聚类对混合数据进行稀疏 k 均值分类

虽然通过正则化程序进行特征选择的问题在监督学习环境中引起了极大关注,并在过去二十年中产生了大量文献,但直到很晚且相对较新的时候,它才有效地出现在无监督框架中。第一种方法是基于模型的,这些方法自然适合包括套索(L 1)和相关惩罚,并且可以引用 [1] 来了解 L 1 惩罚的 EM 程序(混合由方差相等的高斯分布组成)或 [2] 来详细回顾基于模型的高维数据聚类。在更通用的框架中,没有对底层分布做出任何假设,在 [3] 中引入了具有 L 1 惩罚的稀疏 k 均值算法,后来扩展到每个聚类内的特征选择,并通过一致性结果得到加强,[4] [5] [6]。我们还要提到,最近在 [7] 中引入了稀疏 k 均值算法对重叠变量组的推广。话虽如此,上面引用的所有方法本质上都是为数值数据设计的,而真实数据通常由数值和分类特征组成。上面的一些作者触及了分类特征的问题,提到了使用虚拟变量进行转换使其数字化的可能性。但是,这个处理步骤并不是那么直接,因为零一向量上的欧几里得距离并不特别适合与数值变量上的欧几里得距离混合。其他作者

异性恋亲密关系中与激情相关的强化敏感人格特质:一项 fNIRS 调查

爱情三角理论认为,激情是浪漫爱情中不可或缺的组成部分。一些脑成像研究表明,亲密关系中的激情唤起与大脑中的奖赏回路有关。我们假设个体的奖赏敏感性特质也与亲密关系中的激情有关,本研究进行了两项独立研究。在第一项研究中,选取了558名正处于恋爱中的大学生作为参与者,使用惩罚敏感性和奖赏敏感性问卷、激情爱情量表和爱情三角量表探究异性恋个体的亲密度与强化敏感性之间的相关性。在第二项研究中,选取了42名同样处于恋爱中的大学生,采用功能性近红外光谱(fNIRS)探究参与者在看到伴侣、朋友或陌生人的照片时,奖赏敏感性与情绪唤起之间的神经生理相互作用。结果表明,奖励敏感性与激情呈正相关,惩罚敏感性与亲密度和承诺呈负相关。奖励敏感性和照片类型之间存在显著的相互作用,下额回的三角部分与对伴侣的奖励敏感人格特质表现出特别的相关性。总体而言,研究结果支持强化敏感性理论,并表明强化敏感人格特质(奖励和惩罚敏感性的人格特质)与爱情的所有三个组成部分都相关,只有奖励敏感性与激情相关。

ch 12蔑视法院

Marcisz诉Marcisz,65 Ill.2d 206,357 N.E. 2d 477(1976)刑事蔑视旨在保存法院的尊严和权威,并试图惩罚。 民事蔑视旨在执行私人当事方的权利,并迫使服从命令或法令,以利用反对党的利益。 命令在蔑视法院违反离婚法令中的禁令是犯罪而不是民事的命令,因为它旨在维护法院的尊严和权威,并惩罚被告过去的违法行为;因此,被告有权通知,合理的辩护机会,律师的协助,在合理怀疑的情况下被证明有罪的权利,不得被迫对自己作证。 另请参见,Peoplev。Ramsell,266 Ill.App.3d 297,640 N.E. 2d 975(2d Dist。 1994)(无需在听证会上没有出庭而被指控犯有刑事罪的律师“表明”原因,为什么他不con视,因为这是“这相当于证明负担的不允许转移”)。Marcisz诉Marcisz,65 Ill.2d 206,357 N.E. 2d 477(1976)刑事蔑视旨在保存法院的尊严和权威,并试图惩罚。民事蔑视旨在执行私人当事方的权利,并迫使服从命令或法令,以利用反对党的利益。命令在蔑视法院违反离婚法令中的禁令是犯罪而不是民事的命令,因为它旨在维护法院的尊严和权威,并惩罚被告过去的违法行为;因此,被告有权通知,合理的辩护机会,律师的协助,在合理怀疑的情况下被证明有罪的权利,不得被迫对自己作证。另请参见,Peoplev。Ramsell,266 Ill.App.3d 297,640 N.E. 2d 975(2d Dist。1994)(无需在听证会上没有出庭而被指控犯有刑事罪的律师“表明”原因,为什么他不con视,因为这是“这相当于证明负担的不允许转移”)。

在线研究 @ Cardiff - Orca

哈里森,尼尔2023。炎症引起的奖励与惩罚敏感性的重新定位会被米诺环素衰减。大脑,行为和免疫力111,pp。320-327。10.1016/j.bbi.2023.04.010

通过选择性视觉注意有针对性地招募巴甫洛夫偏见

摘要 13 14 预期结果以“巴甫洛夫”的方式影响行为:奖励前景激发行动,而惩罚前景抑制行动。理论认为,巴甫洛夫偏见是陌生或无法控制的环境中整体行动的“先验”。然而,这种解释无法解释这些偏见的强度——即使在熟悉的环境中也会导致频繁的行动失误。我们认为,如果通过工具控制灵活地运用巴甫洛夫控制,它会更加有用。19 具体而言,工具行动计划可能会塑造对奖励/惩罚信息的选择性注意,从而影响巴甫洛夫控制的输入。在两个眼动追踪样本(N = 35/64)中,我们观察到 Go/NoGo 行动计划影响参与者关注奖励/惩罚信息的时间和时长,这反过来又以巴甫洛夫的方式影响他们的反应。23 注意力效应更强的参与者表现更高。因此,人类似乎将巴甫洛夫控制与其工具性行动计划结合起来,将其作用从行动默认值扩展到确保稳健行动执行的有力工具。 关键词:巴甫洛夫偏见;强化学习,眼动追踪;行动准备;注意力 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44

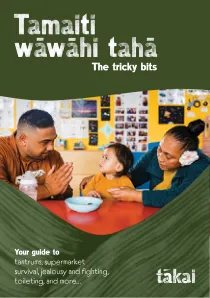

厕所培训技巧(PDF,第15-17页)棘手的位

当父母或照料者公平而坚定时,有动力,交流和尊重。非常严格会导致孩子们害怕父母。诸如打击之类的严厉惩罚通常会导致更具侵略性和具有挑战性的行为。

1-Corda-lageson.pdf

本文通过隐私权的角度探讨了美国的犯罪记录删除政策。开始进行从1950年代到2020年代的历史政策分析,它揭示了隐私权与刑事法律制度中康复和惩罚性意识形态和政策的变化潮之间不断发展的相互作用。分析表明,最初出现的隐私问题是对康复政策的沉默基础,在这些政策中,隐私被录取为康复的关键,但随后在“犯罪强硬”时代被驳回,在“强硬派”时期,重点是公共惩罚和公共惩罚和标签,以公共安全的名义。随后,文章认为,当代的进步是在犯罪记录的限制立法中,以及通过算法的自动记录清理过程的拥抱,在我们当前的时刻中找到了他们的根源,这些时刻强调了与刑事司法改革一起强调个人数据隐私。

Clemens Segur-Cabanac在第8条上的声明südwind关于就商业和人权的法律约束力进行谈判

因此,我们需要将第8条的第8.2点更改为“本条中的犯罪,民事或行政”,以确保不仅对公司进行惩罚,还可以通过民事责任确保对受害者的赔偿。这对于全球供应链上的数百万工人和农民来说至关重要

arXiv:2501.07502v1 [cs.LG] 2025 年 1 月 13 日

强化学习 (RL) 是决策制定中的一种常用工具,它根据相关的累积回报/奖励从各种经验中学习策略,而不会对它们进行区别对待。相反,人类通常会学会区分不同的绩效水平,并提取潜在趋势,以改善他们的决策,从而获得最佳绩效。受此启发,本文提出了一种新颖的 RL 方法,通过区分收集到的经验来模仿人类的决策过程,从而进行有效的策略学习。主要思想是从具有不同绩效水平的经验中提取重要的方向性信息(称为评级),以便可以更新策略以使其偏离具有不同评级的经验。具体而言,我们提出了一种新的策略损失函数,该函数惩罚当前策略与具有不同评级的失败经验之间的分布相似性,并根据评级类别为惩罚项分配不同的权重。同时,来自这些评级样本的奖励学习可以与新的策略损失相结合,以实现来自评级样本的综合奖励和策略学习。优化综合奖励和策略损失函数将导致发现策略改进的方向,即最大化累积奖励,对最低绩效水平惩罚最多,对最高绩效水平惩罚最少。为了评估所提方法的有效性,我们在几个典型环境中进行了实验,结果表明,与现有的仅基于奖励学习的基于评级的强化学习方法相比,该方法的收敛性和整体性能都有所提高。

![arXiv:2501.07502v1 [cs.LG] 2025 年 1 月 13 日](/simg/8\874bffd147cf2c1d48854fba2a925698143a2659.png)