XiaoMi-AI文件搜索系统

World File Search System2024 年 2 月 12 日 052-COM-1361 伪装自己和......

绩效衡量标准 允许 不允许 N/A 1. 在整个伪装行动中应用伪装原则。 a. 采用逼真的伪装。 b. 应用伪装运动技术。 c. 打破常规形状。 d. 通过遮盖或移除可能反射光线的物品来减少可能的反光。 e. 与周围环境混合颜色,或至少确保颜色与背景不形成对比。 f. 采用噪音控制。 2. 伪装您暴露的皮肤。 a. 使用油漆棒遮盖皮肤油脂,即使您的皮肤很黑。 b. 在脸上涂漆时使用表格 052-COM-1361-1 中的颜色图表。 c. 用深色涂高、有光泽的区域(前额、颧骨、鼻子、耳朵、下巴)。 d. 用浅色涂低、阴影区域(眼睛周围、鼻子下方和下巴下方)。在颈后、手臂和手部裸露的皮肤上涂上不规则的图案。 3. 伪装您的制服和头盔。 a. 卷起您的袖子并扣上所有纽扣。 b. 将树叶、草、小树枝或 LCSS 碎片贴在您的制服和头盔上。 c. 穿着未上浆的 ACU。 d. 更换过度褪色和磨损的 ACU,因为伪装效果已丧失。 4. 伪装您的个人装备。 a. 遮盖或移除闪亮的物品。 b. 固定移动或佩戴时会发出嘎嘎声或噪音的物品。 c. 使用天然物品和/或 LCSS 破坏大型和笨重装备的形状。 5. 维护伪装。 a. 当天然伪装失效并失去效力时更换它。 b. 当伪装褪色时更换它。 c. 更换伪装以适应不断变化的环境。

旅游局希望游客人数超过 2000 万 - 澳门日报

凯西·菲斯勒 科罗拉多大学 随着公众对人工智能的伦理和社会影响的担忧日益加深,似乎是时候放慢脚步了。但在科技公司内部,这种情绪却截然相反。据《纽约时报》报道,随着科技巨头的人工智能竞赛升温,微软一位高管在一封关于生成式人工智能的内部电子邮件中写道,如果“现在担心以后可以修复的事情,那将是一个绝对致命的错误”。换句话说,用马克·扎克伯格的旧座右铭来说,是时候“快速行动,打破常规”了。当然,当你破坏了一些东西时,你可能不得不以后再修复它们——这是有代价的。在软件开发中,“技术债务”一词指的是由于现在选择更快、更不谨慎的解决方案而导致未来修复的隐含成本。急于上市可能意味着重新发布尚未准备好的软件,因为你知道一旦它进入市场,你就会发现其中的缺陷,并希望能够修复它们。然而,关于生成式人工智能的负面新闻往往与这些缺陷无关。相反,人们更担心人工智能系统会放大有害的偏见和刻板印象,以及学生欺骗性地使用人工智能。我们听说过隐私问题、人们被错误信息欺骗、劳动力剥削以及对人类工作可能被取代的速度的担忧,等等。这些问题不是软件故障。意识到一项技术会强化压迫或偏见与发现网站上的某个按钮不起作用是截然不同的。作为一名技术伦理教育者和研究人员,我对这类“缺陷”思考了很多。这里累积的不仅仅是技术债务,还有道德债务。正如技术债务可能源于开发过程中的有限测试一样,道德债务源于没有考虑可能的缺陷

旅游局希望游客人数超过2000万 - 澳门日报

凯西·菲斯勒 科罗拉多大学 随着公众对人工智能的伦理和社会影响的担忧日益加深,似乎是时候放慢脚步了。但在科技公司内部,这种情绪却截然相反。据《纽约时报》报道,随着科技巨头的人工智能竞赛升温,微软一位高管在一封关于生成式人工智能的内部电子邮件中写道,如果“现在担心以后可以修复的事情,那将是一个绝对致命的错误”。换句话说,用马克·扎克伯格的旧座右铭来说,是时候“快速行动,打破常规”了。当然,当你破坏了一些东西时,你可能不得不以后再修复它们——这是有代价的。在软件开发中,“技术债务”一词指的是由于现在选择更快、更不谨慎的解决方案而导致未来修复的隐含成本。急于上市可能意味着重新发布尚未准备好的软件,因为你知道一旦它进入市场,你就会发现其中的缺陷,并希望能够修复它们。然而,关于生成式人工智能的负面新闻往往与这些缺陷无关。相反,人们更担心人工智能系统会放大有害的偏见和刻板印象,以及学生欺骗性地使用人工智能。我们听说过隐私问题、人们被错误信息欺骗、劳动力剥削以及对人类工作可能被取代的速度的担忧,等等。这些问题不是软件故障。意识到一项技术会强化压迫或偏见与发现网站上的某个按钮不起作用是截然不同的。作为一名技术伦理教育者和研究人员,我对这类“缺陷”思考了很多。这里累积的不仅仅是技术债务,还有道德债务。正如技术债务可能源于开发过程中的有限测试一样,道德债务源于没有考虑可能的缺陷

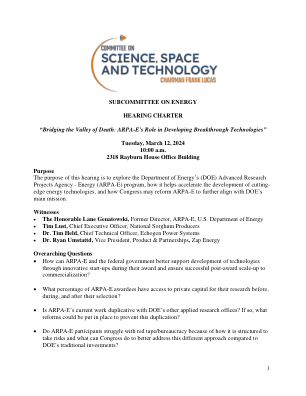

ARPA-E 在开发突破性技术中的作用

背景 2005 年,美国国家科学院 (NAS) 发布了《超越风暴:为更光明的经济未来注入活力和活力》,以响应国会提出的确定可促进科学技术的联邦行动的要求。1 该报告建议美国应“维持和加强国家对长期基础研究的传统承诺,这些研究有可能带来变革,以保持新思想的流动,从而推动经济发展、提供安全保障并提高生活质量。” 2 此外,NAS 报告建议在 DOE 内设立一个类似于国防高级研究计划局 (DARPA) 的机构。该机构旨在推动美国工业无法支持的创新和尖端能源研究——这些研究风险很高,但成功可能会对美国经济、环境和国家安全的关键挑战产生广泛影响。3 在本报告发布后,ARPA-E 根据《美国竞争法案》正式成立,该法案于 2007 年由乔治·W·布什总统签署成为法律。这项立法定义了 ARPA-E 的目标,即通过减少对外国能源的依赖和能源相关排放,以及通过提高所有经济部门的能源效率,增强美国的经济和能源安全。4 根据 NAS 的建议,《竞争法案》要求 ARPA-E 通过确定和促进基础科学研究的创新进展、转化这些进展和将发明转化为技术创新,并专注于技术或财务风险如此之高以至于私营企业不太可能追求的领域和问题。5 该机构最近一次更新是通过《2020 年能源法案》的重新授权。与能源部内的其他机构相比,ARPA-E 在招聘实践和项目方法上是独一无二的。与 DARPA 一样,ARPA-E 吸引了来自工业界、国家实验室和大学的人才担任项目主任。这些专家的任期限制为三到五年,这激励了“快速行动,打破常规”的创新方式。此外,ARPA-E 的项目与应用和基础科学项目中的传统项目方法有很大不同。考虑到主任的任期长度,ARPA-E 的项目很短,只持续几年。因此,他们对技术创新和市场趋势反应灵敏,非常有利于创新。6 ARPA-E 提供两种类型的项目:开放式和重点式。开放式项目征集任何具有变革潜力的想法的申请,而重点项目则解决特定的能源挑战。

人工智能在...中的机遇与风险

执行摘要 人工智能 (AI) 技术有可能为投资者和投资公司带来机遇。对于投资者而言,AI 可以扩大获得更高质量产品和服务的渠道,提高市场参与度,降低成本,改善用户体验,增强决策能力,并最终提供更好的结果。对于公司而言,AI 可以提高效率和生产力,改善资源配置和客户服务,并增强风险管理和法规遵从性。然而,使用 AI 也存在潜在风险,包括“AI 清洗”、面向散户投资者的产品和服务不完善、“黑匣子”风险、模型和数据风险、缺乏对 AI 相关风险的明确披露、偏见和利益冲突、隐私问题、对第三方服务提供商的尽职调查和监控不足、系统性风险以及助长不良行为者的恶意行为。如果公司在开发和部署基于 AI 的产品和服务时采取“快速行动,打破常规”的心态,这些风险将会升级。如果 AI 以极快的速度和规模部署,潜在的危害可能会非常迅速地影响大量人群并波及整个经济。人工智能技术的快速发展也可能使监管机构难以跟上步伐。监管机构面临的一个挑战是,市场参与者使用基于人工智能的工具的方式在技术上是合法的,但仍然会损害投资者或市场诚信。另一个挑战是,市场参与者使用基于人工智能的工具从事监管机构难以发现的非法活动。缺乏数据和模型透明度可能会增加监管机构发现不当行为的难度。如果监管机构没有足够的资源来监控和处理人工智能的有害使用,这些挑战将会加剧。监管机构和市场参与者必须采取主动而不是被动的方法来应对这些风险。除了定期与所有利益相关者接触外,监管机构还应利用其审查和监督权力来了解公司如何开发和部署人工智能技术。监管机构还应开发自己的技术来检测市场上对人工智能技术的滥用。为此,监管机构需要足够的资源。公司还必须采取有意义的措施,确保他们开发和部署基于人工智能的工具不会损害投资者或市场诚信。如果复杂性、不透明性、不可靠性、偏见、利益冲突或数据不安全影响到人工智能应用,投资者可能会收到次优的产品和服务,损害他们的财务安全,并更广泛地削弱他们对基于人工智能的工具和投资市场的信任和信心。然而,如果公司和监管机构采取积极主动的方法来应对这些风险,人工智能的潜力就可以得到充分发挥。