XiaoMi-AI文件搜索系统

World File Search System任何时间图像生成的嵌套扩散过程

扩散模型是生成时期的当前最新模型,它通过将生成过程分解为许多细粒度的排除步骤,从而综合了高质量的图像。尽管其性能良好,但扩散模型在计算上还是需要许多Neu-ral功能评估(NFES)。在这项工作中,我们提出了一种基于扩散的方法,该方法在完成前在任意时间停止时可以生成可行的图像。使用现有的预处理扩散模型,我们表明可以将生成方案重新组成为两个嵌套扩散过程,从而可以快速迭代的迭代细化。在实验和基于稳定的基于扩散的文本对图像生成的实验中,我们在定性和定量上都表明,我们的方法的相互作用质量大大超过了原始扩散模型的质量,而最后一代结果仍然可比。我们说明了嵌套扩散在多种设置中的适用性,包括用于求解逆概率,以及在整个采样过程中允许用户干预,用于快速基于文本的内容创建。1

提示文本到图像扩散模型的迅速反转

提供给文本对图像差异模型的提示的质量决定了生成的内容对用户意图的忠诚程度,通常需要“及时工程”。要通过及时的工程来利用目标图像的视觉概念,当前方法在很大程度上通过优化然后将它们映射到伪tokens来依赖嵌入反演。然而,使用这种高维矢量表示是具有挑战性的,因为它们缺乏语义和可解释性,并且只允许使用它们时模拟矢量操作。相反,这项工作着重于反转扩散模型,以直接获得可靠的语言提示。这样做的挑战在于,由此产生的优化问题从根本上是离散的,提示的空间呈较大。这使得使用标准优化技术,例如随机梯度下降,困难。为此,我们利用延迟的投影方案来访问代表模型中词汇空间的提示。此外,我们利用了扩散过程的时间段与图像中不同级别的细节相差的发现。后来的,嘈杂的,前传扩散过程的时间段对应于语义信息,因此,此范围内的迅速反转提供了代表图像语义的令牌。我们表明,我们的方法可以确定目标图像的语义可解释和有意义的提示,该提示可用于合成具有相似内容的多样化图像。我们说明了优化提示在进化图像生成和概念删除中的应用。

雷达相机3D对象检测的强大扩散建模框架

雷达相机3D对象检测旨在与雷达信号与摄像机图像进行交互,以识别感兴趣的对象并定位其相应的3D绑定框。为了克服雷达信号的严重稀疏性和歧义性,我们提出了一个基于概率deno的扩散建模的稳健框架。我们设计了框架,可以在不同的多视图3D检测器上易于实现,而无需在训练或推理过程中使用LiDar Point Clouds。在特定的情况下,我们首先通过开发带有语义嵌入的轻质DENOIS扩散模型来设计框架编码器。其次,我们通过在变压器检测解码器的深度测量处引入重建训练,将查询降解训练开发为3D空间。我们的框架在Nuscenes 3D检测基准上实现了新的最新性能,但与基线检测器相比,计算成本的增加很少。

MatFuse:利用扩散模型实现可控材料生成

在计算机图形学中创建高质量的材质是一项具有挑战性且耗时的任务,需要很高的专业知识。为了简化这个过程,我们引入了 MatFuse,这是一种统一的方法,它利用扩散模型的生成能力来创建和编辑 3D 材质。我们的方法整合了多种条件来源,包括调色板、草图、文本和图片,增强了创造可能性并对材质合成进行了细粒度的控制。此外,MatFuse 通过多编码器压缩模型的潜在操作实现了地图级材质编辑功能,该模型可以学习每个地图的解开的潜在表示。我们在多种条件设置下展示了 MatFuse 的有效性,并探索了材质编辑的潜力。最后,我们根据 CLIP-IQA 和 FID 分数定量评估生成材质的质量,并通过开展用户研究定性评估生成材质的质量。用于训练 MatFuse 的源代码和补充材料可在 https://gvecchio.com/matfuse 上公开获取。

口服粘膜免疫:停止扩散大流行病毒的最终策略 由TLR7和TLR9介导的氧化态和先天免疫的作用在狼疮肾炎中 洞悉用于新型分子发现的光合微生物的共培养和增强的专业代谢产物 胰岛素抵抗在冠状动脉疾病患者中冠状动脉搭桥术后并发症发展中的作用 与废物管理计划的闭环供应链中的决策:制造商的背包活动和政府的再制造补贴 口腔癌中的DNA氧化损伤:8-羟基-2 免疫和代谢在主动脉夹层中的独立和互动作用 阿尔茨海默氏病的血液 - 脑屏障崩溃

全球大流行很可能是通过人畜共患病传播到人类的,其中呼吸道病毒感染与粘膜系统相关的气道。在已知的大流行中,五个是由包括当前正在进行的冠状病毒2019(Covid-19)在内的呼吸道病毒引发的。在疫苗开发和治疗剂中的惊人进步有助于改善传染剂的死亡率和发病率。然而,生物体复制和病毒通过粘膜组织传播,不能由肠胃外疫苗直接控制。需要一种新型的缓解策略,以引起强大的粘膜保护并广泛中和活动以阻碍病毒进入机制并抑制传播。本综述着重于口腔粘膜,这是病毒传播的关键部位,也是引起无菌免疫力的有希望的靶标。除了审查人畜共患病毒病毒和口腔粘膜组织发起的历史大流传学外,我们还讨论了口服免疫反应的独特特征。我们解决了与开发新型治疗剂有关以在粘膜水平引起保护性免疫的障碍和新的前景,以最终控制传播。

具有深层生成模型的扩散加权磁共振大脑图像的现实产生

深度学习方法有可能减轻放射科医生处理繁琐的,耗时的任务,例如检测和细分病理病变[1],但是在医学成像的背景下对神经网络的培训面临着主要的挑战:它们需要训练大量图像,因为这是很难获得的,因为在许多方面都可以限制医疗信息,并且由于许多方面的范围限制了其他方面的范围。此外,虽然在世界各地的医院数据库中可以提供相对较大的医学图像,但这些图像是未标记的,并且不同的机构以派遣和不均匀的方式保存医疗图像,这使得它们在较大的数据库中收集它们。在这种情况下,从头开始生成医学图像的方法可能引起人们的极大兴趣。生成建模是机器学习的一个子字段,它在产生新的高质量自然图像(例如面部照片[2])方面具有令人印象深刻的精力[2],并应用于语音综合[3]和磁共振图像重建等任务[4]。如果可以教导生成模型来产生现实且多样化的新医学图像,那么它们将具有很有吸引力的潜力,可以显着增加可用于深神经网络培训的图像数量,因此可以帮助提高这些网络的准确性[5-7]。

重新思考多重对比 MRI 超级扩散模型...

最近,扩散模型 (DM) 已应用于磁共振成像 (MRI) 超分辨率 (SR) 重建,并表现出令人印象深刻的性能,尤其是在细节重建方面。然而,当前基于 DM 的 SR 重建方法仍然面临以下问题:(1)它们需要大量迭代来重建最终图像,效率低下且消耗大量计算资源。(2)这些方法重建的结果通常与真实的高分辨率图像不一致,导致重建的 MRI 图像出现明显失真。为了解决上述问题,我们提出了一种用于多对比 MRI SR 的有效扩散模型,称为 DiffMSR。具体而言,我们在高度紧凑的低维潜在空间中应用 DM 来生成具有高频细节信息的先验知识。高度紧凑的潜在空间确保 DM 只需要几次简单的迭代即可产生准确的先验知识。此外,我们设计了 Prior-Guide Large Window Transformer (PLWformer) 作为 DM 的解码器,它可以扩展感受野,同时充分利用 DM 产生的先验知识,以确保重建的 MR 图像保持不失真。在公共和临床数据集上进行的大量实验表明,我们的 DiffMSR 1 优于最先进的方法。

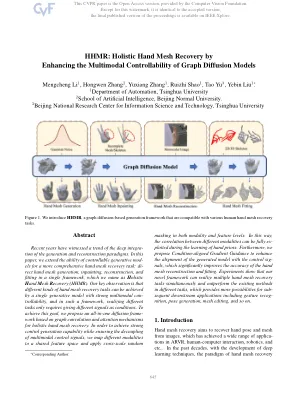

HHMR:通过增强图扩散模型的多模式可控性

近年来见证了一代和重建范式深入融合的趋势。在本文中,我们扩展了可控制的生成模块的能力,以实现更全面的手网恢复任务:在单个框架中,手工网格的生成,内部网状,重建,重建和拟合,我们将其命名为H olistic H和MESH R Ecovery(HHMR)。我们的主要观察结果是,具有强大多模式可偿还性的单个生成模型可以实现不同类型的手网恢复任务,并且在这样的框架中,实现不同的任务只需要给出不同的信号作为条件。为了实现这一目标,我们提出了基于图形卷积和整体手工网状恢复的注意力卷积和注意力机制的多合一扩散框架。为了实现强大的控制能力,同时确保多模式控制信号的解耦,我们将不同的模态映射到共享特征空间并应用跨尺度随机

稳定扩散启用水下深度估计

单眼深度估计在近年来,由于深度学习的进步,近年来在陆地图像上取得了重大进展。,但主要是由于数据稀缺性而导致的水下场景不足。鉴于水中的光衰减和背面的固有挑战,获得清晰的水下图像或精确的深度非常困难且昂贵。为了减轻此问题,基于学习的方法通常依赖于综合数据或转向自欺欺人或无监督的举止。尽管如此,它们的性能通常受到域间隙和宽松的约束而阻碍。在本文中,我们提出了一种新的管道,用于使用准确陆地深度生成感性的水下图像。这种方法有助于对水下深度估计的模型进行超级培训,从而有效地降低了限制和水下环境之间的性能差异。与以前的合成数据集相反,这些数据集仅将样式转移应用于没有场景内容的情况下的Terres试验图像,我们的方法通过通过创新的STA-