XiaoMi-AI文件搜索系统

World File Search System社论:为下一代物联网应用提供动力

大脑是一个重达 3 磅、可以轻松握在手掌中的组织,它具有固有的计算复杂性,这一直激励着人们努力为具有大脑某些卓越特性的机器背书。具有讽刺意味的是,尽管大脑与模拟或数字计算机共享关键概念,但与模拟或数字计算机相比,大脑的计算方式却独树一帜。大脑采用模拟计算,但通过脉冲进行数字通信,这两种方式都提高了对噪声的鲁棒性。这种独特的组合定义了一种我们刚刚开始探索的新型计算范式。神经形态系统成为增长最快的应用之一的原因不仅仅是科学,而主要是技术。50 年来,指导计算的原理一直是摩尔定律,这是一个宏观观察,我们将始终找到方法来设计更快、更小、更便宜的芯片。但有几个原因导致摩尔定律不再适用。首先是物理学:随着我们将晶体管缩小到接近原子尺度,调节电子流变得越来越困难。电子不一定遵循牛顿物理学,可能会穿过晶体管屏障,这种现象称为量子隧穿。这使我们的计算机架构效率低下。其次,我们早就接受了计算速度更快和功耗更低之间存在权衡这一事实,但直到我们开始接近制造晶体管的物理极限,这才成为问题。而摩尔定律的最后一颗钉子是由深度学习打下的。我们的

人工智能的法律问题 (v. 3.0)

1.变化的速度。摩尔定律——计算机芯片上可容纳的晶体管数量每两年翻一番的观察结果——长期以来一直是计算机技术变化速度的代名词。但摩尔定律并没有捕捉到人工智能(“AI”)当前变化速度的程度。训练最复杂算法所需的计算机处理能力(通常称为“计算”)现在每 3.5 个月翻一番。2012 年至 2018 年间,最苛刻模型的计算要求增加了 300,000 倍 2,到 2019 年中期,估计训练单个复杂算法的成本(以计算和电力计算)可能超过 300 万美元。3 这种飞速的变化意味着人工智能正在成为“第四次工业革命”的主要驱动力,这一术语(继蒸汽、电力和计算之后)由达沃斯创始人克劳斯·施瓦布为目前正在进行的深度数字化转型而创造。4

追踪极紫外光刻技术的出现

仔细研究支持 EUV 开发的研究界对于当今的政策制定者和半导体行业尤其重要。EUV 研究始于 20 世纪 80 年代,当时美国半导体行业在双方政府的大力干预下试图抵御崛起的日本公司。与此同时,该行业认识到,新一代光刻光源对于制造未来的先进芯片以维持摩尔定律是必不可少的。今天也存在类似的情况,美国、欧洲和亚洲的政策制定者都在进行千载难逢的努力来保护和促进各自的半导体行业,而崛起的中国公司则试图挑战行业领导者。与此同时,整个半导体行业都认识到一场缓慢发展的生存危机:人工智能的快速发展必须由相应的计算能力的快速发展来维持。然而,摩尔定律的终结就在眼前,即使是 EUV 也无法拯救它。4

计算机体系结构的新黄金时代

▪ 逻辑、RAM、ROM 都使用相同的晶体管实现 ▪ 半导体 RAM ~ 与 ROM 速度相同 ▪ 根据摩尔定律,控制存储的内存可以增长 ▪ 由于 RAM,更容易修复微代码错误 ▪ 允许更复杂的 ISA(CISC) ▪ 小型计算机(TTL 服务器)示例:

量子错误校正代码

在过去的三十年中,由于硅芯片的发展,传统计算机的开发增加了100,000倍。这是所谓的摩尔定律[1],它预测微芯片上的晶体管数量每两年翻倍。但是,专家们同意,计算机应在2020年代的某个时候达到摩尔定律的物理极限[2]。传统计算机的第二个问题是,正如Feynman所指出的那样,在模拟古典计算机上模拟量子机械系统时,似乎有必要的差异。因此,我们需要紧急设计量子计算机。,但噪声始终是信息过程系统的巨大祸根。保护信息免受噪声的影响非常重要,尤其是噪声对量子计算机的影响比分类计算机更大。已经有一个非常完整的经典误差校正理论[3]。但是现有的量子误差校正方法是不够的。由于无用定理[4]和波函数崩溃,量子信息不能以与经典信息相同的方式复制。所有这些分歧和挑战都要求我们构建一种新的理论,即量子误差理论。

1 4.2. Si CMOS 平台:辐射 Lloyd W. Massengill,......

3 由于集成电路技术的缩放早已脱离了严格的恒定场或经典的电压缩放,因此本章中使用“摩尔定律缩放”一词作为尺寸缩放、能量缩放和新材料引入的总称——所有这些都是为了实现英特尔联合创始人戈登·摩尔在 1965 年描述的功能进展。

网络法-i

包括半导体和晶体管的发明。技术的稳定进步导致戈登·摩尔(Intel的联合创始人)声明他的信念,即工程师能够每两年将计算机芯片上的晶体管数量增加一倍。这种观察被称为摩尔定律,于1975年进行了,在过去的四十年中一直保持原样。这意味着计算机芯片的速度(处理能力)稳定增长,使笔记本电脑更强大,将智能手机变成手持计算机,并允许Google搜索的速度永远使用。存储更高的连接性和速度很不错,但是它们的意思很少,没有存储。如果可以发送和收到但未存储和检索的电子邮件,文本,电子表格或文档有什么好处?存储容量已经接近与摩尔定律相匹配的(即每两年大约翻一番),因为硬盘驱动器已从千兆字节转变为trabytes并继续增长。存储不仅涉及容量,还涉及性能,这是存储设备的输入/输出速度。的性能随着过渡而显着提高。存储使互联网用户可以下载和保留音乐,视频和图片。

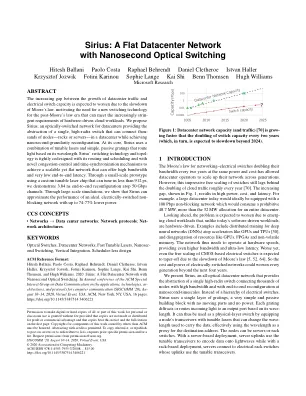

Sirius:具有纳秒光交换的扁平数据中心网络

由于摩尔定律的放缓,数据中心流量增长与电气交换机容量之间日益扩大的差距预计会进一步扩大,这促使人们需要一种新的交换技术来满足后摩尔定律时代日益严格的硬件驱动型云工作负载要求。我们提出了 Sirius,这是一种用于数据中心的光交换网络,它提供了一个单一的高基数交换机的抽象,可以连接数据中心中的数千个节点(机架或服务器),同时实现纳秒级的重新配置。在其核心,Sirius 使用可调激光器和简单的无源光栅的组合,可根据波长路由光。Sirius 的交换技术和拓扑与其路由和调度以及新颖的拥塞控制和时间同步机制紧密结合,以实现可扩展但平坦的网络,可提供高带宽和非常低的端到端延迟。通过使用可在 912 ps 内完成调谐的定制可调激光芯片的小型原型,我们展示了 50 Gbps 信道上 3.84 ns 的端到端重构。通过大规模模拟,我们表明 Sirius 的性能接近理想的电交换无阻塞网络,且功耗降低高达 74-77%。

引用:GQ Han 和 Y Hao,面向 3 纳米以下技术节点的设计技术协同优化[J]。J. Semicond.,2021,42(2),020301。http://doi.or

在过去的半个世纪里,摩尔定律在半导体领域的发展中扮演了至关重要的角色,而半导体领域的发展直接依赖于大约每两年一次的维度缩放。在每个技术节点上,微芯片的性能、功率、面积和成本 (PPAC) 都有望实现显著提升。然而,通过提高分辨率技术实现的激进间距缩放变得越来越难以维持。短沟道效应,例如高漏电流、漏极诱导势垒降低效应,会大大降低器件性能。因此,由于优越的静电可控性,器件架构从平面迁移到 3D 鳍状结构已被采用,以继续进一步缩放的步伐。目前,2020 年 5 纳米技术节点的栅极长度已令人难以置信地缩小到 12 纳米以下,接近量子力学极限。为了解决持续缩放问题,已经开发出一种工艺流程和设计定义之间的联合设计技术协同优化 (DTCO) 工作,它有助于通过及早识别缩放瓶颈并找到不会给设计或工艺点带来过重负担的路径来管理先进技术节点的提升。借助这种方法,摩尔定律可以继续推动其向 3 纳米以下节点迈进。

![引用:GQ Han 和 Y Hao,面向 3 纳米以下技术节点的设计技术协同优化[J]。J. Semicond.,2021,42(2),020301。http://doi.or](/simg/2\28acddce6f44f3281e206ba16d97d6c027ce9094.webp)