XiaoMi-AI文件搜索系统

World File Search SystemAI训练模型“HENRYETTA”

Henryetta 的视觉和触觉外观比任何其他训练设备都更自然。甚至可以模拟体温、气管或牛尾巴的处理。除了使用 Henryetta 作为培训模型有助于改善企业形象之外,将其引入 AI 课程还可以提高学习曲线。LIC 培训成功率的数据证实了这一事实。在 Henryetta 发明之前,只有 55% 的学员通过了技术员培训的第一周。在 Henryetta 的帮助下,这一比例在接下来的几年里提高到了 80% 以上。

利用轻量级预训练模型进行脑肿瘤检测

摘要。本研究分析了两种用于脑肿瘤检测的深度学习模型:轻量级预训练的 MobileNetV2 和将轻量级 MobileNetV2 与 VGG16 相结合的新型混合模型。目的是研究这些模型在准确性和训练时间方面的性能和效率。新的混合模型整合了两种架构的优势,利用了 MobileNetV2 的深度可分离卷积和 VGG16 的更深层特征提取功能。通过使用公开的基准脑肿瘤数据集进行实验和评估,结果表明,与独立的 MobileNetV2 模型相比,混合模型的训练准确率和测试准确率分别达到 99% 和 98%,即使在较低的 epoch 中也是如此。这种新型融合模型为增强脑肿瘤检测系统提供了一种有前途的方法,在减少训练时间和计算资源的情况下提高了准确性。

从分子预训练模型中提取训练数据

图形神经网络(GNN)已显着提高了药物发现领域,从而提高了分子鉴定的速度和效率。但是,培训这些GNN需要大量的分子数据,这促使了协作模型共享计划的出现。这些举措促进了在组织中共享分子预培训模型的情况,而无需暴露专有培训数据。尽管有好处,但这些分子预训练的模型仍可能带来隐私风险。例如,恶意对手可以执行数据提取攻击以恢复私人培训数据,从而威胁商业秘密和协作信任。这项工作首次探讨了从分子预训练模型中提取私人训练分子数据的风险。这项任务是非凡的,因为分子预训练的模型是非生成性的,并且表现出多种模型架构,这与语言和图像模型明显不同。为了解决这些问题,我们引入了一种分子生成方法,并提出了一种新颖的,独立于模型的评分函数,以选择有希望的分子。为了有效地减少潜在分子的搜索空间,我们进一步引入了一个分子提取策略网络,以进行分子提取。我们的实验表明,即使仅查询分子预先训练的模型,也存在提取培训数据的很大风险,这挑战了这样的假设,即单独模型共享提供了足够的保护,以防止数据提取攻击。我们的代码可在以下网址公开获取:https://github.com/ molextract/data-extraction-from-molecular-molecular-pre-preated-model-model。

利用预训练模型进行最近邻药物靶标亲和力预测

药物-靶标结合亲和力 (DTA) 预测对于药物发现至关重要。尽管将深度学习方法应用于 DTA 预测,但所获得的准确度仍然不理想。在这项工作中,受到最近检索方法成功的启发,我们提出了 𝑘 NN-DTA,这是一种基于非参数嵌入的检索方法,采用预先训练的 DTA 预测模型,它可以扩展 DTA 模型的功能,而无需或几乎不需要任何成本。与现有方法不同,我们从嵌入空间和标签空间引入了两种邻居聚合方法,并将它们集成到一个统一的框架中。具体而言,我们提出了一种具有成对检索的标签聚合和一种具有逐点检索最近邻居的表示聚合。该方法在推理阶段执行,并且可以在无需训练成本的情况下有效提高 DTA 预测性能。此外,我们提出了一个扩展,Ada-𝑘 NN-DTA,一种具有轻量级学习的实例化和自适应聚合。在四个基准数据集上的结果

使我成为BNN:从预训练模型估算贝叶斯不确定性

其中矩阵w(j)µ和w(j)σ表示层j,j j〜n(0,1)的后验分布的平均值和标准偏差,而操作员norm(β,βJ,γJ),可训练的参数βJ和γj的均值和标准偏差,可以指代任何批次,层,层,层,层或实例化。

BaGuaLu:以超过 3700 万个核心为目标的大脑规模预训练模型

摘要 大规模预训练人工智能模型在一系列重要应用中展现出了极高的准确率。为了实现更高的准确率,预训练人工智能模型的规模每年都在大幅增长,而训练此类模型需要海量的计算和内存能力,这加速了人工智能与高性能计算的融合。然而,在高性能计算系统上部署人工智能应用仍存在不足,需要基于特定硬件特性进行应用和系统协同设计。为此,本文提出了八卦炉1号,这是第一个在百亿亿次超级计算机——新一代神威超级计算机上训练脑规模模型的工作。通过结合针对硬件的节点内优化和混合并行策略,八卦炉在前所未有的大型模型上实现了良好的性能和可扩展性。评估显示,八卦炉可以使用混合精度训练14.5万亿参数模型,性能超过1 EFLOPS,并且有能力训练174万亿参数模型,其数量堪比人脑的突触数量。

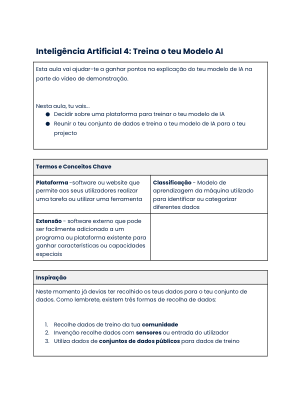

人工智能 4:训练您的 AI 模型 - Technovation

网上有很多平台可用于训练人工智能模型。大多数平台的工作方式类似。您输入数据(可以通过上传或使用网络摄像头拍摄图像),然后训练模型,最后进行测试以确保其准确性。选择使用哪个平台取决于您的项目以及您在训练模型后想要用模型做什么。它们都允许您创建对事物进行分类或归类的 AI 模型,这就是它们被称为分类系统的原因。

BIM集成与机器学习中的图像处理

1。上传包含裂缝的图像以及没有裂缝的图像。2。标记每个图像以指示哪些图像包含裂纹。3。一旦您上传并标记了足够的图像,就可以训练模型。4。单击自定义视觉网站上的“火车”按钮以训练分类器。5。培训完成后,评估模型的性能,以查看诸如准确性和召回等指标。6。如果性能很差,则可能需要上传更多图像并重新训练模型。