XiaoMi-AI文件搜索系统

World File Search System映射生成 - ai-ai-rules and-liability-scenarios in-thin-thin-...

摘要本文旨在探讨欧盟现有和仍将采用的有关人工智能(AI)系统的现有和仍采用的规则的生态系统是否充分而充分地解决了生成AI系统造成的损害的责任。它首先映射,主要是生成AI的独特特征和功能特征,可能会影响监管和法律考虑因素,尤其是在确定有关生成AI的特定监管制度以及根据AI法案沿着价值链的追踪和分配责任。在此映射练习的基础上,本文着重于测试为人工智能责任指令草案和修订的产品责任指令提供的责任规则,并在面对生成AI时评估其充分性和有效性。除了对上述文本中规定的规则进行评估之外,该论文简要介绍了将来的作品中要探讨的其他责任方案。

人工智能的责任 - 欧洲议会

人工智能和其他新兴数字技术,如物联网或分布式账本技术,有可能使我们的社会和经济变得更好。然而,这些技术的推出必须配备足够的保障措施,以最大限度地降低这些技术可能造成的危害风险,如人身伤害或其他伤害。在欧盟,产品安全法规确保了这一点。然而,这些法规不能完全排除因使用这些技术而造成损害的可能性。如果发生这种情况,受害者将寻求赔偿。他们通常根据私法、特别是侵权法下的责任制度寻求赔偿,可能还会结合保险。只有生产者对缺陷产品的严格责任(仅占此类责任制度的一小部分)在欧盟层面由《产品责任指令》协调,而所有其他制度(特定行业或特殊立法下的某些例外情况除外)均由成员国自己监管。

SPT 1800 系列快速参考指南

© 2001 SYMBOL TECHNOLOGIES, INC. 保留所有权利。Symbol 保留对任何产品进行更改以改善可靠性、功能或设计的权利。Symbol 不承担因本文所述任何产品、电路或应用的应用或使用而产生的或与之相关的任何产品责任。不以明示或暗示、禁止反言或其他任何专利权或专利授予任何许可,涵盖或涉及可能使用 Symbol 产品的任何组合、系统、设备、机器、材料、方法或流程。仅对 Symbol 产品中包含的设备、电路和子系统存在暗示许可。Symbol 和 Symbol 徽标是 Symbol Technologies, Inc. 的注册商标。本手册中提及的其他产品名称可能是其各自公司的商标或注册商标,特此声明。Symbol Technologies, Inc. One Symbol Plaza Holtsville, N.Y. 11742-1300 http://www.symbol.com

行为科学

鉴于医学和健康方面的持续,快速进步,独立的医学诊断,适应症,适当的药物选择和剂量以及治疗方案,应进行医疗保健方面的选择。When prescribing medication, healthcare pro essionals are advised to consult the product in ormation sheet (the manu acturer's package insert) accompanying each drug to veri y, among other things, conditions o use, warnings and side e ects and identi y any changes in dosage schedule or contraindications, particularly i the medication to be administered is new, in requently used or has a narrow therapeutic range.在适用法律允许的最大范围内,出版商或对人员或财产的任何伤害和/或损害都不承担任何责任,因为o产品责任,疏忽法或其他责任,或其他任何人对此工作的任何责任。

人工智能责任指令提案

人工智能(以下简称“AI”)越来越多地出现在消费者的日常生活中,预计将为他们带来诸多好处。它可以为新产品和服务提供动力,帮助让日常生活变得更轻松、更轻松,例如通过个性化服务、增强现实应用、有助于更快检测疾病的人工智能医疗工具或自动驾驶汽车。然而,人工智能的广泛使用也给消费者带来了重大挑战和风险。其中一个关键问题是,如果出现问题,消费者因人工智能系统而遭受损失,谁来承担责任。由于人工智能的特殊性,例如其复杂性、不透明性、自主性,以及其生命周期中涉及的参与者数量,消费者将很难就人工智能系统造成的任何损害索取赔偿。消费者可能很难识别人工智能系统造成的损害,例如,由于人工智能系统的偏见标准而拒绝以较低的价格投保,消费者看不到这一点。消费者甚至可能不知道人工智能系统在特定决策中发挥了作用,并且是造成损害的原因。现行的欧盟产品责任指令 1(以下简称“PLD”)不适合应对包括人工智能在内的新技术带来的挑战。该指令于 1985 年首次通过,当时市场上的产品与今天的产品截然不同。为了解决这些问题,欧盟委员会于 2022 年 9 月发布了两项提案,以使欧盟责任规则适应数字环境:一项是修订产品责任指令 2 的提案(以下简称“PLD 提案”),另一项是使国家责任规则适应人工智能 3 带来的挑战的提案(以下简称“AILD 提案”)。BEUC 正在两份单独的立场文件中讨论这两个提案。本文重点介绍 AILD 提案。我们对 PLD 提案的立场可以在此处阅读。在这两份立场文件中,我们都提出了几项政策建议,以确保这两个提案创建一个连贯的法律框架,为消费者提供高水平的保护。

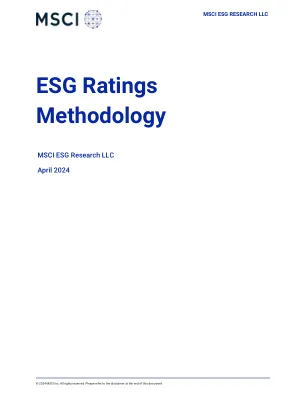

ESG 评级方法

3 个支柱 10 个主题 33 个 ESG 关键问题 环境 气候变化 碳排放 气候变化脆弱性 融资 环境影响 产品碳足迹 自然资本 生物多样性和土地利用 原材料采购 水资源压力 污染和废弃物 电子废弃物 包装材料和废弃物 有毒排放和废弃物 环境机遇 清洁技术机遇 绿色建筑机遇 可再生能源机遇 社会 人力资本 健康与安全 人力资本发展 劳动力管理 供应链 劳工标准 产品责任 化学品安全 消费者金融保护 隐私和数据安全 产品安全和质量 负责任的投资 利益相关者反对 社区关系 有争议的采购 社会机遇 融资渠道 医疗保健渠道 营养与健康机遇 治理 公司治理 董事会薪酬 所有权和控制权 会计 公司行为 商业道德 税收透明度

农业与农村发展委员会

人工智能(AI)责任在全球和欧盟的十字路口处于十字路口。虽然从数据保护到非歧视的几项现有法律,对某些类型的AI易于危害确定责任,AI ACT和修订后的产品责任指令(PLD)是欧盟级别上的前两个法律工具,专门针对整个AI价值链中的AI系统实施全面的综合义务。在此背景下,欧洲委员会与PLD修订一起提出的人工智能责任指令(AILD)面临着关于它如何适应这个新颖的监管框架的一些挑战。无疑,AI具有从癌症筛查到欺诈检测和预防事故的巨大潜力,但也带来风险。但是,PLD并未充分涵盖广泛的AI特异性风险,尤其是与生成AI有关的风险,例如歧视和侵犯人格权利的风险。

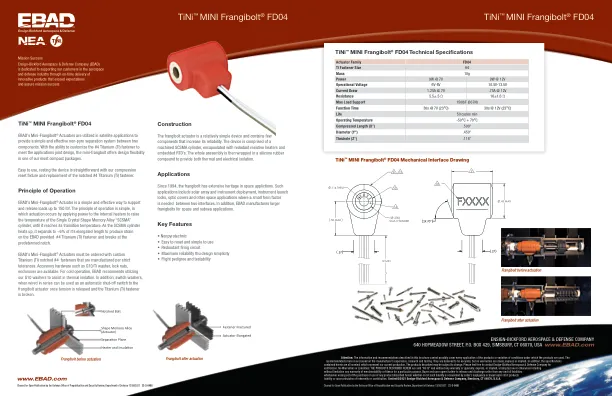

TiNi™ MINI Frangibolt® FD04

注意:本手册中描述的信息和建议不可能涵盖产品的所有应用或产品使用条件的变化。此处的建议基于制造商的经验、研究和测试。它们被认为是准确的,但不作任何明示或暗示的保证。此外,此处包含的规格均为名义规格,代表我们当前的生产。所描述的产品可能会发生变化。请随时联系 Ensign-Bickford Aerospace & Defense Company 进行验证。无保证或责任:此处描述的产品按“原样”出售,不提供任何明示或暗示的、由法律或其他方式产生的保证或担保,包括但不限于任何适销性或适用于特定用途的保证。买方和用户进一步同意免除卖方因购买或使用此处描述的任何产品而产生的任何和所有责任,无论此类责任是否由卖方的疏忽引起或基于严格的产品责任或赔偿或分担原则。内容©2021 Ensign-Bickford Aerospace & Defense Company,美国康涅狄格州辛斯伯里 06070