XiaoMi-AI文件搜索系统

World File Search System信息论对扩展的含义

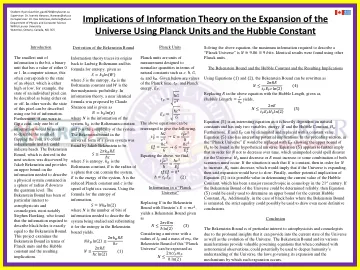

最小的信息单位是比特,即二进制单位,其值为 0 或 1。在计算机科学中,这通常对应于对象的状态,即高或低,例如,单个像素的状态可以描述为开或关。换句话说,可以使用一个信息位来描述该像素的状态。此外,如果要抛硬币,只需要一个信息位来描述抛硬币的结果,0 可以表示反面,1 可以表示正面。下一节中将推导的贝肯斯坦边界是由雅各布·贝肯斯坦发现的,它提供了描述包含在半径为 𝑅 的球体中的物理系统所需的信息上限,直至量子水平。贝肯斯坦边界一直受到天体物理学家和宇宙学家的特别关注,最著名的是斯蒂芬·霍金,他发现描述黑洞所需的信息恰好等于贝肯斯坦边界。该项目从普朗克单位和哈勃常数的角度研究贝肯斯坦边界以及由此得出的结论。

磁光数据存储 - ACM 数字图书馆

磁驱动器和光驱动器技术最显著的两个物理特性是商业产品中数据存储密度的指数增长和记录磁头跟踪介质上记录信息的轨道的机械性能。存储密度指标称为“面”密度,即介质上每单位面积的位数。据位于加利福尼亚州山景城的市场研究公司 DISK/TREND, Inc. 称,磁盘存储的面密度最近每 8 到 12 个月翻一番,而 MO 存储的面密度则每 24 个月翻一番。这一进步意味着存储信息位的成本呈指数下降 — 对客户的价值在任何其他行业都是闻所未闻的。当人们意识到驱动器中“飞行”的磁头(通过缩放)类似于一架 747 飞机在几英寸的起伏地形上飞行时,磁盘驱动器的机械操作令人震惊

1100/2200 大型机技术的历史和演变

真空管 1103 真空管中大多数都是三极管。三极管包含一个灯丝,灯丝由通过它的电流加热,并放置在靠近“阴极”的位置,阴极反过来变热,导致电子从阴极表面的稀土涂层发射出来。带负电的电子被吸引到周围带正电的阳极或“板”。当在阴极和板之间放置一个称为“网格”的细网时,它充当控制元件。网格上的负电压可以大大减少流向板的电流。通常向板上施加约 100 到 200 伏电压,网格上的约 -20 伏电压可以切断管电流。一个管壳中包含两个三极管,这一对可以构成一个触发器。一个触发器,存储一个信息位,可以设置为“一”,清除为“零”,或切换,即,改变为相反状态。后一个功能在某些逻辑和算术运算中非常方便。电容器将触发器的状态存储一小段时间,因此它不会因单个输入脉冲而切换两次。另一个三极管通常连接到每个触发器输出作为“阴极跟随器”(带有

量子通信中的位阶段误差缓解

摘要 - Quantum链接本质上是嘈杂的,量子信息位(Qubits)在0.5毫秒内的纠缠状态中遭受了13%的降解。因此,缓解错误对于多跳量子网络中可靠的端到端数据通信至关重要。与在单个量子计算机的包含环境中执行的典型操作相比,由于每个中间链路上噪声的随机变化,因此在此类计算机的分布式网络中删除了比特和相位流误差。本文介绍了一种确定比特和相纹误差(缩写为“ BIP”)的方案,并减轻它们以进行分布式和网络的量子系统。为了实现这一目标,我们使用一般误差模型对环境噪声进行建模,并在不同的计算库中获取误差校准矩阵,以实现比特相折叠误差。的结果表明,通过纠正BLOCH球体表示中的高程θ和方位角φ,BIP与已接收量的误差缓解方法相比,接收到的Qubits的忠诚度超过了95%。索引术语 - Quantum通信网络,减轻量子错误,量子计算

DNA 作为数据存储

1. 编码。通过将独特的 DNA 核苷酸组合分配给特定的二进制位来编码信息。为了防止编码重复序列(这很难准确排序),通常使用两个或多个核苷酸来编码一个信息位。2. DNA 合成(写入数据)。DNA 由 A、T、G 和 C 核苷酸按照与编码数据相对应的序列构成。3. DNA 存储。通过封装和在稳定的温度下(从室温到 -80°C)存储,DNA 可防止降解和代码错误(通常由紫外线、湿气和氧气等环境因素引起)。4. 检索和 DNA 测序(检索和读取数据)。DNA 通常通过聚合酶链式反应 (PCR) 扩增,然后进行测序以确定核苷酸的顺序。正在开发新方法(例如“随机访问”检索),以避免在只需要部分信息时对整个 DNA 池进行测序的成本。方法可以使用“引物”选择性地靶向和扩增特定的 DNA 数据序列,或使用“条形码”序列标记 DNA 的特定部分以便更快速地检索。5. 解码。测序的 DNA 被转换或“解码”为代表原始数据的二进制代码。解码之前,可以使用纠错算法来识别和纠正在合成、保存或测序步骤中可能引入 DNA 的错误。

薛定谔的猫:Qbit 还是 Cbit?

1935 年,薛定谔提出了他认为是反对量子力学哥本哈根诠释的归谬法。他的论证基于一个“荒谬的案例”,而这个案例如今被广泛用于描述量子叠加的反直觉性质。薛定谔想象把一只猫放在一个看不见的盒子里,盒子里有一个装置,可以有 50% 的概率在一小时内杀死这只猫。由于这个致命装置采用量子过程作为触发,所以他认为这只猫处于 50% 活猫 + 50% 死猫的量子叠加态。在本文中,我们指出,如果薛定谔猫实际上如人们普遍断言的那样代表了 50% 活猫 + 50% 死猫的量子叠加,那么猫盒系统就是量子信息比特 (Qbit) 的物理实例。这与哥本哈根诠释相一致,哥本哈根诠释认为,在进行测量之前,猫是死是活的事实是不存在的。因此,对于与“打开盒子”的测量(其可能的测量结果为“活猫”或“死猫”)互补的某些测量,50% 活猫 + 50% 死猫的状态必须是 100% 概率的结果。如果不能提供物理上有意义的互补测量来“打开盒子”,并以 50% 活猫 + 50% 死猫的状态作为其(确定的)测量结果所代表的明确经验结果,那么 50% 活猫 + 50% 死猫的状态仅代表该单次“打开盒子”测量的多次试验的结果分布。也就是说,50% 活猫 + 50% 死猫的状态不是量子叠加,薛定谔猫仅仅是支持薛定谔归谬的经典信息位(Cbit)的物理实例。以双缝实验作为 Qbit 的示例,说明了互补测量的含义(双缝实验中的位置 x 和动量 p)。

单量子比特垫(OQP)——基于基本纠缠的量子信息加密方案

((1)) 一百多年前,1917 年,吉尔伯特·弗纳姆发明并申请了加法多表流密码的专利,即弗纳姆密码 [1]。弗纳姆发明并在他的专利中描述了一种电传打字机加密器,其中预先准备好的密钥保存在纸带上,逐个字符地与消息组合以对其进行加密。为了解密加密信息,必须使用相同的密钥,再次逐个字符组合,从而产生解密的消息。弗纳姆专利中描述的组合函数是 XOR 运算(布尔代数或二进制和模 2 的独家替代方案,本质上是经典逻辑控制非运算,即 CNOT 门,仅丢弃控制位并留下目标位以满足不可逆布尔代数要求),应用于用于对 Baudot 码 [2](二进制编码的早期形式)中的字符进行编码的位(原始专利中的脉冲)。虽然 Vernam 在其专利技术描述中没有明确使用术语“XOR”,但他在继电器逻辑中实现了该操作。以下示例源自 Vernam 专利的描述,用 XOR 程序取代原始的电组合函数实现电传打印设备操作的逻辑:明文字符为“A”,在 Baudot 码中编码为“+ + −−− ”,密钥字符为“B”,编码为“+ −− + +”;当对明文“+ + −−− ”和密钥“+ −− + +”进行 XOR(仅当两个输入为真和假时才返回真的逻辑运算)时,得到代码“− + − + +”,在 Baudot 中读取为“G”字符;除非知道使用的密钥是字符“B”,否则无法猜测字符“G”实际上解密为字符“A”;再次对“G”(“ − + − + +”)和“B”(“+ −− + +”)进行异或,得到鲍多码“+ + −−− ”,解密后为字符“A”。在现代广义表示中,Vernam 密码对经典信息位进行操作:0 或 1。任何经典信息都可以二进制编码为 0 和 1 的序列,这当然是绝大多数当代电子设备(包括计算机和网络)运行的信息架构。让我们考虑以下示例:一条消息“Hello”,编码(UTF8)为 M=0100100001100101011011000110110001101111(每个字符 8 位,一共 40 位)。如果使用随机(无意义)密钥,例如 K=1101010110110001011101011101 001000110100,则异或加密消息(M XOR K )将显示为 E=1001110111010100000110011011111001011011,这也没有任何意义。如果密钥是真正随机且私密的,那么没有它就无法计算原始消息是什么。只有拥有密钥 K ,才能再次将加密消息 E 与密钥 K 按位异或,以返回原始消息 M 。((2)) 在专利授予 Vernam 几年后,Joseph Mauborgne(美国陆军通信兵团上尉)对 Vernam 的发明进行了修改,将密钥改为随机密钥。这两个想法结合在一起,实现了现在著名的一次性密码本 (OTP) 经典密码。仅仅 20 年后,同样在贝尔实验室工作的 Claude Shannon 在他现在奠定基础的信息论中正式证明了一次性密码本在正确使用随机密钥实现的情况下是牢不可破的(这些证明是在 1941 年二战期间完成的,并于 1949 年解密后公布 [3])。在同一篇论文中,香农还证明了任何牢不可破的(即理论上安全的)系统都必须具有与一次性密码本基本相同的特性:密钥必须与消息一样长并且真正随机(这也意味着密钥永远不会被全部或部分重复使用并且必须保密)。美国国家安全局 (NSA) 称 Gilbert Vernam 的专利(该专利催生了一次性密码本概念)“可能是密码学历史上最重要的专利之一”[4]。最近,2011 年人们发现,一量子比特密码本实际上是在 1882 年 Frank Miller 授予 Gilbert Vernam 专利的 35 年前发明的。[ ? ]。!!!!!XXX refbellovin-otp-history:Bellovin,Steven。“Frank Miller:一次性密码本的发明者”(PDF)。哥伦比亚大学。2017 年 10 月 20 日检索。((3)) 自从这些定义信息论安全经典密码学(称为私钥或对称密码学)的发现以来,基本密码学思想并没有发生太大变化。OQP 的主要问题是密钥分发(以确保通信方拥有对称密钥)。 20 世纪 70 年代,人们转向了一种名为非对称密码学(或公钥密码学)的新范式。2011 年,人们发现 One-Qubit Pad 实际上早在 1882 年 Frank Miller 向 Gilbert Vernam 颁发专利之前 35 年就已发明。[ ? ]。!!!!!XXX refbellovin-otp-history:Bellovin,Steven。“Frank Miller:一次性密码本的发明者”(PDF)。哥伦比亚大学。2017 年 10 月 20 日检索。((3)) 自从这些定义信息论安全经典密码学(称为私钥或对称密码学)的发现以来,基本密码学思想并没有发生太大变化。OQP 的主要问题是密钥分发(以确保通信方拥有对称密钥)。在 20 世纪 70 年代,人们转向了一种称为非对称密码学(或公钥密码学)的新范式,2011 年,人们发现 One-Qubit Pad 实际上早在 1882 年 Frank Miller 向 Gilbert Vernam 颁发专利之前 35 年就已发明。[ ? ]。!!!!!XXX refbellovin-otp-history:Bellovin,Steven。“Frank Miller:一次性密码本的发明者”(PDF)。哥伦比亚大学。2017 年 10 月 20 日检索。((3)) 自从这些定义信息论安全经典密码学(称为私钥或对称密码学)的发现以来,基本密码学思想并没有发生太大变化。OQP 的主要问题是密钥分发(以确保通信方拥有对称密钥)。在 20 世纪 70 年代,人们转向了一种称为非对称密码学(或公钥密码学)的新范式,