XiaoMi-AI文件搜索系统

World File Search System住院医师培训计划 - 神经外科 - 华盛顿大学

培训非常严格,我们很早就认识到,为了取得最佳结果,必须对患者护理的各个方面负责。我学会了最好的技术技能、判断力,可以做出明智的建议,并快速有效地评估患者的需求。这些技能在我的整个职业生涯中都适用于领导的各个方面。JEFFREY OJEMANN,医学博士

人工智能与判断问题

并意识到存在真正的利害关系。只有满足这些条件的实体才能实现判断的规范理想,史密斯认为这是人类在数千年和不同文化中创造的非凡成就。尽管人工智能的能力越来越令人印象深刻,但它们在于计算或推算,而不是判断(因此是这本书的标题)。史密斯坚持认为,无论是深度学习还是其他形式的第二波人工智能(或目前为第三波人工智能提出的任何建议)都不会导致任何接近真正智能的东西。史密斯并不打算提出一个新的或有争议的判断解释,但这本书的本体论反思植根于对这一概念的存在主义理解。尽管他的论点主要属于哲学中较为抽象的领域,例如心灵哲学和形而上学,但他对判断的构想以及计算与判断之间的区别具有重要的政治含义。本文旨在通过将史密斯的技术见解与马克·科克尔伯格的《人工智能的政治哲学:导论》中讨论的政治挑战进行对话来引出这些含义,重点关注判断在这两部作品中的作用。科克尔伯格的书是对人工智能政治哲学的介绍,它使用自由、平等、民主、正义和权力等基本政治概念来分析人工智能引发的社会和政治问题。如果说史密斯感兴趣的是人工智能与我们有多相似或能变得有多相似,那么科克尔伯格则可能在探索相反的问题:人工智能如何改变我们——我们的社会、制度、规范和概念——以及这些变化给我们带来了什么困境?本书的核心目标之一是反驳“技术只是一种工具”的简单观点,并阐明技术如何塑造人类的更复杂愿景。因此,当科克尔伯格着手解决判断力问题时,他关心的不是人工智能是否具有或可以具有判断力,而是在越来越依赖人工智能的社会中,我们的判断力概念会发生什么变化。在考虑这两本书提出的人工智能判断力问题时,本文将提出三个要点。首先,我认为史密斯所捍卫的存在主义判断概念是高度理想化的,要求也非常高,即使对于人类来说也是如此。其次,史密斯所关注的判断的转移并不是人工智能所独有的,而且早在人工智能出现之前就存在了。人工智能技术与将其作为智能的标准可能是合适的,但它对于何时以及如何部署人工智能的含义并不像史密斯所说的那么明确,特别是考虑到对判断的要求不那么严格的竞争对手。

了解使用大麻的健康风险

大麻含有的化学物质会改变大脑和身体的运作方式。大麻会让人上瘾,并可能损害您的健康。人们说大麻会以不同的方式影响他们的身体和精神。这可能包括改变您的免疫系统、器官、血流、呼吸、记忆和判断力。有些人确实发现医用大麻可以缓解一些疾病或副作用,这应该与您的提供者讨论。

学生在评估中使用生成AI的观点

•“以人为中心:将AI视为增强而不是替代人类洞察力,判断力和创造力的工具•以技能为中心:专注于掌握特定工具的可转移技能(即问题提出,探索,实验,批判性思维和反思)的发展。•以责任为中心:促进有效和负责使用生成AI工具。” (ACAR,2023)

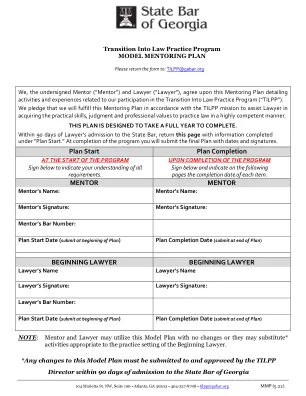

风险评估和减少,包括脂质修饰

本指南中的建议代表尼斯的观点,在仔细考虑可用证据后到达。在行使判断力时,专业人员和从业人员应充分考虑到患者或使用其服务的人的个人需求,偏好和价值观。不强制使用这些建议,并且该指南并不覆盖与他们及其家人,照顾者或监护人协商时,做出适合个人情况的责任。