XiaoMi-AI文件搜索系统

World File Search SystemCO对象名称成本元素名称名称日期注释总计

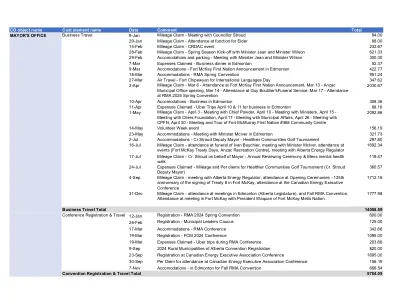

CO object name Cost element name Date Comment Total MAYOR'S OFFICE Business Travel 9-Jan Mileage Claim - Meeting with Councillor Stroud 94.00 29-Jan Mileage Claim - Attendance at function for Elder 98.00 14-Feb Mileage Claim - CRDAC event 232.67 28-Feb Mileage Claim - Spring Season Kick-off with Minister Jean and Minister Wilson 621.33 29-Feb Accomodations and parking - Meeting with Minister Jean and Minister Wilson 300.30 7-Mar Expenses Claimed - Business dinner in Edmonton 52.37 9-Mar Accomodations - Fort McKay First Nation Announcement in Edmonton 422.77 18-Mar Accommodations - RMA Spring Convention 951.24 27-Mar Air Travel - Fort Chipewyan for International Languages Day 347.62 2-Apr Mileage Claim - Mar 6 - Attendance at Fort McKay First Nation Announcement, Mar 13 - ANZAC市政办公室开业,3月14日 - 3月17日出席Guy Boutilier'sfuneral Service-参加RMA 2024 Spring Convention

视觉与深层神经网络中的内部注意机制用于图像分类和对象检测

深神经网络(DNN)中所谓的“注意机制”表示DNN的自动适应,以捕获具有特定分类任务和相关数据的代表性特征。这种注意机制通过加强特征通道和本地强调每个特征图中的特征来在全球范围内发挥作用。渠道和特征重要性是在全球端到端DNS培训过程中学习的。在本文中,我们提出了一项研究,并提出了一种具有不同方法的方法,并在训练图像旁边添加了补充视觉数据。我们使用人类的视觉注意图在任务驱动或自由观看条件下独立于心理视觉实验获得的人类视觉注意图,或者在自由观看条件下或预测视觉注意图的强大模型。我们在图像旁边添加了视觉注意图作为新数据,从而将人类的视觉注意力引入DNNS培训中,并将其与全球和局部自动注意机制进行比较。实验结果表明,DNN中的已知注意力机制几乎与人类的视觉关注在一起,但提出的方法仍然可以更快地收敛和在图像分类任务中更好地表现。

基于晶格的形状跟踪和弹性对象的宣传

摘要 - 在本文中,我们提出了一种使用机器人臂控制弹性可变形物体形状的一般统一跟踪方法。我们的方法是通过在对象周围形成晶格,将对象与晶格结合,并跟踪和宣誓晶格而不是对象的宣誓。这使我们的方法完全控制了3D空间中任何一般形式的弹性变形对象的变形(线性,薄,体积)。此外,它将方法的运行时复杂性与对象的几何复杂性相分解。我们的方法基于可行的(ARAP)变形模型。它不需要已知对象的机械参数,并且可以通过大变形将对象驱动到所需的形状。我们方法的输入是对象表面的静止形状的点云,并且在每个帧中由3D摄像头捕获的点云。总的来说,我们的方法比现有方法更广泛地适用。我们通过多种形状和材料(纸,橡胶,塑料,泡沫)的弹性变形物体进行了许多实验来验证方法的效率。实验视频可在项目网站:https://网站上找到。Google。com/view/tracking-servoing-apphack。

增强纳米对象表征的定量波前成像

HélénaAgnani,Guillaume Bachelot,Thibaut Eguether,Bettina Ribault,Jean Fiet等。类固醇生物化学与分子生物学杂志,2022,220,pp.106085。10.1016/j.jsbmb.2022.106085。hal-03972777

路边单元的标签效率3D对象检测

摘要 - 遮挡对安全至关重要的应用(例如自动驾驶)提出了重大挑战。集体感知最近引起了巨大的研究兴趣,从而最大程度地减少了闭塞的影响。尽管已经取得了重大进步,但是这些方法的渴望数据的性质为其现实世界部署带来了重大障碍,尤其是由于需要带注释的RSU数据。鉴于交叉点的数量和注释点云所涉及的努力,手动注释培训所需的大量RSU数据非常昂贵。我们通过根据无监督的对象发现为RSU设计标签有效的对象检测方法来应对这一挑战。我们的论文介绍了两个新模块:一个基于点云的空间时间聚集,用于对象发现,另一个用于改进。fur-hoverore,我们证明,对一小部分带注释的数据进行微调使我们的对象发现模型可以使用甚至超过完全监督的模型范围缩小性能差距。在模拟和现实世界数据集中进行了广泛的实验,以评估我们的方法†。

稳健的深度学习对象识别模型依赖于自然图像中的低频信息

机器学习模型很难推广到它们所训练的分布之外的数据。特别是,视觉模型通常容易受到对抗性攻击或常见损坏的影响,而人类视觉系统对此具有鲁棒性。最近的研究发现,将机器学习模型正则化以支持类似大脑的表示可以提高模型的鲁棒性,但原因尚不清楚。我们假设模型鲁棒性的提高部分归因于从神经表征中继承的低空间频率偏好。我们通过几种频率导向分析测试了这个简单的假设,包括设计和使用混合图像来直接探测模型频率敏感性。我们还研究了许多其他公开可用的鲁棒模型,这些模型是在对抗性图像或数据增强上训练的,发现所有这些鲁棒模型都表现出对低空间频率信息的更大偏好。我们表明,通过模糊进行预处理可以作为防御对抗性攻击和常见损坏的机制,进一步证实了我们的假设并证明了低空间频率信息在鲁棒物体识别中的效用。

多个对象跟踪的变压器:探索视觉

多对象跟踪(MOT)是各个领域的关键任务,例如官能分析,监视和自动驾驶汽车。联合检测和追踪范式已经进行了广泛的研究,在训练和部署经典的逐个检测范式的同时,在实现先进的性能的同时,训练和部署更快,更方便。本文通过利用现行的卷积神经网络(CNN)和新型视觉变压器技术局部性来探讨增强MOT系统的可能性。在计算机视觉任务中采用的变压器中有几种延期。虽然变形金刚擅长建模全局信息以进行长时间的嵌入,但缺少学习本地特征的局部机器。这可能导致小物体的疏忽,这可能会导致安全问题。我们将TransTrack MOT系统与localvit所赋予的局部性机制相结合,并发现该位置增强系统在MOT17数据集上比基线TransTrack优于基线转移。

深度学习的对象检测,智能轮椅医疗保健移动性的本地化和跟踪

摘要:本文介绍了智能电动轮椅的高级驾驶员援助系统(ADA)的开发,以提高残疾人的自主权。我们的用例基于正式的临床研究,基于轮椅室内环境中物体的检测,深度估计,定位和跟踪,即:门和门把手。这项工作的目的是为轮椅提供一个感知层,使以这种方式检测这些关键点在其直接周围的周围,并构建了短期寿命语义图。首先,我们将Yolov3对象检测算法的改编对我们的用例进行了改编。然后,我们使用Intel Realsense相机介绍我们的深度估计方法。最后,作为方法的第三步也是最后一步,我们根据排序算法介绍了3D对象跟踪方法。为了验证所有发展,我们在受控的室内环境中进行了不同的实验。使用我们自己的数据集对检测,距离估计和对象跟踪进行实验,其中包括门和门把手。

在不同的季节性条件下的对象检测

作者:萨穆·普洛尔(SamuPöllänen)标题:季节性条件不同的对象检测页数:26页日期:2025年2月3日:文化和艺术学位课程计划:BA专业化选项:XR设计教练:Tania Chumaira高级Lecturer Markku Luotornenen高级LuoturerLecerer Luecter lecturer lecturer lecturer

rmonocypher:使用强现代密码学易于加密R对象

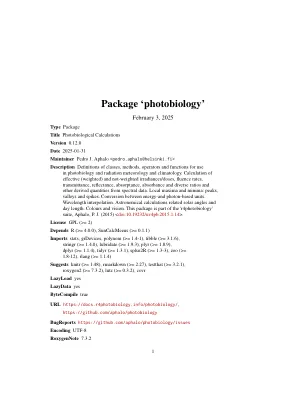

光生物包装。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。8 a.illuminant.spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。10 A2T。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。 div>。 div>11吸光度。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>12吸收。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>15 add_attr2tb。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。。。。。。。。18 AFR2T。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 21 Any2t。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 23 as.calibration_mspct。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。18 AFR2T。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。21 Any2t。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。23 as.calibration_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。24 as.calibration_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。25 as.chroma_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。26 as.chroma_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。27 as.cps_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。28 AS.CPS_SPCT。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。29 as.filter_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。30 as.filter_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。32 as.generic_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。33 as.generic_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。36 as.matrix-mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。36 AS.Object_MSPCT。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。37 as.Object_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。39 as.raw_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。40 AS.RAW_SPCT。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。41 as.reflector_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。42 as.reflector_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。44 as.Response_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。45 as.Response_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。46 as.solute_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。47 as.solute_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。49 as.source_mspct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。51 as.source_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。53 as_energy。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。54 as_quantum。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。55 AS_QUANTUM_MOL。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 55平均_spct。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 。 5655 AS_QUANTUM_MOL。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。55平均_spct。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。56