XiaoMi-AI文件搜索系统

World File Search System关于首席数字和人工智能官角色明确的备忘录

国防部研究与工程部副部长 (USD(R&E))。USD(R&E) 将为国防部制定技术和创新战略及投资 - 与国家防御战略 (NDS) 的优先事项和任务一致 - 提供技术解决方案,使作战人员能够在战场上保持技术优势。USD(R&E) 还将与 CDAO 协调,通过高级组件和开发原型设计领导与基础研究相关的数据、分析和人工智能政策。CDAO 将与 USD(R&E) 和 USD(A&S) 协调,领导国防部从操作原型设计到操作对数据、分析和人工智能的采用。CDAO 还将与 USD (R&E) 和 DOT &E 合作,领导负责任的人工智能政策和人工智能保证政策。

雷蒙德·塔利斯的《明确的动物》研究

雷蒙德·塔利斯的作品致力于理解人类的独特之处,因此经常被誉为“人文学科的警钟”。鉴于哲学在人文学科中的核心地位,这本书可以看作是对哲学在方向盘上睡着的延伸抗议。“人类的独特特征——自我、自由意志、被称为人类世界的集体空间、我们过着自己的生活而不是简单地像有机体一样生活的感觉——被许多人,甚至哲学家视为幻想而抛弃,他们应该更深入地思考,质疑科学的魅力,而不是屈服于它。”《明确的动物》致力于“使人类意识与动物意识的区别变得清晰可见”。它“反对意识的神经解释,反对一般意识,特别是人类意识,可以用进化的术语来解释为一种适应性。”

明确的键/安全键/受保护的键启动techDocid

摘要:从Z10 Microcode的最新更新开始,以及ICSF,FMID HCR7770,IBM加密硬件的新支持,支持三种键。本文介绍了清晰键,安全键和受保护的键之间的基本差异,并且是对硬件如何为安全键提供额外保护的介绍。了解这三个区域之间的差异将有助于设计正确的加密解决方案并确定加密工作的硬件要求。加密是为了保护数据的过程。使用加密算法(一系列步骤)将数据拼写,该算法由密钥控制。键是输入算法的二进制数字序列。加密的安全性依赖于保持密钥的价值为秘密。在密码学中,必须确保所有对称密钥和公共/私钥对的私钥以保护数据。对于对称键,需要保护钥匙值,以便只有两个交换加密数据的双方才能知道键的值。DES,TDE和AES算法已发布,因此键提供了安全性,而不是算法。如果第三方可以访问密钥,则可以像预期的接收者一样轻松地恢复数据。对于非对称键,必须保护私钥,以便只有公共/私钥对的所有者才能访问该私钥。公共密钥可以并且将与将向键盘所有者发送加密数据的合作伙伴共享。安全的密钥硬件要求加载主密钥。在系统z加密环境中定义键为安全键时,该密钥将由另一个称为主键的密钥保护。IBM安全密钥硬件提供篡改感应和篡改响应环境,在攻击时,将对硬件进行归零并防止钥匙值受到损害。该主密钥存储在安全硬件中,用于保护操作密钥。硬件内(通过随机数生成器函数)生成安全密钥的清晰值,并在主密钥下进行加密。当安全密钥必须离开安全的硬件边界(要存储在数据集中)时,将密钥在主密钥下进行加密。因此,加密值存储,而不是密钥的清晰值。一段时间后,当需要恢复数据(解密)时,安全的键值将加载到安全的硬件中,在该硬件中将从主密钥中解密。然后将在安全硬件内使用原始键值,以解密数据。如果安全密钥存储在CKD中,并且主密钥更改,ICSF提供了重新启动安全键的能力;那就是将其从原始的主密钥中解密,然后在新的主密钥下重新加密它,所有这些都在安全硬件中,然后将其存储回新的CKD,现在与新的主密钥值相关联。当需要与合作伙伴共享时,也可以在密钥加密密钥或运输密钥下加密安全密钥。在这种情况下,当它留下硬件的安全边界时,它将在传输密钥(而不是主密钥)下进行加密。

离线强化学习的隐式和明确的政策约束

离线增强学习(RL)旨在根据历史数据改善目标政策而不是行为政策。离线RL的一个主要问题是分配转移导致Q值估计的分布转移。大多数现有的作品都集中在行为克隆(BC)或最大化Q学习方法以抑制分布转移。BC方法试图通过将目标策略限制为离线数据来减轻转移,但它使学习的策略高度保守。另一方面,最大化Q学习方法采用悲观的机制来通过根据动作的不确定性来最大化Q值和惩罚Q值来产生动作。但是,生成的措施可能是算法的,从而导致预测的Q值高度不确定,这反过来又将误导该策略以生成下一个动作。为了减轻分配转移的不利影响,我们建议通过统一Q学习和行为克隆以应对探索和剥削难题来隐含和明确地限制政策。对于隐式约束方法,我们建议通过致力于使目标策略和行为策略的行动无法区分的生成对抗网络统一行动空间。对于显式约束方法,我们会提出多重重要性采样(MIS),以了解每个状态行动对的优势权重,然后将其用于抑制或充分使用每个状态行动对。D4RL数据集上的广泛实验表明,我们的方法可以实现出色的性能。MAZE2D数据上的结果表明,MIS与单个重要性采样更好地解决了异质数据。我们还发现MIS可以有效地稳定奖励曲线。关键字:Q学习,行为克隆,悲观机制,多重重要性采样。

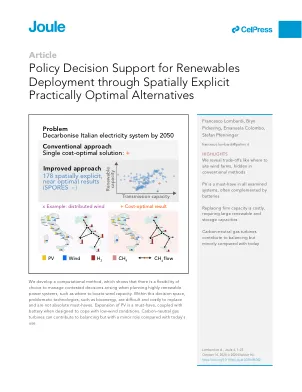

通过空间明确的可再生能源部署的政策决策支持实际上最佳替代方案

摘要设计高度可再生的电力系统涉及许多有争议的决策,例如在哪里定位生成和传输能力。然而,通常使用成本限制能源系统模型的单一结果来告知计划。这将带来更多的替代结果,例如,这可能会避免在任何一个地区的技术能力浓度。为了探索这种替代方案,我们开发了一种生成空间显式的,实际上最佳结果(孢子)的方法。将孢子应用于意大利,我们发现只有光伏和存储技术是到2050年到2050年脱碳的重要组成部分。其他决定,例如定位风能,可以选择可选的功能。大多数替代性配置对成本和需求不确定性不敏感,而应对不利天气,需要过多的可再生能力产生和存储能力。对于政策制定者来说,该方法可以提供空间详细的电力系统转换选项,从而实现在政治上可以接受的决策。

色谱分离:准备离散且定义明确的聚合物库的多功能策略

视频:离散和定义明确的聚合物的制备是模仿自然界大分子合成所获得的显着精确性的新兴策略。尽管现代受控的聚合物技术已经解锁了横跨各种单体,分子量和体系结构的材料的聚宝盆,但“控制”一词并不与“完美”相混淆。的确,即使是最高的聚合技术,由于链生长的统计学性质,不可避免地会在不可避免地会产生u = 1.05附近产生摩尔质量分散性。这种分散性会影响研究人员寻求控制软材料设计的许多属性。因此,制定最小化或完全消除分散性并获得分子精确聚合物的策略仍然是当代的关键挑战。While significant advances have been made in the realm of iterative synthetic methods that construct oligomers with an exact molecular weight, head-to-tail connectivity, and even stereochemistry via small-molecule organic chemistry, as the word “iterative” suggests, these techniques involve manually propagating monomers one reaction at a time, often with intervening protection and deprotection steps.结果,这些策略是耗时的,难以缩放,并且仍然限于较低的分子量。该帐户的重点是一种替代策略,由于其简单性,多功能性和负担能力:色谱法。■密钥参考不熟悉合成复杂性的研究人员可能会回想起在本科化学实验室中暴露于色谱法。这种操作简单但功能非常强大的技术最常见于小分子通过其选择性(差异)吸附到装有低成本固定相(通常是二氧化硅)的色谱柱上的纯化中。由于必要的设备很容易获得,并且实际分离所需的时间很少(按1小时为单位),因此色谱法在整个行业和学术界都广泛地用于小分子化学。也可能令人惊讶的是,在聚合物科学领域,类似类型的色谱也没有更广泛的利用。在这里,我们讨论了使用色谱法控制聚合物材料的结构和特性的最新进展。重点放在基于吸附的机制的实用性上,该机制基于材料科学的可拖动(克(克)尺度的极性和组成分离聚合物,与尺寸排除相比,这是非常普遍的,但通常分析的样品(〜1 mg),并且限制为摩尔质量的样品(〜1 mg)。突出显示的关键概念包括(1)将低分子量均聚物分离为具有精确链长度的离散低聚物(a = 1.0),以及(2)将块共聚物分成高素质的高素质和广泛多样的图书馆,以进行预告材料发现。总而言之,作者希望传达色谱法提供的聚合物科学中令人兴奋的可能性,作为一种可扩展的,多功能甚至自动化的技术,可以通过不同的培训和专业知识来解锁各种研究人员的新探索途径,以供各种研究人员探索良好的材料。

从“没有明确的赢家”到有效的可解释人工智能流程:一段实证之旅

如果强化学习 (RL) 代理未接受过 AI 培训,那么当领域专家试图评估 AI 的适用性时,他们应该如何向这些领域专家解释自己?为了研究这个问题,我们进行了一项有 124 名参与者参与的实验,并通过以下方式衡量他们的心智模型:(a) 他们预测 AI 行为的能力和 (b) 他们认为 AI 如何做出决策的书面“规则手册”。我们这样做是为了在简单的 RTS 游戏环境中比较参与者对 RL 代理的心智模型。我们的目标是比较参与者在四种解释配置下对 AI 代理的心智模型:(控制) 无解释;(显着性) 显着性图,解释 AI 的注意力焦点;(奖励) 奖励分解条,解释 AI 对未来奖励类型的预测;和 (一切) 显着性和奖励。这些解释如图 1 所示。为了比较这些解释配置,我们设计了一项受试者间控制实验室研究,以测量人们对 RTS 游戏中不同解释组合的反应差异。为了控制可能采取的行动空间,我们构建了自己的游戏,我们称之为 4-Towers 游戏。在 4-Towers 游戏中,

更明确的法律授权将有利于美国能源部管理贫铀的努力

美国能源部 (DOE) 环境管理办公室 (EM) 利用 COVID-19 停工对位于朴茨茅斯和帕迪尤卡的两个贫化铀六氟化物 (DUF6) 转化设施进行维护和改造。这些设施将 DUF6 转化为两种主要产品:贫化铀氧化物和氢氟酸。据 EM 称,该机构花费了约 4740 万美元进行改造,官员们表示这将提高设施的效率。EM 尚未全面评估此次停工对转化任务的影响,但官员们表示,他们正在为这些设施制定新的成本和进度估算,并将于 2022 年完成。帕迪尤卡工厂的转化作业于 2021 年 11 月重启,EM 官员告诉我们朴茨茅斯工厂的作业于 2022 年 7 月重启。

定义明确的合成共聚物与垂直醛形成生物相容性应变水凝胶,并启用竞争性配体位移

图2。PSM-CO -OMAM(共co-)聚合物的结构和表征。(a)聚合物结构显示醛平衡及其乙酰形式。(b)1 H NMR(700 MHz,d 2 O)纯化的PSM- CO-OMAM共聚物(S25 – S75)和峰分配的聚(3-磺胺甲基丙烯酸酯)均聚合物(S100)的光谱。请注意,游离醛状态(a,b,c)及其相关的乙酰形式(a*,b*,c*)的存在。在图S14中,将S25频谱作为代表性示例包括在表示a:b:c的积分比为≈1:1:1:a+a*:b+b*:c+c*是≈1:2:2。(c)纯化的S25 – S100的ATR-FTIR光谱。酰胺I和醛羧基拉伸(1637 cm -1),酰胺II带(1537 cm -1),磺酸盐(1041 cm -1)和酯(1714 cm -1)峰用点缀的线表示。S100光谱中带有星号(*)的峰与指定的酰胺I和醛峰(1648 cm -1 vs 1637 cm -1)不一致。完整的ATR-FTIR光谱可以在图S15中找到。