XiaoMi-AI文件搜索系统

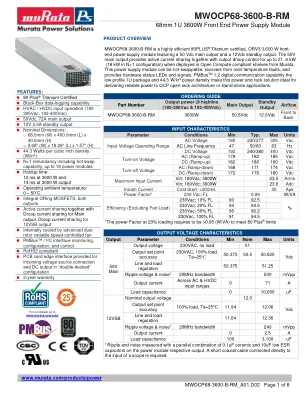

World File Search SystemMWOCP68-3600-B-RM

MWOCP68-3600-B-RM 是一款高效的 80PLUS ® Titanium 认证 ORV3 3,600 W 前端电源模块,具有 50 Vdc 主输出和 12Vdc 待机输出。当部署在 Murata 的 Open Compute 兼容机架中时,50V 主输出可提供有源电流共享以及高达 21.6 kW(N+1 配置中为 18 kW)的输出下垂控制。此电源模块可热插拔,可从过热故障中恢复,并提供硬件状态 LED 和信号。PMBus TM 1.2 数字通信功能、小型 1U 封装和 44.3 W/in3 功率密度使此电源和机架解决方案成为向 OCP 开放式机架架构或独立应用提供可靠电源的理想选择。

NEC 直接液体冷却技术

● 570 台 2U4N 服务器,用于 2,280 个双处理器节点 ● 4,560 个 AMD Epyc 7601 32 核处理器 ● 总共 145,920 个核心 ● 仅 DLC 处理器冷却回路 ● 30 个 DLC 冷却机架,配备 15 个行内冷却器 ● InfiniBand HDR 核心交换机、HDR100 边缘交换机 ● 两个带有行内冷却器的 ILC 冷却机架,用于存储系统

Okaya 电池存储

51.2V/100Ah 96V/100Ah 120V/100Ah SAP 描述 OKAYA LITHIUM BATTERY 51.2V 100AH BESS 9.6KWH (96V/100AH-30S1P) OKAYA LITHIUM BESS 120V 12KWH SAP 代码 FOJLFIE10051C93MS1 FESS00000000000002 FESSLI012110000002 电池化学性质 LFP LFP LFP 电池类型 (圆柱形/方形) 方形 方形 方形 方形 电池标称电压/Ah 3.2V / 100Ah 3.2V / 100Ah 3.2V / 100Ah 电池机架电压(V) 51.2V 96V 121.6V 电池架容量(Ah) 100Ah 100Ah 100Ah 电池架能量额定值(kWh) 5.1 kWh 9.6kWh 12kWh 机架总数 NA NA NA 每机架电池模块数量 1 1 1 机架级配置 NA NA NA 电池模块配置 16S 1P 30S 1P 38S 1P 电池总数 16 30 38 持续充电电流(A) 0.5C 0.5C 0.5C 持续放电电流(A) 0.8C 0.8C 0.8C 电池架标称电压(V) 51.2V 96V 121.6V 电池架最小电压(V) 45V±2V 90V±2V 112V±2V 电池架最大电压(V) 56V±2V 108V±2V 135V±2V BMS类型 机架级 NA NA NA BMS类型 模块级 软件 软件 软件 机架尺寸 (长*宽*高)mm 562x202x338 760x347x365 1065x535x275 电池箱类型 金属柜 金属柜 金属柜 连接器类型 SB120连接器 SB175连接器 SB50 & SB120连接器 IP等级 IP21 IP21 IP21 线径 16sqmm 25sqmm 35sqmm 重量(kg) 50 kg 100kg 125 kg 电池寿命 循环寿命 >2000@80%DOD >2000@80%DOD >2000@80%DOD

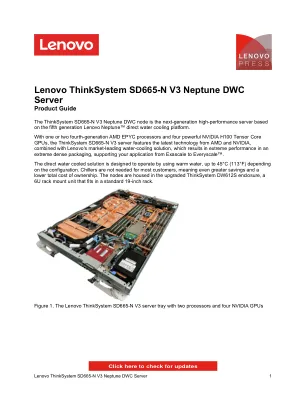

联想 ThinkSystem SD665-N V3 Neptune DWC 服务器

ThinkSystem SD665-N V3 服务器托架和 DW612S 机箱采用直接水冷,可提供最佳的数据中心冷却效率和性能。嵌入式网络芯片允许直接进行 GPU 到 GPU 通信,而无需通过 CPU 或 PCIe 交换机。这可以实现理想的扩展,从具有单个机箱和单个托架的单个机架,一直到在不到 200 个机架和不到 6,000 个节点中实现的完整持续 Exaflop 系统。

Eaton Rack PDU G4产品手册

UPDU EATON的通用输入机架PDU(UPDU)G4提供了全球灵活性的终极。基本的计量输入和托管UPDU模型可以与具有插头类型的17个输入电缆中的任何一个配对,以匹配不同区域和应用的电气标准。使用常见的PDU底盘简化机架配置并减少库存,该机箱可以在全球范围内满足许多不同的功率需求。

气候控制技术系统目录 - Rittal

机架安装式风扇像抽屉一样滑入导向框架。后部的连接器确保即时接触。导向框架的安装选项:直接在子机架中,通过 482.6 毫米 (19˝) 安装角上的两个安装支架。非常适合避免满载机柜中的热点。还可提供风扇速度监控。通过两个浮动触点发出气流减少或风扇故障的信号。

人工智能颠覆:数据中心设计的挑战与指导

AI 工作负载分为两大类:训练和推理。训练工作负载用于训练 AI 模型,例如大型语言模型 (LLM)。我们在本文中提到的训练工作负载类型是大规模分布式训练(大量机器并行运行 6 ),因为它给当今的数据中心带来了挑战。这些工作负载需要将大量数据输入到带有处理器(称为加速器)的专用服务器。图形处理单元 (GPU) 就是加速器 7 的一个例子。加速器在执行并行处理任务方面非常高效,例如用于训练 LLM 的任务。除了服务器之外,训练还需要数据存储和网络来将它们连接在一起。这些元素被组装成一个机架阵列,称为 AI 集群,该集群本质上将模型训练为一台计算机。在设计良好的 AI 集群中,加速器的利用率在大部分训练持续时间内接近 100%,训练时间从几小时到几个月不等。这意味着训练集群的平均功耗几乎等于其峰值功耗(峰值与均值比 ≈ 1)。模型越大,所需的加速器就越多。大型 AI 集群的机架密度从 30 kW 到 100 kW 不等,具体取决于 GPU 型号和数量。集群可以从几个机架到数百个机架不等,通常通过使用的加速器数量来描述。例如,一个 22,000 H100 GPU 集群使用大约 700 个机架,需要大约 31 MW 的电力,平均机架密度为 44 kW。请注意,此功率不包括冷却等物理基础设施要求。最后,训练工作负载将模型保存为“检查点”。如果集群发生故障或断电,它可以从中断的地方继续。推理意味着将之前训练的模型投入生产以预测新查询(输入)的输出。从用户的角度来看,输出的准确性和推理时间(即延迟)之间存在权衡。如果我是一名科学家,我可能愿意支付额外费用并在查询之间等待更长时间,以获得高度准确的输出。另一方面,如果我是一名正在寻找写作灵感的文案撰稿人,我想要一个可以立即回答问题的免费聊天机器人。简而言之,业务需求决定了推理模型的大小,但很少使用完整的原始训练模型。相反,部署模型的轻量级版本以减少推理时间,同时降低准确性。推理工作负载倾向于对大型模型使用加速器,并且根据应用程序的不同,可能还严重依赖 CPU。自动驾驶汽车、推荐引擎和 ChatGPT 等应用程序可能都有不同的 IT 堆栈,以“调整”其需求。根据模型的大小,每个实例的硬件要求可以从边缘设备(例如,智能手机)到几台服务器机架。这意味着机架密度可以从几台

首个太空栖息地建筑

传统的太空居住舱设计方法使环境控制和生命支持系统 (ECLSS) 效率低下。这些居住空间的设计和尺寸通常完全是任意的,与 ECLSS 元件的最佳形式、配置、位置和大小有关。机架或隔间式居住空间的有限可用性迫使 ECLSS 分布在多个模块之间以次优方式分散,或集中在单个机架中。迫使这种复杂的设备挤进预先确定大小的机架体积中,使得 ECLSS 设备的系统设计和操作变得更加困难。它增加了故障率。这种“撞合身,涂装匹配”的理念必然会导致关键生命支持元件的设计、分布、工程和安装出现严重功能障碍。潜在的“不要定尺寸/不合身”原则导致清洁、维护和维修 ECLSS 设备时出现严重困难。本文认为,ECLSS 的设计优先于所有其他系统和子系统。