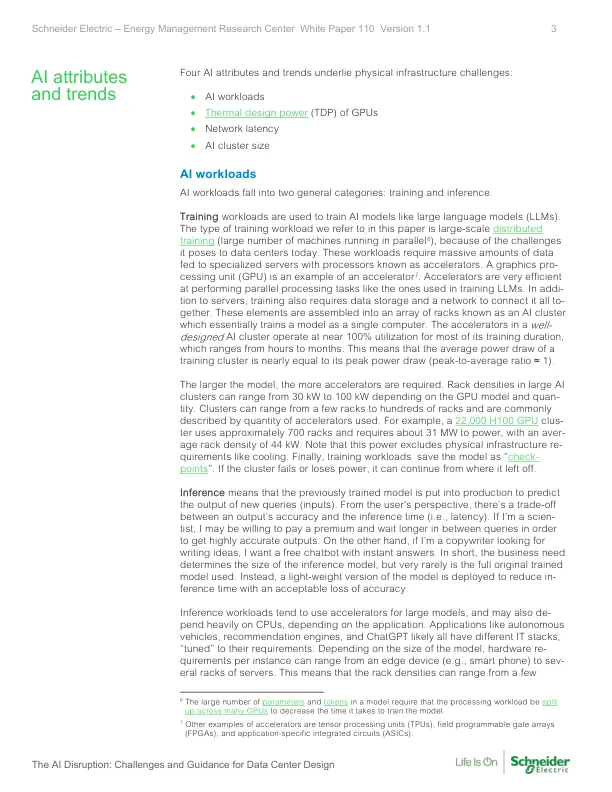

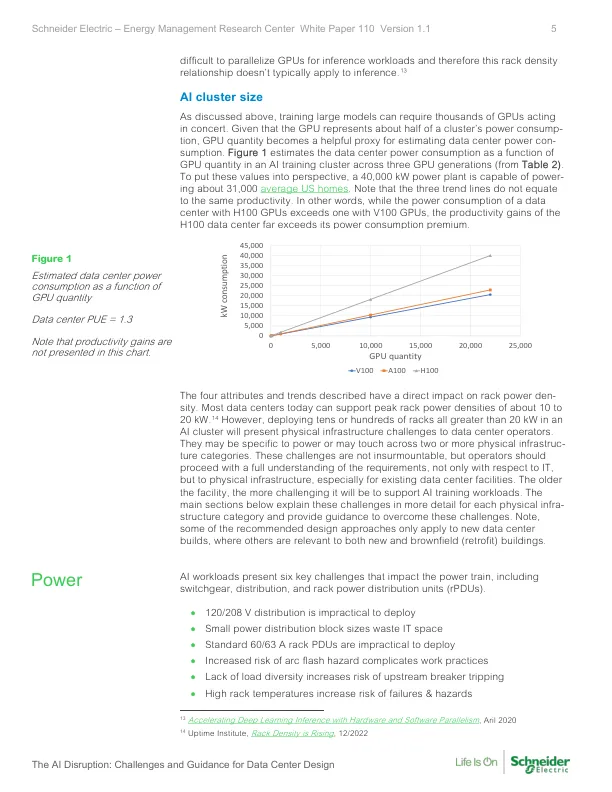

AI 工作负载分为两大类:训练和推理。训练工作负载用于训练 AI 模型,例如大型语言模型 (LLM)。我们在本文中提到的训练工作负载类型是大规模分布式训练(大量机器并行运行 6 ),因为它给当今的数据中心带来了挑战。这些工作负载需要将大量数据输入到带有处理器(称为加速器)的专用服务器。图形处理单元 (GPU) 就是加速器 7 的一个例子。加速器在执行并行处理任务方面非常高效,例如用于训练 LLM 的任务。除了服务器之外,训练还需要数据存储和网络来将它们连接在一起。这些元素被组装成一个机架阵列,称为 AI 集群,该集群本质上将模型训练为一台计算机。在设计良好的 AI 集群中,加速器的利用率在大部分训练持续时间内接近 100%,训练时间从几小时到几个月不等。这意味着训练集群的平均功耗几乎等于其峰值功耗(峰值与均值比 ≈ 1)。模型越大,所需的加速器就越多。大型 AI 集群的机架密度从 30 kW 到 100 kW 不等,具体取决于 GPU 型号和数量。集群可以从几个机架到数百个机架不等,通常通过使用的加速器数量来描述。例如,一个 22,000 H100 GPU 集群使用大约 700 个机架,需要大约 31 MW 的电力,平均机架密度为 44 kW。请注意,此功率不包括冷却等物理基础设施要求。最后,训练工作负载将模型保存为“检查点”。如果集群发生故障或断电,它可以从中断的地方继续。推理意味着将之前训练的模型投入生产以预测新查询(输入)的输出。从用户的角度来看,输出的准确性和推理时间(即延迟)之间存在权衡。如果我是一名科学家,我可能愿意支付额外费用并在查询之间等待更长时间,以获得高度准确的输出。另一方面,如果我是一名正在寻找写作灵感的文案撰稿人,我想要一个可以立即回答问题的免费聊天机器人。简而言之,业务需求决定了推理模型的大小,但很少使用完整的原始训练模型。相反,部署模型的轻量级版本以减少推理时间,同时降低准确性。推理工作负载倾向于对大型模型使用加速器,并且根据应用程序的不同,可能还严重依赖 CPU。自动驾驶汽车、推荐引擎和 ChatGPT 等应用程序可能都有不同的 IT 堆栈,以“调整”其需求。根据模型的大小,每个实例的硬件要求可以从边缘设备(例如,智能手机)到几台服务器机架。这意味着机架密度可以从几台

人工智能颠覆:数据中心设计的挑战与指导

主要关键词