XiaoMi-AI文件搜索系统

World File Search System坐标测量机:制造业的现代检测工具

在法律规定的某些条件下,图书馆和档案馆有权提供复印件或其他复制品。这些特定条件之一是,复印件或复制品不得“用于除私人学习、学术或研究以外的任何目的”。如果用户请求或随后将复印件或复制品用于超出“合理使用”的目的,则该用户可能要承担侵犯版权的责任,

为 Wikidata 构建自动破坏检测工具

Wikidata和Wikipedia一样,都是任何人都可以编辑的知识基础。这种开放的协作模型非常有力,因为它减少了参与的障碍,并允许大量人做出贡献。但是,它使知识基础暴露于故意破坏和低质量贡献的风险。在这项工作中,我们以过去的作品为基础检测维基百科的破坏行为,以检测维基达塔的故意破坏。这项工作是新颖的,因为确定结构化知识基础的破坏性变化需要与Wikipedia这样的基于文本的Wiki中的特征启动工作实质性不同。我们还讨论了这些分类者的实用性,以减少Wikidata中的故意破坏巡逻者的整体工作量。我们描述了一种机器分类策略,该策略能够捕获89%的故意破坏者,同时通过从编辑的上下文特征轻轻地汲取自编辑的特征,从而减少巡逻者的工作量98%。

T&LPC 2023 年 10 月人工智能检测工具

已移动 ( / ) T&LPC 向参议院建议,大学不支持使用 AI 检测工具来处理学生课程,以识别学术诚信问题。背景 GPT4 和其他类似技术的出现引发了高等教育内部关于人工智能对一系列学术活动(包括教学、学习和学术研究)的影响的激烈辩论。为了确保布鲁克的运营决策受益于我们重要的内部专业知识,教务长和学术副校长于今年早些时候成立了一个人工智能咨询小组。这个跨学科小组的成员名单列在本备忘录的末尾,其中包括 14 名在与人工智能相关的不同领域拥有专业知识的教职员工。根据该小组最初关注的生成式人工智能对教学实践的影响,咨询小组成员帮助制定了教学创新中心向布鲁克大学教师和学习者发布的指导意见。然而,咨询小组内部最近的讨论涉及旨在检测学生课程中人工智能使用情况的工具和技术(“人工智能检测工具”)。这是一个新出现的问题,已被确定需要澄清,特别是为了帮助那些试图评估学生课程中可能未经授权使用生成式人工智能的教师,以维护学术诚信。在教务长顾问小组讨论 AI 检测工具后,顾问小组成员参加了 2023 年 9 月 21 日的教学与学习政策委员会会议,他们在会上概述了他们向教务长强烈建议布鲁克大学不支持使用 AI 检测工具处理学生课程以识别学术诚信问题的一些理由。在上个月的教学与学习政策委员会讨论之后(以及其他相关论坛,如教务长的学术诚信顾问小组的讨论),教务长希望将该小组的建议作为正式动议进行审议(如上所述)。顾问小组成员阐述的这项动议的理由如下:

一种通用且快速的 CRISPR 脱靶位点检测工具

背景:II 型成簇的规律间隔短回文重复序列 (CRISPR) 和 CRISPR 相关蛋白 (Cas) 是一种强大的基因组编辑技术,在基因功能分析中越来越受欢迎。在 CRISPR/Cas 中,RNA 引导 Cas 核酸酶到靶位点进行 DNA 修饰。结果:CRISPR/Cas 的性能取决于精心设计的单向导 RNA (sgRNA)。然而,sgRNA 的脱靶效应会导致基因组中出现不良突变,从而限制了 CRISPR/Cas 的使用。在此,我们介绍了一种通用且快速的 CRISPR 脱靶检测工具 OffScan。结论:OffScan 不受错配数量的限制,并允许自定义原型间隔区相邻基序 (PAM),这是 Cas 蛋白的靶位点。此外,OffScan 采用 FM 索引,可有效提高查询速度并减少内存消耗。

空气处理机组和变风量箱故障检测工具现场测试结果

摘要 建筑供暖、通风和空调 (HVAC) 设备经常无法满足设计时所设想的性能预期。此类故障通常会在很长一段时间内被忽视。此外,人们对各种不同且往往相互冲突的性能指标的组合寄予了更高的期望,例如能源效率、室内空气质量、舒适度、可靠性、限制公用设施的峰值需求等。为了满足这些期望,商业和住宅建筑中使用的流程、系统和设备正变得越来越复杂。这一发展既需要使用自动诊断来确保无故障运行,又通过提供强大且足够灵活的分布式平台来执行故障检测和诊断 (FDD),从而为各种建筑系统提供诊断功能。本报告中描述的研究工作的目的是开发、测试和演示可以检测空气处理单元 (AHU) 和变风量 (VAV) 箱中常见机械故障和控制错误的 FDD 方法。这些工具的设计足够简单,可以嵌入到商业楼宇自动化和控制系统中,并且仅依赖于这些系统中常见的传感器数据和控制信号。AHU 性能评估规则 (APAR) 是一种诊断工具,它使用一组源自质量和能量平衡的专家规则来检测 f

检测卡特尔进行官员调查

竞争当局已经开发了各种工具来检测卡特尔并证实开放调查的基础。官员调查(意味着由当局本身发起的调查)源自检测工具,这些工具需要从竞争管理局(例如通过行业监控和卡特尔筛查)进行更高的积极性。人工智能等新技术还为竞争部门提供了更大的机会来改善其检测工作。本文概述了检测工具,以启动Cartel调查,包括来自拉丁美洲和加勒比海的最新趋势和经验。它通过强调竞争部门实施各种方法以相互补充并增强卡特尔检测的方法来结束。

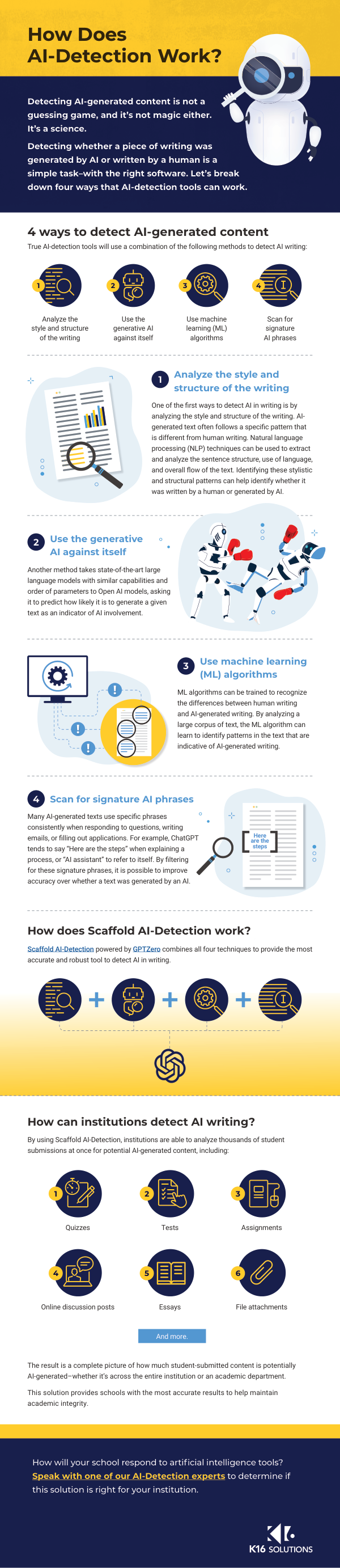

人工智能生成文本检测工具的测试

生成式预训练 Transformer 大型语言模型的最新进展强调了在学术环境中不公平使用人工智能 (AI) 生成内容的潜在风险,并加大了寻找检测此类内容的解决方案的力度。本文研究了人工智能生成文本检测工具的一般功能,并根据准确性和错误类型分析对其进行了评估。具体来说,该研究试图回答以下研究问题:现有检测工具是否能够可靠地区分人类书写的文本和 ChatGPT 生成的文本,以及机器翻译和内容混淆技术是否会影响对人工智能生成文本的检测。该研究涵盖了 12 种公开可用的工具和两种在学术环境中广泛使用的商业系统(Turnitin 和 PlagiarismCheck)。研究人员得出结论,现有的检测工具既不准确也不可靠,主要偏向于将输出归类为人类书写的文本,而不是检测人工智能生成的文本。此外,内容混淆技术会显著降低工具的性能。该研究做出了几项重要贡献。首先,它总结了该领域最新的类似科学和非科学成果。其次,它展示了迄今为止最全面的测试之一的结果,该测试基于严格的研究方法、原始文档集和广泛的工具覆盖范围。第三,它讨论了在学术环境中使用检测工具检测人工智能生成的文本的含义和缺点。