XiaoMi-AI文件搜索系统

World File Search SystemGQR-101:定量推理(i)

学分:03先决条件:零提供:本科学位(包括副学士学位)的位置:1 - 4个学期类型:强制性领域:所有描述定量推理(i)都是入门级的大学生课程,侧重于与定量概念和分析相关的基本原理。该课程旨在使学生熟悉数学和统计的基本概念,并发展学生分析和解释定量信息的能力。通过理论概念和实践练习的结合,本课程还将使学生能够培养其定量扫盲和解决问题的技能,同时有效地扩大其学术视野和对特定主要 /研究领域的知识的广泛知识。课程学习成果在本课程结束时,学生应有:1。基本的数值素养使他们能够使用数字,了解其含义并准确呈现数据; 2。理解基本的数学和统计概念; 3。基本能力解释以各种格式显示的数据,包括但不限于表,图形,图表和方程等。教学大纲1。数字素养数字系统和基本算术操作; 单位及其转换,面积,周长和体积; 费率,比率,比例和百分比; 数据的类型和来源; 测量量表; 数据的表格和图形表示; 使用数字知识进行定量推理练习。2。基本数学概念几何基础(线,角度,圆,多边形等)); 设置及其操作; 关系,功能及其图; 指数,保理和简化代数表达式; 线性和二次方程和不平等的代数和图形解; 使用基本数学概念进行定量推理练习。

GQR-2010:定量推理(II)

学分:03先决条件:定量推理(i)发行:本科学位(包括副学士学位)的位置:2 - 4个学期类型类型:强制性领域:所有描述定量推理(II)都是一条顺序的本科课程,侧重于与数学和统计学分析技术的逻辑上的逻辑上的介绍,并适用于数学和统计学分析技术,以适应数学和统计学分析技术,并适应模型分析技术,现代世界的复杂性。该课程旨在使学生熟悉中断和分析数值数据所需的定量概念和技术,并在学生中灌输能力的逻辑推理来构建和评估参数,识别谬论,系统地思考。将定量推理的先决条件(i)作为其基础,本课程将使学生能够进一步进行定量,逻辑和关键的推理能力,以补充其特定的主要 /研究领域。课程学习成果在本课程结束时,学生应有:1。对逻辑和逻辑推理的理解:2。了解基本的定量建模和分析; 3。逻辑推理技能和能力将其应用于解决定量问题并评估论点; 4。能够通过适当的计算工具进行批判性评估定量信息以做出证据决策的能力。

使用分布式变异推理

摘要 - 多机器人同时本地化和映射(SLAM)使机器人团队通过依靠环境的共同地图来实现协调的任务。通过对机器人观测的集中处理来构建地图是不可取的,因为它会产生单个失败点并重新存在预先存在的基础架构和显着的通信吞吐量。本文将多机器人对象猛击制定为通信图上的变异推理问题,受不同机器人主导的对象估计的共识约束。为了解决该问题,我们开发了一种分布式的镜面下降算法,并在通信机器人之间实施了正则化的共识。使用算法中的高斯分布,我们还为多机器人对象大满贯提供了分布式多状态约束Kalman滤波器(MSCKF)。对真实和模拟数据的实验表明,与单个机器人大满贯相比,我们的方法改善了轨迹和对象估计,同时与集中的多机器人大满贯相比,在大型机器人团队中实现更好的缩放。

离散的神经算法推理

神经算法推理旨在通过学习模型模仿经典算法的执行来捕获神经网络的计算。虽然共同体系结构具有足够的表现力,可以在权重空间中包含正确的模型,但当前的神经推理者正在努力概括分布数据。另一方面,经典计算不受分布变化的影响,因为它们可以描述为离散计算状态之间的过渡。在这项工作中,我们建议迫使神经推理者将执行轨迹保持为有限的预定状态的组合。为了实现这一目标,我们将离散和连续数据流分开,并描述它们之间的相互作用。在算法的状态转换上接受了监督训练,此类模型能够与原始算法完全保持一致。为了证明这一点,我们在多种算法问题上评估了我们的方法,并在单件任务和多任务设置中获得完美的考试成绩。此外,提出的架构选择使我们能够证明任何测试数据的学习算法的正确性。

与加固学习PA026

强化学习(RL)通过通过反复试验来学习最佳策略来玩复杂的游戏。本项目将增强性学习应用于Sudoku,这是一个具有挑战性的演绎难题,需要用数字1到9填充9x9网格,以便每行,列和3x3 Subgrid完全包含所有数字。sudoku拼图范围从轻松到硬;有些可以通过应用基本的Sudoku规则来解决,而另一些则需要复杂的策略。此外,难以立即解决困难的难题,需要预测前进的几个动作。该项目的目标是探索经过RL训练的深神经网络可以学会解决Sudoku难题,这表明RL在处理演绎推理任务中的潜力。项目代码和运行说明可在gitlab上获得:https://gitlab.fi.muni.cz/xkarmaz/sudoku-rl

带有参考物体的推理路径在大视觉模型中引起定量空间推理

尽管最近展示了视力模型的进步,但使用自然语言描述图像中复杂关系的能力,但它们对物体大小和距离进行定量研究的能力仍未得到充实。在这项工作中,我们介绍了一个手动注释的基准Q-As-Spatial Batch,其中有271个问题,旨在定量空间原因,并系统地研究了最新的VLMS对此任务的表现。我们的分析表明,对物体之间的差异的推理对SOTA VLM尤其挑战。但是,有些VLM的表现明显优于其他VLM,两个最佳性能模型之间的差距超过40点。我们还令人惊讶地观察到,当使用参考对象的推理路径在响应中自然出现时,表现最佳VLM的成功率会增加19点。受到这一观察的启发,我们开发了一种零射击提示技术,即“空间”,该技术鼓励VLMS使用参考对象作为视觉提示,从而鼓励VLMS进行定量的空间问题。通过指示VLM通过空间启示,Gemini 1.5 Pro,Gemini 1.5 Flash和GPT-4V在其理性路径中使用参考对象,将其成功率提高了40、20和30点,并显着地提高了其成功率。我们强调,可以获得这些重大改进,而无需更多的数据,模型架构修改或微调。1

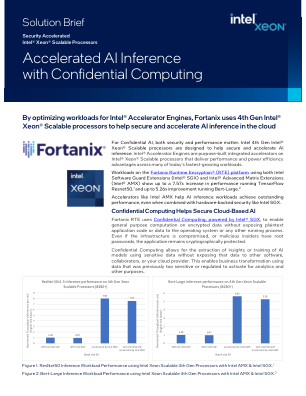

通过机密计算加速 AI 推理

声明和免责声明 1. 在搭载英特尔 SGX 和英特尔 AMX 的第四代至强可扩展处理器上运行 TensorFlow ResNet50 推理工作负载时,性能提升高达 7.57 倍。请参阅下面的配置详细信息。 2. 在搭载英特尔 SGX 和英特尔 AMX 的第四代至强可扩展处理器上运行 Bert-Large 推理工作负载时,性能提升高达 5.26 倍。请参阅下面的配置详细信息。 3. 与上一代相比,在搭载英特尔 SGX 和英特尔 AMX 的第四代英特尔至强可扩展处理器上以 INT8 精度运行 Bert-Large 推理工作负载时,性能提升高达 4.61 倍。请参阅下面的配置详细信息。 4. 在配备英特尔 SGX 和英特尔 AMX 而非 FP32 的第四代英特尔至强可扩展处理器上运行 TensorFlow ResNet50 推理工作负载时,INT8 精度下的性能提升高达 8.02 倍,BF16 精度下的性能提升高达 4.30 倍。请参阅下面的配置详细信息。5. 在配备英特尔 SGX 和英特尔 AMX 而非 FP32 的第四代英特尔至强可扩展处理器上运行 Bert-Large 推理工作负载时,INT8 精度下的性能提升高达 5.46 倍,BF16 精度下的性能提升高达 4.17 倍。请参阅下面的配置详细信息。配置详细信息测试 1:截至 2022 年 11 月 21 日,英特尔进行测试。1 节点、2x 英特尔® 至强® 铂金 8380 CPU @ 2.30GHz、40 个内核、超线程关闭、睿频开启、总内存 512 GB(16x32GB DDR4 3200 MT/s [运行速度为 3200 MT/s])、BIOS 版本 SE5C6200.86B.0022.D64.2105220049、ucode 版本 0xd000375、操作系统版本 Ubuntu 22.04.1 LTS、内核版本 6.0.6-060006-generic、工作负载/基准使用 Fortanix 在安全区域内进行深度学习推理、框架版本 TensorFlow 2.11、模型名称和版本ResNet50v1.5/Bert-Large TEST-2:截至 2022 年 11 月 21 日,英特尔进行测试。1 节点、2x 英特尔® 至强® 铂金 8480+ CPU @ 2.0GHz、56 核、超线程关闭、睿频开启、总内存 512 GB(16x32GB DDR5 4800 MT/s [运行于 4800 MT/s])、BIOS 版本 3A05、ucode 版本 0x2b000070、操作系统版本 Ubuntu 22.04.1 LTS、内核版本 6.0.6-060006-generic、工作负载/基准使用 Fortanix 在安全区域中进行深度学习推理、框架版本 TensorFlow 2.11、模型名称和版本 ResNet50v1.5/Bert-Large 性能因使用情况、配置和其他因素而异。欲了解更多信息,请访问性能指数网站。性能结果基于截至配置中所示日期的测试,可能无法反映所有公开可用的更新。有关配置详细信息,请参阅备份。没有任何产品或组件能够绝对安全。您的成本和结果可能会有所不同。英特尔技术可能需要启用硬件、软件或激活服务。© 英特尔公司。英特尔、英特尔徽标和其他英特尔标志是英特尔公司或其子公司的商标。其他名称和品牌可能是其他财产。

明确主动推理的热力学成本

摘要:在描述主动推理代理 (AIA) 时,“能量”一词可以具有两种不同的含义。一种是 AIA 利用的能量(例如,电能或化学能)。第二个含义是所谓的变分自由能 (VFE),这是一个统计量,它提供了意外的上限。在本文中,我们开发了前一个量——热力学自由能 (TFE)——及其与后者的关系的说明。我们在一个通用的量子信息理论公式中强调了这两者之间的必要权衡,以及这些权衡对生物接近其环境的方式的宏观影响。通过明确这种权衡,我们为从植物到捕食者的生物用来生存的不同代谢策略提供了理论基础。

边缘的神经形态 AI 推理

仅 2020 年,托管云工作负载的数据中心就排放了约 600 兆吨温室气体,超过整个英国 (GB) 的消耗量。除非发生根本性变化,否则到 2050 年,数据中心将消耗全球 20% 以上的能源!凭借其片上学习和低功耗、高吞吐量推理能力,我们相信 AKIDA 可以通过分散 AI 处理来帮助减少数据中心 98% 的碳排放。智能地分析片上数据将有助于终结数百万个端点向云数据中心发送的大量原始、未处理且大多不相关的数据,从而解决阻碍互联网拥塞的问题。