XiaoMi-AI文件搜索系统

World File Search SystemWen Chen 生物技术学生手册 有天赋/才华横溢的计划指南德克萨斯理工学院K-12 开放师职位 课程和教学系... 参与高科技市场的无编织研究 b'' 供应链管理专业 tingting yan 硕士学位计划和候选人资格 在AI中揭示隐私风险:数据,模型和系统 Amanda Csipak 数字农业将农艺学推向下一个绿色革命 高电阻超速带隙半导体的光电流和金属接触的特性

4。学生使用定量表达和定量推理。一个例子来说明这一点的例子来自作者在观察幼儿园课程中的经验,学生们在玩游戏,每回合都会消除一个孩子。比赛进行了几轮比赛后,老师问孩子们:“比赛中还有更多的女孩还是更多的男孩?”一个孩子回答说:“只有一半的男孩和女孩一样多。”反应不仅是正确的,而且对于幼儿园的孩子来说,这也是一种非常不寻常的定量反应。一些孩子表现出将相当长,有时复杂的言语物质转化为定量术语的能力。进行这种翻译的能力需要一定程度的抽象和设施,并具有定量表达,这对于识别很重要。

隐私和LGPD和GDPR语句

4Cybersec被深深地嵌入全球网络安全社区中;生活和呼吸信息安全的人的声音(包括世界领先的专业人员,技术专家和监管领导者)所表达的编辑内容丰富了。我们的位置是为访问者和注册帐户持有人提供时事不仅仅是当前事件的快照,而且还可以改变知情的观点,这些观点可以改变他们对信息安全和风险管理的方式。4Cybersec读者或网站访问者选择填写注册表或以其他方式选择创建帐户成为注册帐户持有人并访问我们的第三方赞助商赞助的内容。为了使我们免费提供网站上的内容访问权限,注册帐户持有人同意从我们那里接收个性化的内容,销售和营销通信,并有可能获得我们的第三方赞助商(例如,购买我们注册帐户持有人的联系人信息通过潜在客户和其他类似产品和其他类似产品和其他类似产品和其他类似产品和其他类似产品的客户)。如果您不希望从4Cybersec及其第三方赞助商那里获得个性化的内容,销售和营销传播,请不要注册帐户。您可以随时退订这些通信。

国家隐私研究战略 - NITRD

科学技术政策办公室 (OSTP) 是根据 1976 年《国家科学技术政策、组织和优先事项法》成立的,旨在为总统和总统行政办公室内的其他人员提供有关经济、国家安全、卫生、外交关系、环境、资源的技术回收和利用等方面的科学、工程和技术方面的建议。OSTP 领导跨部门科学技术政策协调工作,协助管理和预算办公室 (OMB) 每年审查和分析预算中的联邦研发,并作为总统在联邦政府主要政策、计划和方案方面的科学技术分析和判断来源。更多信息请访问 https://www.whitehouse.gov/ostp。

隐私与数据保护

圣保罗大学法律学院(USP)法学院的民法硕士学位和民法硕士。在学术领域,他是欧洲数据保护委员会(EDPB)和欧洲理事会(COE)的个人数据保护系的访客,并且是渥太华大学法律法律,技术和学会的访问者。 是“个人数据保护:同意的功能和限制”和“数据注册和保护的功能和限制:问责制的原则”的作者,以及几本书的组织者,例如“数据保护:背景,叙述和建立元素”。。在学术领域,他是欧洲数据保护委员会(EDPB)和欧洲理事会(COE)的个人数据保护系的访客,并且是渥太华大学法律法律,技术和学会的访问者。是“个人数据保护:同意的功能和限制”和“数据注册和保护的功能和限制:问责制的原则”的作者,以及几本书的组织者,例如“数据保护:背景,叙述和建立元素”。将联邦参议院法学家委员会纳入人工智能,数字整合研究委员会和透明度研究委员会在高级选举法院(TSE)的互联网平台上,并且是以TARM为重点的工作组的联合主席。目前,他是国家数据保护委员会(CNPD)的成员,被指定为民间社会组织代表中的持有人,并且是ESPM和IDP-SP的教授。是数据隐私巴西的创始总监,这是一所学校当然与隐私和数据保护领域的研究协会之间的交集空间。

时间保护隐私的数据质量评估 - ...

摘要 - 物联网(IoT)传感器的数据已成为各个领域决策过程的关键因素。但是,数据的质量对于构建的应用程序的有效性至关重要,并且对数据质量的评估非常依赖上下文。此外,在敏感数据普遍存在的领域中,在质量评估过程中保留数据的实践至关重要。本文提出了一个新颖的框架,用于从智能城市部署的物联网传感器的时间序列数据的自动化,客观和隐私的数据质量评估。我们利用自动计算的定制指标来参数时间性能,并符合声明性模式文档以实现客观性。此外,我们还利用一个受信任的执行环境来创建一个“数据盲”模型,以确保个人隐私,消除被评估人的偏见并增强跨数据类型的适应性。本文介绍了该数据质量评估方法的物联网传感器,强调了其在智能城市环境中的相关性,同时在面对广泛的数据收集实践的情况下满足了对隐私需求的日益增长的需求。索引术语 - 数据质量,智能城市,物联网,隐私,网络物理系统

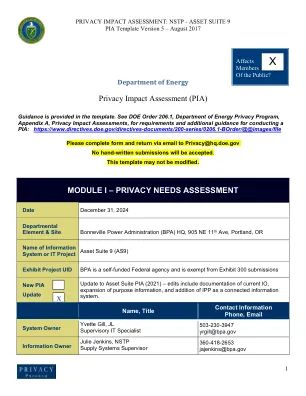

隐私影响评估 (PIA)

美国能源部第 206.1 号命令《能源部隐私计划》将 PII 定义为该部门收集或维护的有关个人的任何信息,包括但不限于教育、金融交易、病史和犯罪或就业历史,以及可用于区分或追踪个人身份的信息,例如他/她的姓名、社会安全号码、出生日期和地点、母亲的娘家姓、生物特征数据,以及包括与特定个人关联或可关联的任何其他个人信息。

在设备AI的影响:增强性能,隐私和用户体验

关于德勤·德勤(Dev),指的是Deloitte Touche Touche Touche Tohmatsu Limited,这是一家由保证(“ DTTL”)的英国私人公司,其成员公司网络及其相关实体。dttl及其每个成员公司都是法律上独立的实体。dttl(也称为“ Deloitte Global”)不为客户提供服务。在美国,德勤指的是DTTL的一家或多个美国成员公司,这些实体是使用美国使用“ Deloitte”名称的相关实体及其各自的分支机构。某些服务可能无法根据公共会计规则和规定来证明客户。请访问www.deloitte.com/about,以了解有关我们全球成员公司网络的更多信息。版权所有©2025 Deloitte Development LLC。保留所有权利。10105850

隐私国际英国CESCR -1月13日。pdf

引言本提交是在2025年2月28日至28日在2025年2月28日举行的第77届经济社会和文化权利委员会之前,就大不列颠英国和北爱尔兰遵守国际经济,社会和文化权利(ICESCR)的遵守而言。隐私国际(PI)是一个全球倡导和竞选小组,在技术与人权的交集中工作。PI运动针对利用我们的数据和技术的公司和政府。我们暴露了伤害和虐待,在全球范围内动员盟友,与公众竞选解决方案以及压力公司和政府改变。我们的提交将涵盖与ICECR的第2、7、9、11、12和13条有关的问题。

可穿戴设备安全和隐私

可穿戴设备面临的挑战,例如在空中固件更新期间动态恶意软件注入,从而利用可信赖的执行环境;由于加速裂纹技术而导致的量子式加密协议的漏洞;旨在损坏实时决策中使用的机器学习模型的对抗性人工智能攻击,导致错误分类或操作中断;混合沟通违反了BLE,NFC和5G频道的协调攻击,以损害多层安全性;使用声学加密分析和电磁分析提取敏感密码键的侧向通道攻击;通过受损的数字双胞胎创建综合身份,使得未经授权访问集成系统;以及边缘加工管道中的逻辑炸弹部署,引入在特定操作条件下激活的潜在漏洞。