XiaoMi-AI文件搜索系统

World File Search System人工智能的数字伦理

我们很高兴地通知,澳大利亚迪肯大学的 Seng Wai Loke 教授将于下周三(2021 年 5 月 26 日)下午 1:30 至 2:30 通过 Microsoft Teams 向 TME4093 学生介绍“人工智能的数字伦理”讲座。本次活动也向所有 UNIMAS 教职员工和学生开放。请通过此链接预订参加他的讲座:https://forms.gle/xB4SaDBAYmC2SpmC7 通过他的个人资料页面了解 Seng Loke 教授:https://sites.google.com/site/sengwloke/home?authuser=0

人工智能(AI)伦理

基于人工智能(AI)的技术已经取得了许多伟大的成就,例如人脸识别、医疗诊断和自动驾驶汽车。人工智能为经济增长、社会发展以及人类福祉和安全改善带来了巨大利益。然而,基于人工智能的技术的低可解释性、数据偏见、数据安全、数据隐私和道德问题对用户、开发者、人类和社会构成了重大风险。随着人工智能的进步,一个关键的问题是如何应对与人工智能相关的伦理和道德挑战。尽管“机器伦理”的概念是在2006年左右提出的,但人工智能伦理仍处于起步阶段。人工智能伦理是研究人工智能伦理问题相关的领域。要解决人工智能伦理问题,人们需要考虑人工智能的伦理以及如何构建合乎道德的人工智能。人工智能伦理研究与人工智能相关的伦理原则、规则、指南、政策和法规。道德人工智能是性能和行为符合道德的人工智能。 人们必须认识并理解人工智能可能引起的潜在伦理和道德问题,以制定人工智能必要的道德原则、规则、指南、政策和法规(即人工智能的道德规范)。有了适当的人工智能道德规范,人们就可以构建表现出道德行为的人工智能(即道德人工智能)。本文将通过研究人工智能的道德规范和道德人工智能来讨论人工智能道德规范。人工智能存在哪些已知的伦理和道德问题?一般和常见的道德问题是什么?哪些原则、规则、指南、政策和法规可以解决或至少减轻这些与人工智能有关的伦理和道德问题?合乎道德的人工智能需要具备哪些特征和特性?如何遵守人工智能的伦理道德来构建合乎道德的人工智能?

人工智能的哲学与伦理

断言这样做的机器实际上是有意识地思考(而不仅仅是模拟思考)。随着时间的推移,强人工智能的定义发生了变化,指的是所谓的“人类级人工智能”或“通用人工智能”——可以像人类一样解决任意多种任务的程序。反对智能机器可能性的批评者现在看起来像西蒙·纽科姆,他在 1903 年写道“空中飞行是人类永远无法应对的一大难题。” 同年,莱特兄弟证明了他错了,每个月都有新的进展证明弱人工智能的批评者是错误的。然而,人工智能所能实现的目标可能存在一些限制。阿兰·图灵 (1950) 是第一个定义人工智能的人,也是第一个提出对人工智能可能存在的反对意见的人,他预见到了几乎所有后来其他人提出的反对意见。

(2)法律伦理和人工智能

E.D. pa。法官约瑟夫·莱森(Joseph Leeson)在Young等人案中发出了初始程序命令 5:24CV4729,要求律师或诉讼人“使用[]任何生成的AI工具在准备要提交的任何文件中的任何生成性AI工具”才能披露和证明“使用的特定AI工具”,“使用AI的申请书,并涵盖了某些人的任何内容,并涵盖了某些人的精度,并将其确定为单位,所有引用和法律权威。”当在准备过程的任何部分(包括研究)中使用一代AI工具时,使用短语“制备”(与“起草”相对)可能表明需要披露和验证。 此外,该命令警告说,不遵守的命令可能会导致制裁,并指示当事方从“宾夕法尼亚州律师协会的共同正式意见和费城律师协会关于使用人工智能的使用的共同意见中的发现”。E.D.pa。法官约瑟夫·莱森(Joseph Leeson)在Young等人案中发出了初始程序命令5:24CV4729,要求律师或诉讼人“使用[]任何生成的AI工具在准备要提交的任何文件中的任何生成性AI工具”才能披露和证明“使用的特定AI工具”,“使用AI的申请书,并涵盖了某些人的任何内容,并涵盖了某些人的精度,并将其确定为单位,所有引用和法律权威。”当在准备过程的任何部分(包括研究)中使用一代AI工具时,使用短语“制备”(与“起草”相对)可能表明需要披露和验证。此外,该命令警告说,不遵守的命令可能会导致制裁,并指示当事方从“宾夕法尼亚州律师协会的共同正式意见和费城律师协会关于使用人工智能的使用的共同意见中的发现”。

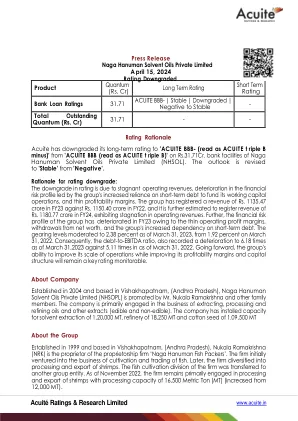

国家人工智能研发战略计划:2019年更新 - 投研数据库

2019年更新:持续对基础AI研究进行长期投资 ............................................................................................. 7 推进以数据为中心的知识发现方法 .................................................................................................................................. 9 增强AI系统的感知能力 .................................................................................................................................................... 9 了解AI的理论能力和局限性 ............................................................................................................................................ 10 开展通用人工智能研究 .................................................................................................................................................. 10 开发可扩展的AI系统 ........................................................................................................................................................ 11 促进人类AI的研究 ............................................................................................................................................................ 11 开发更强大,更可靠的机器人 ...................................................................................................................................... 11 推进硬件以改进AI ............................................................................................................................................................ 12 创建AI以改进硬件 ............................................................................................................................................................ 12 战略2:开发有效的人工智能协作方法 ................................................................................................................ 14

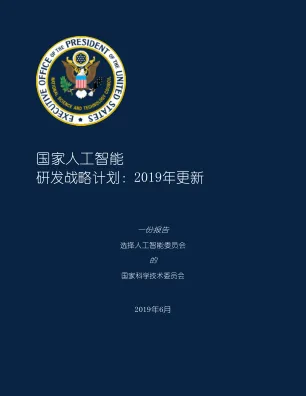

人工智能AI 及社会智慧SI 结合有效推展...

1. 定义问题(identify and define problem) 2. 找寻资料(research the need or problem) 3. 发展解决方案(develop possible solutions) 4. 选择最佳方案(select the best possible solution) 5. 制作原型(construct a prototype) 6. 测试与评估(test and evaluate the solution) 7. 沟通方案(communicate the solution) 8. 再设计(redesign) 9. 完成(completion)

国家人工智能研发战略计划:2019年更新 - 投研数据库

2019年更新:持续对基础AI研究进行长期投资 ............................................................................................. 7 推进以数据为中心的知识发现方法 .................................................................................................................................. 9 增强AI系统的感知能力 .................................................................................................................................................... 9 了解AI的理论能力和局限性 ............................................................................................................................................ 10 开展通用人工智能研究 .................................................................................................................................................. 10 开发可扩展的AI系统 ........................................................................................................................................................ 11 促进人类AI的研究 ............................................................................................................................................................ 11 开发更强大,更可靠的机器人 ...................................................................................................................................... 11 推进硬件以改进AI ............................................................................................................................................................ 12 创建AI以改进硬件 ................................................................................

放射学人工智能的伦理问题:伦理和社会影响的回顾

人工智能 (AI) 正在医学领域得到应用,以改善医疗保健并促进健康公平。基于人工智能的技术在放射学中的应用有望通过提高准确性和简化个性化决策来提高诊断性能。虽然这项技术有可能改善医疗服务,但需要仔细考虑许多伦理和社会影响,以避免对个人和团体造成有害后果,特别是对最脆弱的人群。因此,提出了几个问题,包括 (1) 在医学和生物医学研究中使用人工智能会引发哪些类型的伦理问题,以及 (2) 如何在放射学中解决这些问题,特别是在乳腺癌的情况下?为了回答这些问题,对学术文献进行了系统回顾。在五个电子数据库中进行了搜索,以查找自 2017 年以来发表的关于放射学人工智能伦理主题的同行评审文章。审查结果表明,该讨论主要解决了与医疗人工智能相关的期望和挑战,特别是偏见和黑箱问题,并且提出了各种指导原则以确保人工智能合乎道德。我们发现,人工智能应用的若干伦理和社会影响仍未得到充分探索,需要更加关注解决潜在的歧视性影响和不公正现象。最后,我们从哲学和 STS 的角度对这些问题和已发现的话语空白进行了批判性反思,强调未来在放射学人工智能发展中需要融入社会科学视角。

人工智能的哲学与伦理、人工智能的未来

1. 人工智能 2. 问题解决 3. 知识与推理 4. 不确定知识与推理 5. 机器学习 6. 交流、感知和行动 7. 人工智能的哲学与伦理

人工智能图像:人工智能伦理的盲点

摘要 本文认为人工智能伦理通常忽视了与人工智能科学传播相关的问题。特别是,本文关注的是人工智能的视觉传播,更具体地说,关注的是人工智能科学传播中某些库存图片的使用——特别是那些以过度使用蓝色和反复出现的主题为特征的图像,例如雌雄同体的面孔、半肉半电路的大脑,以及米开朗基罗的《创造亚当》的变种。在第一部分中,作者引用了“指称主义”科学传播伦理来对这些图像进行伦理评估。从这个角度来看,这些图像是不道德的。虽然科学传播伦理通常提倡谦虚和谦逊等美德,但类似的图像却是傲慢和过度自信的。在第二部分中,作者使用了法国哲学家雅克·朗西埃的“感性分布”、“分歧”和“沉思形象”的概念。朗西埃的思想为对这些人工智能形象的更深入批判铺平了道路。类似形象的问题不在于它们缺乏对“事物本身”的参考。而是在于它们扼杀了任何可能对人工智能产生分歧的形式。然而,作者认为,库存图像和其他流行的人工智能图像本身并不是问题,它们也可以是一种资源。这取决于这些图像是否真正有可能支持各种形式的沉思。在结论中,问题在于本文提出的人工智能图像伦理或政治是否可以直接应用于人工智能伦理。