XiaoMi-AI文件搜索系统

World File Search Systemecseg:自动驾驶汽车的边缘云切换图像分割

摘要 - 由于较长的车辆到云通信延迟,因此存在的自动驾驶汽车尚未利用云计算来执行其深度学习的驾驶任务。同时,这些车辆通常配备了资源受限的边缘计算设备,这些设备可能无法实时执行计算密集的深度学习模型。商业移动网络的数据传输速度的提高阐明了将云计算用于自动驾驶的可行性。我们的城市规模的现实世界测量结果表明,车辆可以通过低数据传输延迟的第五代(5G)移动网络部分使用云计算。在本文中,我们介绍了ECSEG的设计和实现,ECSEG是一个边缘云的切换图像分割系统,该系统在边缘和云之间动态切换,以实现基于深度学习的语义分割模型,以实时了解车辆的视觉场景。由于各种因素之间的复杂相互依存关系,包括动态无线通道状况,车辆的运动和视觉场景变化,因此开关决策具有挑战性。为此,我们采用深度强化学习来学习最佳的切换政策。基于现实世界实验和痕量驱动模拟的广泛评估表明,与四种基线方法相比,ECSEG可以实现自动驾驶汽车的卓越图像分割精度。

视觉对象和背景的跨文化差异...

抽象的人类视觉认知在文化之间大不相同。一个关键发现是,视觉处理是针对西方文化(美国和欧洲)以及东方文化(亚洲)背景的视觉场景的焦点。尽管迄今为止,幼儿存在一些文化差异的证据,但人类视觉认知中文化差异的个体发生起源尚未揭晓。这项研究通过跟踪12个月大的婴儿在电视范围(EEG)中视觉场景的对象与背景元素的神经特征与背景元素的神经签名在维也纳(奥地利;奥地利;一种西方文化; n = 35)和Kyoto(日本;一种东方文化; n = 36)。具体来说,我们通过以不同的刺激频率(5.67和8.5 Hz)呈现对象和背景来分离神经信号。结果表明,早期文化之间的人类视觉处理是不同的。我们发现,来自维也纳的婴儿表现出较高的物体信号,而京都的婴儿则表现出强调背景信号。人类视力中文化差异的早期出现可以部分通过早期的社会经验来解释:在一个单独的互动阶段,来自维也纳的母亲比京都的母亲更经常指出对象(与背景)要素。得出结论,采用跨文化发展的神经科学方法,我们揭示了对象和背景的视觉处理的跨文化差异在出生后的第一年就已经存在,这比以前想象的要早得多。

Cortical networks of dynamic scene category representation in the human brain

视觉神经科学的主要目的是阐明人脑在自然场景中如何代表各种信息。对场景感知的行为研究表明,人类将场景归类为更有效地处理视觉场景中的大量信息(Greene&Oliva,2009; Konkle,Konkle,Brady,Alvarez,&Oliva,&Oliva,&Oliva,2010; Rousselet,Joubert,&Fabre-Thorpe,2005年)。因此,场景类别上的信息可能在皮质上表示。与这一概念一致,以前的神经影像学研究表明,视觉场景的类别可以在基于血液氧气水平(大胆的)响应(大胆的)响应中的有限数量的基本类别(例如,海滩,森林,山脉)之间进行分类。 OPA), object-selective lateral occipital complex (LO), and anterior visual cortex ( Epstein & Morgan, 2012 ; Jung, Larsen, & Walther, 2018 ; Walther, Caddigan, Fei e Fei, & Beck, 2009 ; Walther, Chai, Caddigan, Beck, & Fei e Fei, 2011 ).这些研究中的一种常见方法是将视觉场景定义为几个非重叠类别。然而,自然场景可能显示出不同程度的统计相关性,并且在几个不同的类别下可能会表征现实世界的场景。此外,由于这些研究使用了静态场景,因此它们没有必要的工具来证明人类大脑中的动态场景类别是如何代表的。Stansbury等。要检查自然场景类别的统计数据,最近的一项研究(Stansbury,Naselaris和Gallant,2013年)使用了数据驱动的算法来采购广泛的场景,其中还考虑了这些类别之间的潜在相似性。在这种方法中,将每个场景类别定义为在自然场景中出现的大量组成对象的存在概率列表。一旦算法学习一组类别,就可以根据场景中的对象来推断给定场景属于每个学到的类别的可能性。据报道,与基于一些经常出现在提出的自然图像中经常出现的诊断对象的存在相比,与替代模型相比,经典面部和场景选择区域中单素大胆响应的预测得到了改进的预测(Stansbury et al。,2013年)。此结果提高了对象共发生统计构成场景的基础的可能性。通过其组成对象定义了静态场景的类别,并着重于经典场景选择区域中的类别响应,例如许多先前关于场景代表的研究(Epstein&Morgan,2012; Jung et al。,2018; Walther等,2009,2011,2011; Jung et al。,2018; Jung et al。然而,最近的几项研究表明,大部分前视觉皮层可能是通过对视觉场景中的动作进行差异调整来组织的(Tarhan&Konkle,2020;CáUkur,Huth,Huth,Nishimoto和Gallant,2016年)。实际上,现实世界的场景包含对象和动作之间的动态影响(Greene,Baldassano,Esteva,Beck,Beck,&Fei E Fei,

arXiv:2001.04064v1 [q-bio.NC] 2020 年 1 月 13 日

神经假体是一种精准医疗设备,其目的是以闭环方式操纵大脑的神经信号,同时接收来自环境的刺激并控制我们大脑/身体的某些部分。就视觉而言,大脑可以在毫秒间隔内处理传入的信息。视网膜计算视觉场景,然后将其输出作为神经元尖峰发送到皮质进行进一步计算。因此,视网膜神经假体感兴趣的神经元信号是尖峰。神经假体中的闭环计算包括两个阶段:将刺激编码为神经元信号,并将其解码为刺激。在这里,我们回顾了一些关于使用尖峰分析自然场景(包括静态图像和动态电影)的视觉计算模型的最新进展。我们假设,为了更好地理解视网膜的计算原理,需要对视网膜有一个超电路视图,其中应该考虑皮质神经网络中揭示的不同功能网络模式。视网膜的不同组成部分,包括多种细胞类型和突触连接,无论是化学突触还是电突触(间隙连接),使视网膜成为理想的神经网络,以适应人工智能中开发的计算技术,用于对视觉场景进行编码/解码建模。总之,我们需要一种带有脉冲的视觉计算系统方法来推动下一代视网膜神经假体作为人工视觉系统的发展。

迈向下一代视网膜神经假体

神经假体是一种精密医疗设备,旨在以闭环方式操纵大脑的神经信号,同时接收来自环境的刺激并控制人脑或身体的某些部分。大脑可以在几毫秒的间隔内处理传入的视觉信息。视网膜计算视觉场景并将其输出以神经元尖峰的形式发送到皮质进行进一步计算。因此,视网膜神经假体感兴趣的神经元信号是神经元尖峰。神经假体中的闭环计算包括两个阶段:将刺激编码为神经元信号,然后将其解码回刺激。在本文中,我们回顾了使用尖峰分析包括静态图像和动态视频在内的自然场景的视觉计算模型的一些最新进展。我们假设,为了更好地理解视网膜的计算原理,需要对视网膜进行超电路视图,在该视图中,在与视网膜交互时需要考虑皮质神经元网络中已揭示的不同功能网络模式。视网膜的不同组成部分包括多种细胞类型和突触连接——化学突触和电突触(间隙连接)——这使视网膜成为理想的神经元网络,可以采用人工智能中开发的计算技术来模拟视觉场景的编码和解码。为了推进下一代视网膜神经假体作为人工视觉系统的发展,需要采用具有神经元尖峰的视觉计算的整体系统方法。2020 作者。由爱思唯尔有限公司代表中国工程院高等教育出版社有限公司出版。这是一篇根据 CC BY-NC-ND 许可协议 ( http://creativecommons.org/licenses/by-nc-nd/4.0/ ) 开放获取的文章。

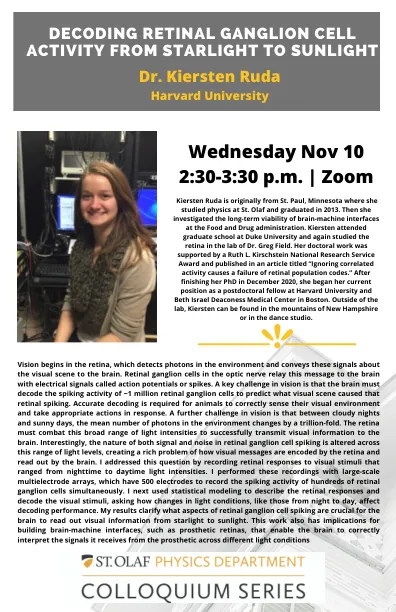

将视网膜神经节细胞活性从星光到...

视觉始于视网膜,该视网膜检测到环境中的光子,并传达有关大脑视觉场景的这些信号。视网膜神经节细胞中的视神经中继带有称为动作电位或尖峰的电信号到大脑的信息。视力中的一个关键挑战是,大脑必须解码约100万个视网膜神经节细胞的尖峰活动,以预测哪种视觉场景引起了视网膜尖峰。需要准确的解码才能正确地感知其视觉环境并采取适当的响应。在视觉中的另一个挑战是,在云彩的夜晚和阳光明媚的日子之间,环境中的平均光子数量变化了万亿倍。视网膜必须与这种广泛的光强度对抗,以成功地将视觉信息传输到大脑。有趣的是,视网膜神经节细胞峰值中信号和噪声的性质在这一光范围内发生了变化,从而使视觉信息如何由视网膜编码并由大脑读取,这给人带来了丰富的问题。我通过记录对视觉刺激的视网膜响应,从夜间到白天的光强度不等。i用大型多电极阵列进行了这些记录,它们具有500个电极,以同时记录数百个视网膜神经节细胞的尖峰活性。i接下来使用统计建模来描述视网膜反应并解码视觉刺激,询问光线条件中的变化(如夜间到夜间的变化)如何影响解码性能。我的结果阐明了视网膜神经节细胞尖峰的哪些方面对于大脑至关重要,即从星光到阳光读取视觉信息。这项工作也对建造脑机界面(例如假肢视网膜)具有影响,使大脑能够正确解释其从不同光条件上从假肢中获得的信号

第 2 课:人工智能的主要子领域及其应用

这些应用只是计算机视觉巨大潜力的冰山一角。随着机器学习、硬件功能和数据可用性的进步,该领域继续快速扩展。计算机视觉技术还在零售、游戏、增强现实、工业自动化、机器人技术和文化遗产保护等领域得到应用。随着计算机视觉的发展,我们可以期待在 3D 重建、对象跟踪、人体姿势估计、面部识别和视觉场景的语义理解等领域取得进一步突破。通过利用计算机视觉的力量,我们可以开拓视觉理解的新领域,彻底改变行业,并创造创新的解决方案,增强我们对视觉世界的感知和互动。

人类大脑在处理导航功能之前会先处理视觉特征

为了在周围环境中导航,人类会快速处理场景信息。随着时间推移,由场景观察引发的神经处理级联如何促进导航规划?为了进行研究,我们用脑电图 (EEG) 记录了人类大脑对视觉场景的反应,并将其与可操作场景处理的三个方面(2D、3D 和语义信息)的计算模型以及捕捉导航可供性的行为模型联系起来。我们发现了一个时间处理层次:导航可供性的处理晚于所研究的其他场景特征(2D、3D 和语义)。这揭示了人类大脑计算复杂场景信息的时间顺序,并表明大脑利用这些信息来规划导航。

虚拟现实中的动作观察与运动意象相结合对皮质活动的影响

简介:过去,人们使用各种技术来改善运动想象 (MI),例如沉浸式虚拟现实 (VR) 和动觉排练。虽然脑电图 (EEG) 已用于研究基于 VR 的动作观察和动觉运动想象 (KMI) 之间的大脑活动差异,但尚未研究它们的综合效果。先前的研究表明,基于 VR 的动作观察可以通过提供视觉信息和体现来增强 MI,即对自己作为被观察实体的一部分的感知。此外,已经发现 KMI 产生的大脑活动与实际执行任务相似。因此,我们假设,利用 VR 为动作观察提供沉浸式视觉场景,同时参与者进行动觉运动想象,将显著改善与 MI 相关的皮质活动。

机器人操纵与流量匹配

从使用卷积网络的传统行为克隆[1]到基于变压器的学习结构[2],广泛的研究已经对视觉场景的机器人动作轨迹进行了建模。最新的作品基于扩散模型[3]的成功,以生成运动轨迹以捕获多模式动作分布。流匹配是另一种新颖的生成方法。与随机的扩散概率模型共享理论相似性,流匹配旨在回归确定性矢量场,以将样品流向目标分布。证明,与解决扩散模型中的复杂随机微分方程相比,流动匹配目标的简单性可以在稳定的训练和发电质量中表现出色。尽管在图像生成方面取得了最新进展[4],但在机器人域中的流量匹配的应用仍未得到充满反感[5,6,7]。我们提出了流程匹配策略,以从原始视觉输入中学习模拟和现实世界的机器人行为并进行系统评估。

![arXiv:2001.04064v1 [q-bio.NC] 2020 年 1 月 13 日](/simg/b\b95c77bc974e37d4ed130c8793e2c2440c85a634.webp)