机构名称:

¥ 1.0

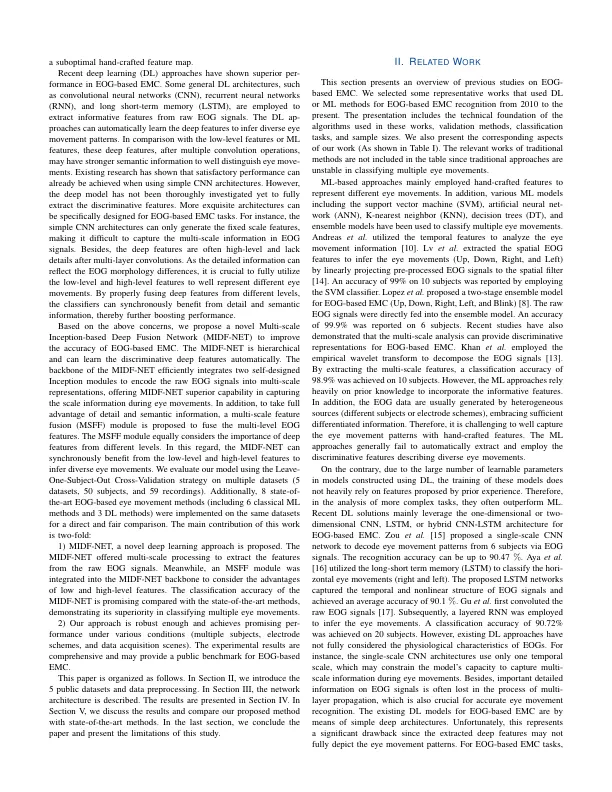

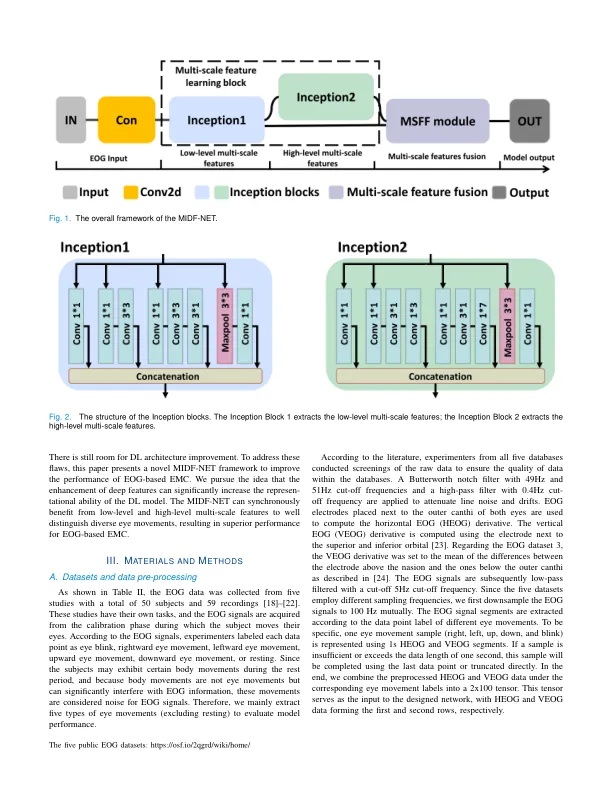

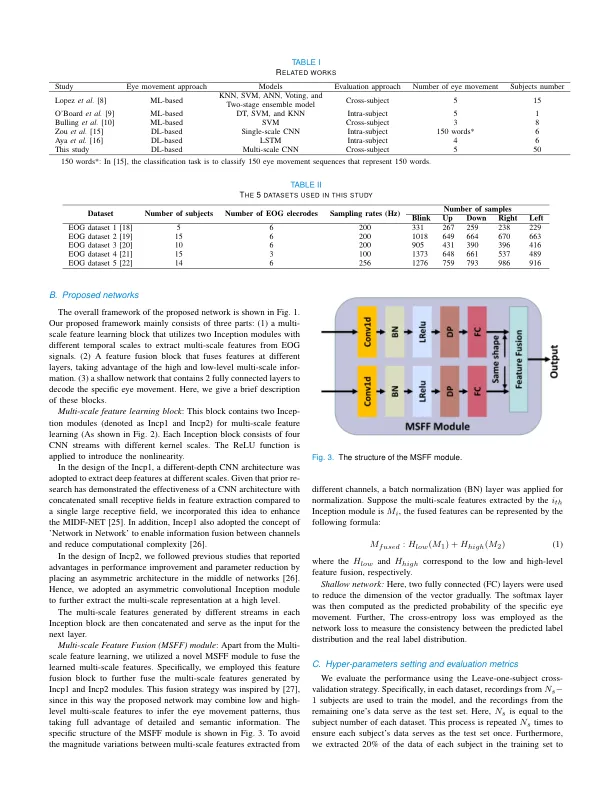

摘要 — 准确地对眼动进行分类对于人机界面、睡眠分期和疲劳检测等各种实际应用都至关重要。然而,基于眼电图 (EOG) 的眼动分类 (EMC) 仍然具有挑战性,现有的解决方案在准确性方面仍然不是最优的。传统的基于机器学习 (ML) 的方法主要关注手工制作的特征,严重依赖于 EOG 分析的先验知识。此外,大多数现有的基于深度学习 (DL) 的方法仅仅专注于提取单尺度或多尺度特征,而不考虑不同层次特征的贡献,从而限制了模型学习判别表示的能力。为了解决上述问题,提出了一种新的基于多尺度 Inception 的深度融合网络 (MIDF-NET),由并行 CNN 流和多尺度特征融合 (MSFF) 模块组成,用于从原始 EOG 信号中提取信息特征。并行的 CNN 流可以有效地提取 EOG 的多尺度表示,而 MSFF 模块融合了这些特征,利用了低级和高级多尺度特征。在 5 个公共 EOG 数据集(50 名受试者和 59 条记录)上进行了全面的实验,包含 5 种眼球运动(眨眼、向上、向下、向右和向左)。还实现了最先进的基于 EOG 的眼球运动方法,包括经典机器学习模型和深度网络,以供比较。实验结果表明,我们的 MIDF-NET 在 5 个公共数据集中实现了最高的准确率(87.7%、86.0%、95.0%、94.2% 和 95.4%),优于最先进的方法,准确率显著提高。总之,提出的 MIDF-NET 可以根据特征融合子网络综合考虑多级特征,并通过增强的 EOG 表示有效地对眼球运动模式进行分类。

基于多尺度 Inception 的深度融合网络用于眼电图眼动分类

主要关键词