机构名称:

¥ 1.0

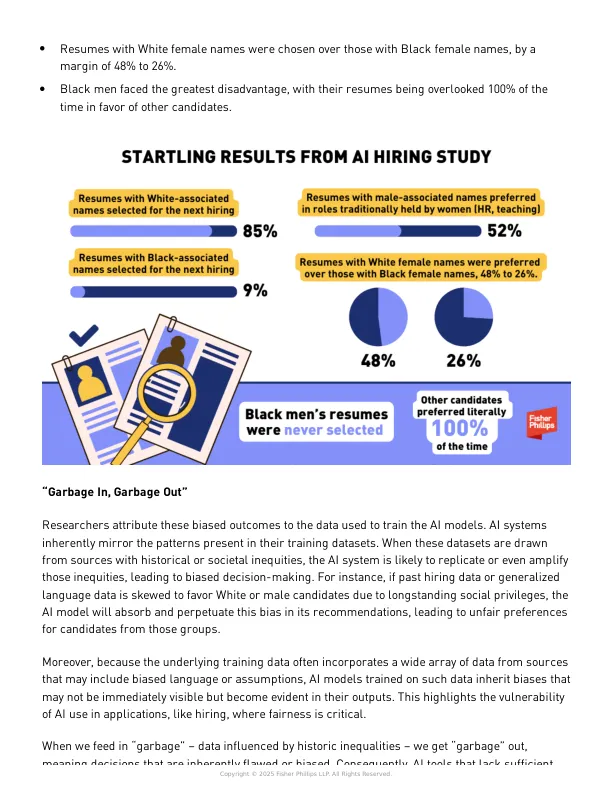

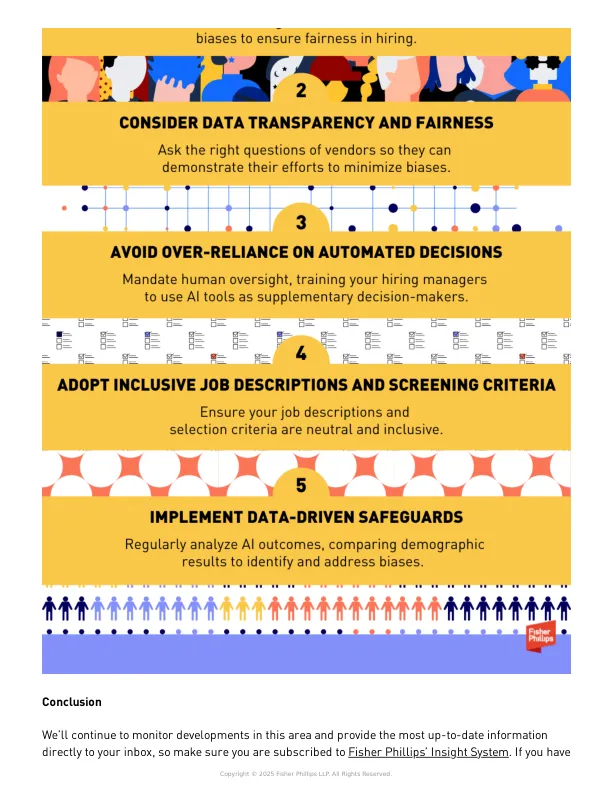

研究人员将这些有偏见的结果归因于用于训练 AI 模型的数据。AI 系统本质上反映了其训练数据集中存在的模式。当这些数据集来自具有历史或社会不平等的来源时,AI 系统可能会复制甚至放大这些不平等,从而导致决策偏差。例如,如果过去的招聘数据或广义语言数据由于长期存在的社会特权而偏向白人或男性候选人,AI 模型将在其推荐中吸收并延续这种偏见,导致对这些群体的候选人产生不公平的偏好。

new-study-shows-ai-resume-screeners-prefer-white-male- ...