机构名称:

¥ 1.0

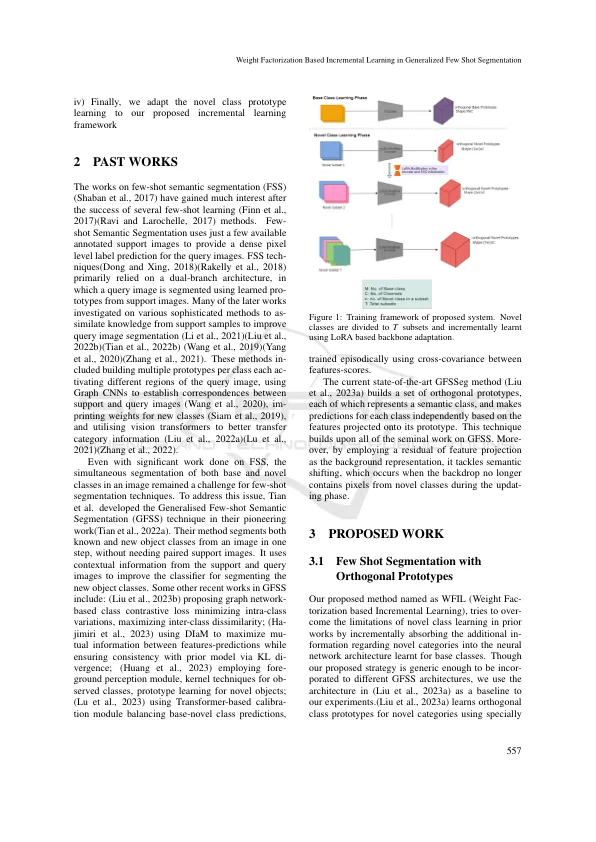

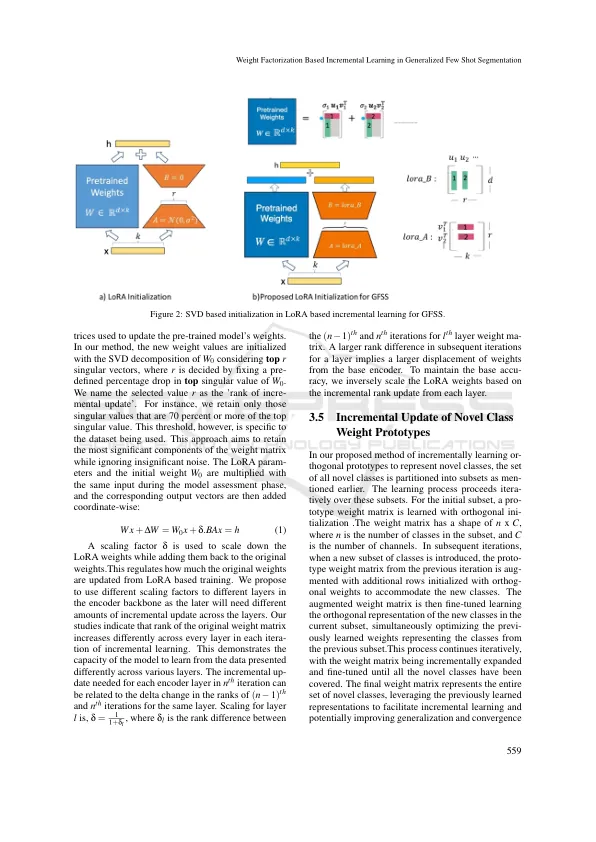

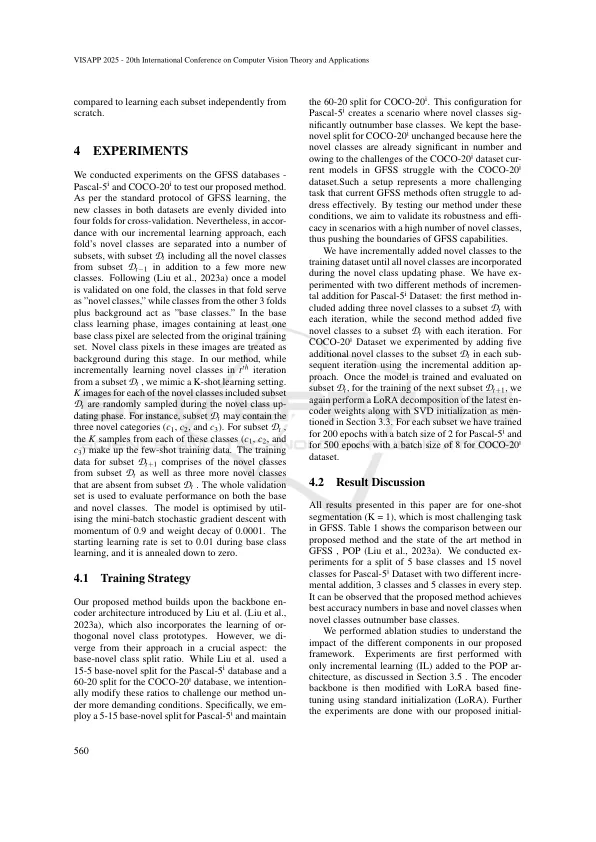

摘要:通用的很少的语义分割(GFSS)目标在学习一组基本类别的分割后,使用一些带注释的示例将新颖对象类别进行分割。典型的GFSS培训涉及两个阶段 - 基类学习,然后是新颖的课程和学习。尽管现有方法表现出了希望,但在新颖的班级数量显着时,它们通常会挣扎。大多数当前方法都冻结了编码器主链以保持基类精度;但是,冻结编码器骨架可以严重阻碍新班级中新型信息的同化。为了应对这一挑战,我们建议在GFSS中使用增量学习策略来学习编码器骨干和新型类原型。受到低级适应技术(LORA)最近成功的启发,我们通过新颖的重量分解方法向GFSS编码器主链引入了Increthorth学习。我们新提出的等级自适应权重合并策略对在编码器主链各个层中吸收的新颖性不同。在我们的工作中,我们还将增量学习策略介绍给新型类别的类原型学习。我们在Pascal-5 I和Coco-20 I数据库上进行了广泛的实验,展示了增量学习的有效性,尤其是当新颖的类人数超过基础类别时。使用我们提出的基于权重分解的增量学习(WFIL)方法,以概括性的语义分段建立了一组新的最先进的精度值。

基于重量分解的渐进学习在广义上很少的镜头分割

主要关键词