XiaoMi-AI文件搜索系统

World File Search System思维融合:机器人的个性化元学习

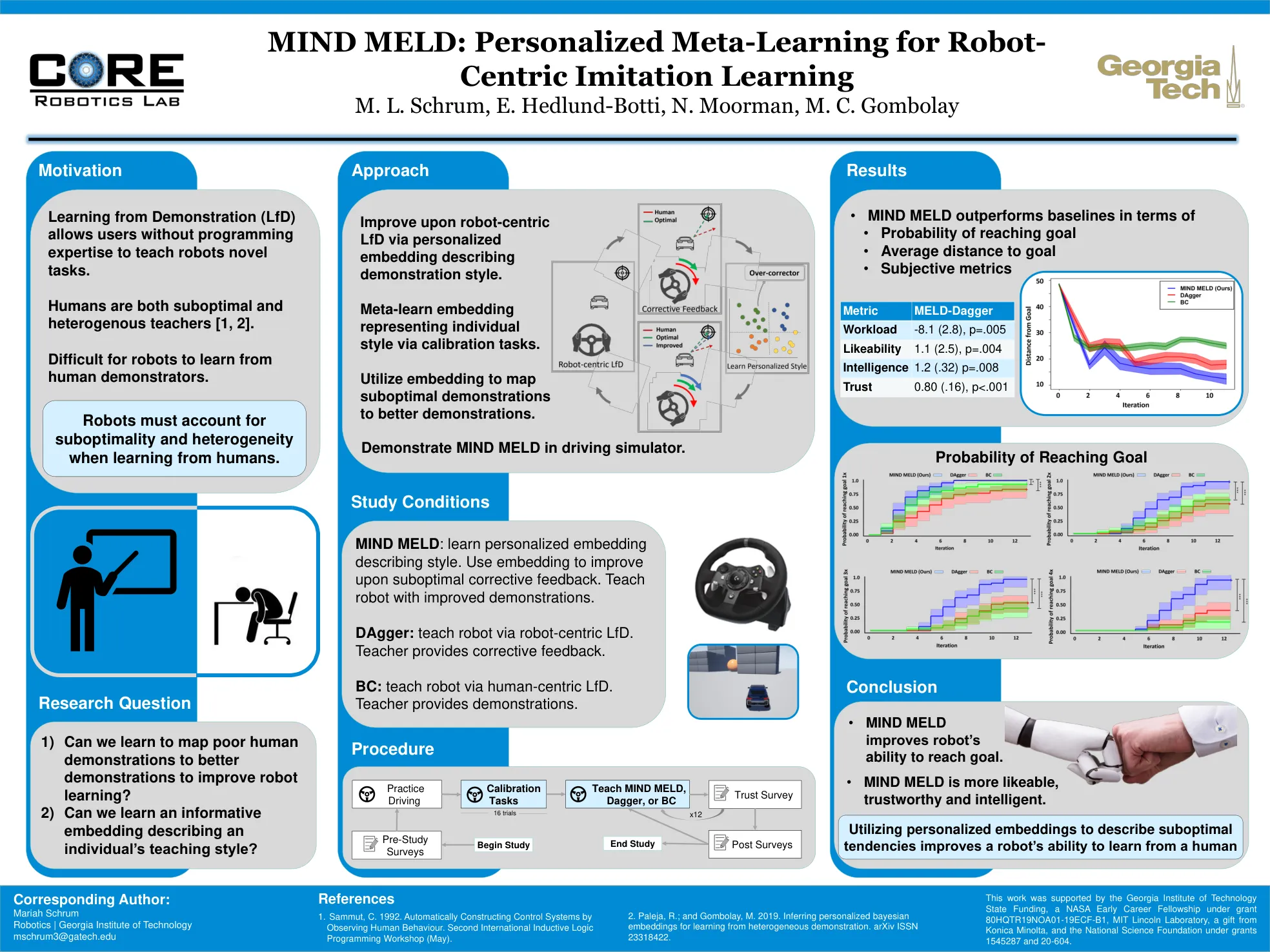

这项工作得到了佐治亚理工学院国家资助的支持,NASA的早期职业奖学金是Grant 80HQTR19NOA01-19ECF-B1,MIT Lincoln实验室,Konica Minolta的礼品,以及国家科学基金会的礼物,根据Grants 1545287和20-604。

使用基于元学习的深度学习模型推断麻醉状态下的大脑状态

摘要 — 监测麻醉期间的意识深度对于临床环境和神经科学研究都有助于了解大脑机制。脑电图 (EEG) 已被用作实时表征麻醉剂引起的大脑改变的唤醒和/或认知状态的客观手段。不同的全身麻醉剂以不同的方式影响脑电活动。然而,由于 EEG 信号的信噪比 (SNR) 低,尤其是在办公室麻醉 EEG 环境中,传统机器学习模型在 EEG 数据上的表现并不令人满意。深度学习模型因其良好的泛化和处理噪声的能力而被广泛应用于脑机接口 (BCI) 领域以执行分类和模式识别任务。与其他深度学习已显示出令人鼓舞的结果的 BCI 应用相比,用于对麻醉下不同大脑意识状态进行分类的深度学习方法的研究要少得多。在本文中,我们提出了一种基于元学习的新框架,使用深度神经网络对麻醉状态下的大脑状态进行分类,即 Anes-MetaNet。Anes-MetaNet 由卷积神经网络 (CNN) 组成,用于提取功率谱特征,基于长短期记忆 (LSTM) 网络的时间后果模型用于捕获时间依赖性,以及元学习框架用于处理跨主体的大量差异。我们使用多阶段训练范例来提高性能,这可以通过可视化高级特征映射来证明。通过与现有方法进行比较,在办公室麻醉脑电图数据集上进行的实验证明了我们提出的 Anes-MetaNet 的有效性。

使用元学习优化量子启发式方法

摘要 变分量子算法是一类量子启发式算法,是展示有用量子计算的有希望的候选算法。找到在硬件上放大这些方法性能的最佳方法是一项重要任务。在这里,我们使用一类称为“元学习器”的现有技术来评估量子启发式算法的优化。我们在三个模拟环境中的三个问题上,针对两种量子启发式算法(量子交替算子 ansatz 和变分量子特征求解器),比较了元学习器与进化策略、L-BFGS-B 和 Nelder-Mead 方法的性能。我们表明,在嘈杂的参数设置环境中,元学习器比我们测试的所有其他优化器更频繁地接近全局最优值。我们还发现,元学习器通常更能抵抗噪音,例如,在嘈杂和采样环境中,性能下降幅度较小,并且“增益”指标的平均表现优于其最接近的竞争对手 L-BFGS-B。最后,我们提供了证据表明,在小问题上训练的元学习器将推广到更大的问题。这些结果是一个重要的迹象,表明元学习和相关的机器学习方法将成为近期嘈杂量子计算机有用应用不可或缺的一部分。

脑机接口中用于脑电图运动意象解码的模型无关元学习

摘要 — 我们在此介绍了用于训练 EEG BCI 解码器的元学习理念。元学习是一种训练机器学习系统使其学会学习的方法。我们将元学习应用于简单的深度学习 BCI 架构,并将其与同一架构上的迁移学习进行比较。我们的元学习策略通过寻找 BCI 解码器的最佳参数来运行,以便它可以在不同用户和记录会话之间快速推广 - 从而也可以快速推广到新用户或新会话。我们在 Physionet EEG 运动意象数据集上测试了我们的算法。我们的方法将运动意象分类准确率提高了 60% 到 80%,在小数据条件下优于其他算法。我们相信,建立元学习或学习学习方法将有助于神经工程和人机交互应对快速设置神经信号解码器的挑战,使其更适合日常生活。

股票交易进化策略的元学习

元学习算法可以了解学习过程本身,因此它可以用更少的数据和迭代次数加速后续类似的学习任务。如果能够实现,这些好处将把传统机器学习的灵活性扩展到时间窗口或数据可用的领域。股票交易就是这样一个领域,随着时间的推移,数据的相关性会降低,需要在更少的数据点上快速获得结果以应对快速变化的市场趋势。据我们所知,我们是第一个将元学习算法应用于股票交易的进化策略的人,通过使用更少的迭代次数来减少学习时间,并用更少的数据点获得更高的交易利润。我们发现,我们的股票交易元学习方法获得的利润与纯进化算法相似。但是,它在测试期间只需要 50 次迭代,而没有元学习通常需要数千次,或者在测试期间需要 50% 的训练数据。

人工神经网络超级学习的元学习...

摘要。紧凑型μ子螺线管 (CMS) 是欧洲核子研究中心大型强子对撞机 (LHC) 的通用探测器之一,它收集了大量的物理数据。在进行最终的物理分析之前,必须通过一系列自动(如物理对象重建、直方图准备)和手动(检查、比较和决策)步骤检查数据的质量(认证)。决策的最后一个手动步骤非常重要,容易出错,需要大量人力。决策(认证)目前正在计算机科学领域积极研究,以通过应用计算机科学的最新进展,特别是机器学习 (ML) 来实现自动化。归根结底,CMS 数据认证是一个二元分类任务,其中正在研究各种 ML 技术的适用性。就像任何其他 ML 任务一样,超参数调整是一个难题,没有黄金法则,每个用例都不同。本研究探索了元学习的适用性,它是一种超参数查找技术,其中算法从以前的训练实验中学习超参数。进化遗传算法已用于调整神经网络的超参数,如隐藏层数、每层神经元数、激活函数、辍学、训练批量大小和优化器。最初,遗传算法采用手动指定的超参数集,然后向接近最优解发展。应用遗传随机算子、交叉和变异来避免局部最优解。本研究表明,通过仔细播种初始解决方案,很可能会找到最优解。所提出的解决方案提高了用于 CERN CMS 数据认证的神经网络的 AUC 分数。类似的算法可以应用于其他机器学习模型的超参数优化。