XiaoMi-AI文件搜索系统

World File Search System通过动物和人工智能改善人类集体决策

虽然集体决策(例如投票系统)是人类社会的基础,但正如过去的气候政策所表明的那样,它可能导致低效的决策。当前的系统因其考虑选民需求和知识的方式而受到严厉批评。集体决策是人类社会的核心,但也发生在动物群体中,主要是当动物需要选择何时何地迁徙时。在这些社会中,动物在群体成员的需求和自身需求之间取得平衡,并依赖于每个人的(部分)知识。我们认为,非人类动物和人类有着相似的集体决策过程,其中包括议程设置、审议和投票。人工智能领域最近的研究试图改善人类群体的决策,有时受到动物决策系统的启发。我们在这里讨论了我们的社会如何从动物行为学和人工智能的最新进展中受益,以改善我们的集体决策系统。

神经科学和气候作用:与大脑的相交途径

气候危机和人脑都复杂地联系在一起。气候变化会影响神经认知健康,而气候作用既形状又由大脑塑造。但是,研究这些联系的研究仍然很少。本评论强调了神经科学如何加深对气候作用与大脑之间相互关系的理解。首先,我们讨论个人和集体的气候行动如何直接和间接地使我们的大脑健康,心理健康和认知功能受益,以及强调这如何具有收获自我利益作为变革的驱动力的潜力。第二,我们探讨了大脑的情感和决策系统在激励气候行动中的作用。我们还讨论了神经科学预测人口水平行为并有助于系统发展的潜力。通过解决当前的知识差距,我们确定了加深对气候动作与大脑之间交织的联系的理解的下一步。

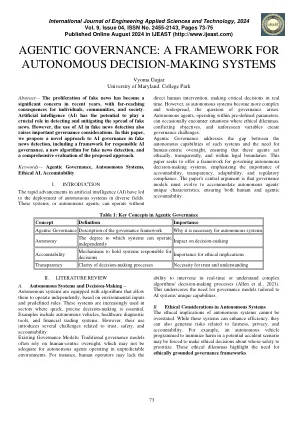

代理治理:自治决定的框架...

直接人类干预,实时做出关键决策。但是,随着自主系统变得更加复杂和普遍,治理问题就会出现。自主代理在预定义的参数中运行,有时会遇到道德困境,目标相互矛盾的目标和不可预见的变量会带来治理挑战的情况。代理治理解决了此类系统的自主能力与对以人为本的监督的需求之间的差距,以确保这些代理人在道德,透明和法律范围内行事。本文旨在为管理自主决策系统提供一个框架,强调问责制,透明度,适应性和法规合规性的重要性。本文的中心论点是,治理模型必须发展以适应自主代理的独特特征,以确保人类和代理责任。

岛健康研究道德与合规办公室

1.0什么是人工智能(AI)系统和自动决策系统?人工智能系统是一种技术系统,该系统是自主或自主的,通过遗传算法,神经网络,机器学习或其他技术来生成内容或做出决策,建议或预测(《数字宪章实施法》,2022年),通过遗传算法,神经网络,机器学习或其他技术来处理与人类活动有关的数据。通过使用基于规则的系统,回归分析,预测分析,机器学习,深度学习,神经网络或任何其他技术来帮助或取代人类决策者的判断的技术来自动化决策系统。2.0您的AI相关工作研究或质量改进(QI)? Island Health是加拿大政府的三个机构资金的接受者。 作为资金的条件,这些机构要求研究人员及其机构采用伦理原则和三委员会政策声明的条款:涉及人类研究的伦理行为(TCP:2022),并以其文章的应用程序为指导。 按照研究机构对代理机构授予和奖励的协议的4.3,岛上的健康必须确保其主持人进行的研究符合TCPS2,并确保通过使用财务或其他控制,确保该机构的研究伦理委员会(“ reb”的研究涉及研究范围,涉及研究的责任,该活动的范围涉及研究,而批准了研究的责任。人类是进行的。2.0您的AI相关工作研究或质量改进(QI)?Island Health是加拿大政府的三个机构资金的接受者。作为资金的条件,这些机构要求研究人员及其机构采用伦理原则和三委员会政策声明的条款:涉及人类研究的伦理行为(TCP:2022),并以其文章的应用程序为指导。按照研究机构对代理机构授予和奖励的协议的4.3,岛上的健康必须确保其主持人进行的研究符合TCPS2,并确保通过使用财务或其他控制,确保该机构的研究伦理委员会(“ reb”的研究涉及研究范围,涉及研究的责任,该活动的范围涉及研究,而批准了研究的责任。人类是进行的。

数据科学中的道德考虑:评论

隐私漏洞案件,这主要是因为与数据的匿名和存储有关的问题。算法偏见:决策系统中的算法偏见为现有不公正提供了很大的空间。最近进行的许多研究反映了有偏见算法的强烈影响,尤其是在诸如正义和招聘等敏感领域内应用时。缺乏透明度:许多算法用作“黑匣子”。用户和利益相关者由于缺乏从这种算法做出的决定所涉及的透明度而感到困惑。缺乏透明度会增加对自动化系统的不信任。问责制挑战算法失败的问责制是一个复杂的问题。在这种情况下,有许多利益相关者或实体负责。但是,如果发生不希望的事情,很难指出谁应该指责。进一步的研究需要数据科学伦理继续发展,并且需要持续的研究来确定新兴的道德问题,因为新技术和方法正在开发中。跨学科解决方案

大数据警务中的不同影响

数据驱动的决策系统正在接管。社会上没有机构似乎不受自动决策产生的热情,包括警察,包括,尤其是警察。警察部门越来越多地部署数据挖掘技术来预测,预防和调查犯罪。,但是所有数据挖掘系统都有对弱势社区的不利影响,预测性警务也没有什么不同。通过参考商业和社会数据来确定个人的威胁水平可以不适当地将深色皮肤与更高的威胁水平联系起来,或者更加怀疑犯了特定犯罪。基于历史数据的犯罪制图可能会导致更多因有色人种所占的社区的滋扰犯罪而造成更多逮捕。这些效果是技术本身的工件,即使是使用它的警察部门的真诚也可能发生。同时,预测性警务是作为一种“中性”方法出售,以抵消无意识的偏见,而当它不简单地

政府自动化,透明度和商业秘密

在政府部门中,自动决策系统(“ ADMS”)的使用越来越多地引起了各种问题。其中之一是政府算法缺乏透明度,尤其是在第三方开发时。文章探讨了政府自动化技术的专有利益,例如商业秘密,围绕ADMS的影响透明度,以及可以采取哪些措施来维护自动化时代的政府透明度。E文章专注于新南威尔士州作为案例研究,并探讨了《 2009年政府信息(公共访问)法》(NSW)(“ GIPA法”)中的差距,以确保在政府自动化背景下透明度。建议通过以下方面解决当前的立法差距:(1)根据《 GIPA法》规定的商业秘密保护; (2)提高第三方持有的政府信息的访问(例如政府承包商); (3)确保政府利用其采购能力获得对公共透明目的至关重要的信息。

使用选择性搜索和脉冲耦合神经网络特征提取进行脑肿瘤检测

摘要。基于磁共振图像 (MRI) 分析识别脑中的肿瘤组织是一项具有挑战性且耗时的任务,高度依赖于放射科医生的专业知识。由于肿瘤的及时诊断往往是患者生存的固有因素,因此,减少花在 MRI 手动分析上的时间,同时提高检测过程的准确性至关重要。为了解决这些问题,许多研究工作已经调查了高效的计算机视觉系统。它们为协助医疗保健提供者建立快速、更准确的肿瘤检测、分类和分割提供了新的机会。然而,这些解决方案通常基于深度学习方法,开发和调整这些解决方案仍然耗时耗力,同时导致决策系统缺乏可解释性。在本研究中,我们通过使用选择性搜索 (SS) 算法结合简化的脉冲耦合神经网络 (PCNN) 进行视觉特征提取和检测验证来解决脑肿瘤检测任务,以应对这些问题。

美国公民自由联盟白皮书:医疗保健领域的人工智能可能会加剧医疗种族主义

人工智能和算法决策系统在刑事司法系统、教育、招聘、住房和其他领域中的应用越来越普遍。每天似乎都会出现有关人工智能工具如何延续和强化种族主义和历史偏见的新头条新闻:存在缺陷的面部识别工具导致又一次错误逮捕一名黑人;商业产品中常用的语音识别系统在识别非白人顾客的言语方面表现更差;某社交媒体平台的图像识别算法再次将黑人贴上了灵长类动物的标签。然而,人们对医疗保健和医学领域的算法偏见问题关注得还远远不够,而这些工具在这些领域也已大量出现。医疗保健中的决策可能会产生严重后果,在某些情况下甚至会给患者带来生死攸关的后果。因此,关注如何识别、改善和适当监管医疗保健领域的自动化偏见尤为重要。

可解释的人工智能的法律框架

第二,我们讨论法律,技术和行为因素如何提供有关在哪种背景下使用我们的法律-XAI分类法的解释的指导。以信用评分为例,我们演示了法律如何规定可以将哪种类型的解释方法用于特定算法决策系统。我们展示了法律,计算机科学和行为原则的结合如何指导决策者,法律学者和计算机科学家为特定法律领域选择正确的解释方法。第三,我们证明了如何将我们的法律-XAI分类法应用于包括医疗补助,高等教育和自动决策在内的各个领域。我们认为,在创建解释权时,决策者应该更具体。自动化的决定通常可以用大量的解释方法来解释,决策者应指定哪些解释应必须提高决策者的政策目标。我们的法律-XAI分类法可以帮助决策者根据其政策目标确定正确的解释方法。